1 - Introdução à Estatística Avançada

1.1 Visão geral do curso

1.2 Revisão de conceitos fundamentais

Bem-vindo ao curso Estatística Avançada com Python da CIEDA!

Este curso foi elaborado para atender a estatísticos, sejam estudantes, graduados, mestres, doutores, e também a outros profissionais que desejem aprofundar seus conhecimentos em estatística e explorar técnicas avançadas de análise de dados, com exemplos usando a linguagem Python.

Nesta seção introdutória, forneceremos uma visão geral do conteúdo abordado no curso, destacando os principais tópicos e conceitos que serão explorados em profundidade ao longo dos próximos capítulos. Em cada um, você encontrará explicações detalhadas dos métodos estatísticos, juntamente com exemplos práticos e estudos de caso do mundo real.

Nosso objetivo é fornecer uma compreensão sólida e abrangente de técnicas estatísticas avançadas, bem como capacitar você a aplicá-las em problemas complexos de análise de dados. Antes de mergulharmos nos tópicos avançados, começaremos com uma revisão abrangente dos conceitos fundamentais da estatística.

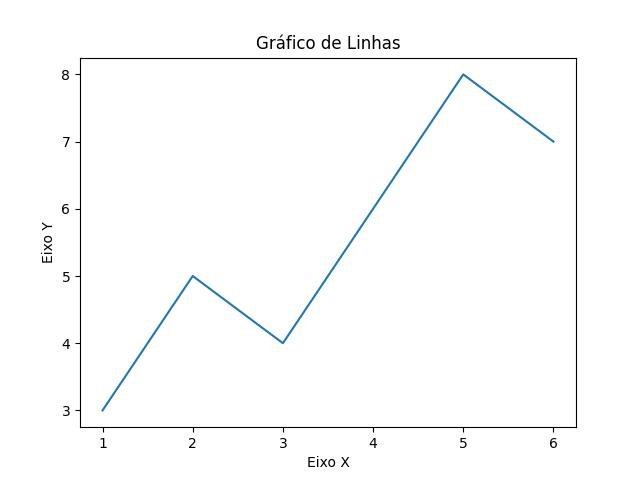

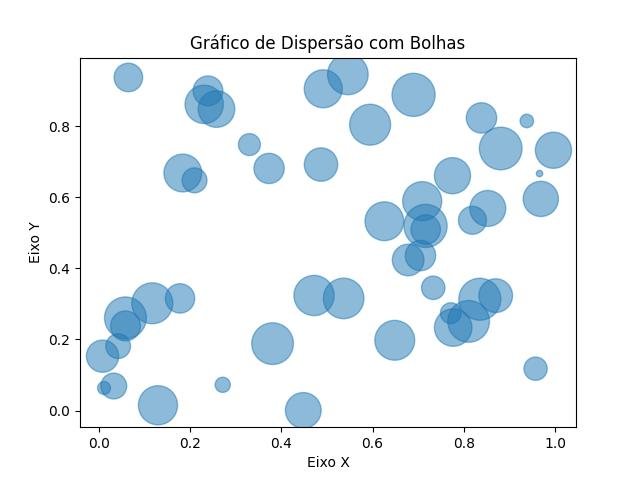

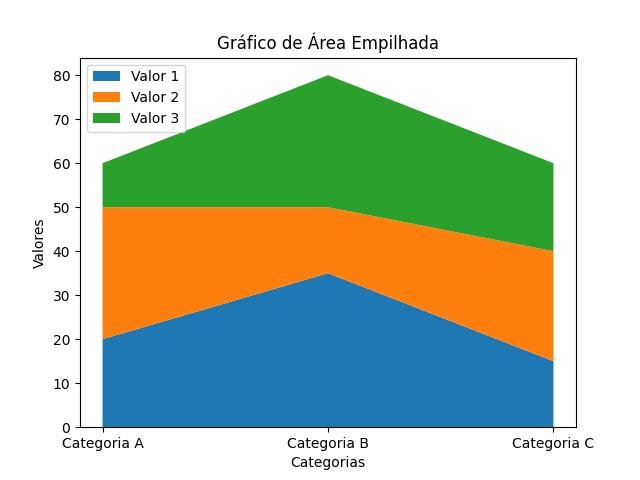

Essa revisão tem como objetivo nivelar o conhecimento e relembrar os conceitos essenciais que são a base de toda análise estatística. Discutiremos conceitos-chave, como medidas de tendência central e dispersão, probabilidade, distribuições estatísticas, intervalos de confiança e testes de hipóteses. Além disso, abordaremos técnicas de análise exploratória de dados, como gráficos e visualizações, que desempenham um papel crucial na compreensão e na identificação de padrões nos conjuntos de dados.

Essa revisão nos preparará para os capítulos subsequentes, onde exploraremos em profundidade uma variedade de tópicos avançados da estatística. Você poderá consolidar seus conhecimentos prévios e estabelecer uma base sólida para os conceitos mais complexos que serão abordados, expandindo seu conjunto de ferramentas estatísticas e adquirir habilidades avançadas de análise de dados!

Autores

Roberto Teixeira

Betobyte

Cientista de Dados

CIEDA

cieda.com.br

roberto@cieda.com.br

Carlos Delfino

Arduino

Cientista de Dados

Basicão da Eletrônica

www.carlosdelfino.eti.br

consultoria@carlosdelfino.eti.br

1.1 - Visão geral do curso

O curso de Estatística Avançada foi projetado para fornecer a cientistas de dados, analistas de sistemas e programadores de computador uma visão avançada da estatística, e a estatísticos uma visão de programação aplicada com Python, uma compreensão aprofundada e abrangente de técnicas estatísticas avançadas.

O objetivo principal é capacitar os leitores a lidarem com problemas complexos de análise de dados e tomarem decisões embasadas em resultados estatísticos confiáveis.

A estrutura do curso é dividida em 15 capítulos, cada um abordando um tópico específico da estatística avançada.

Começamos com uma introdução geral, que descreve a importância da estatística avançada na era da análise de dados, e seguimos explorando os métodos e aplicações em várias áreas, como ciências sociais, ciências naturais, finanças e saúde.

A seguir temos a relação de capítulos do curso:

- 1. Introdução à Estatística Avançada: este capítulo, apresenta a visão geral do curso e uma revisão abrangente dos conceitos fundamentais.

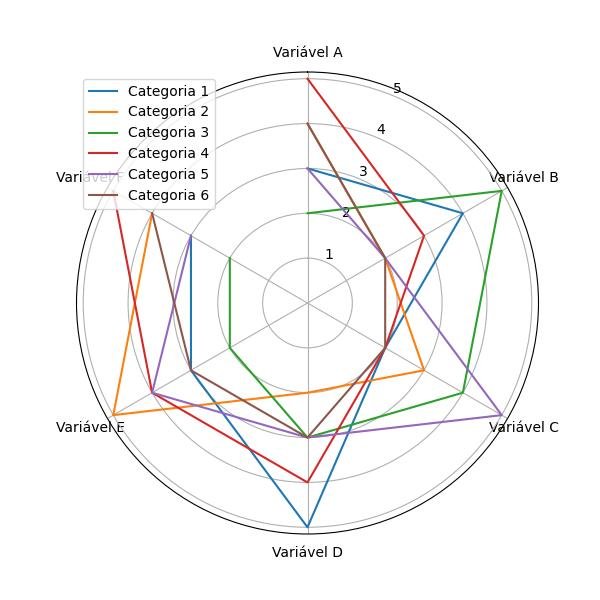

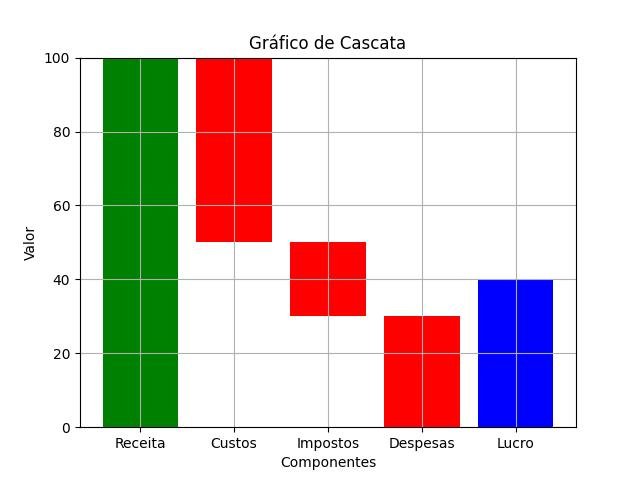

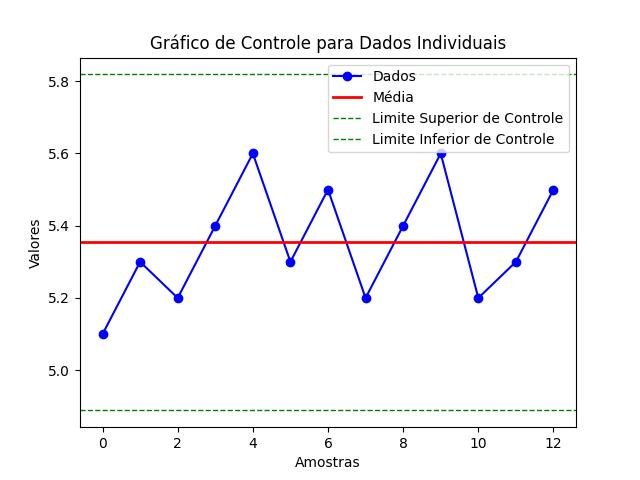

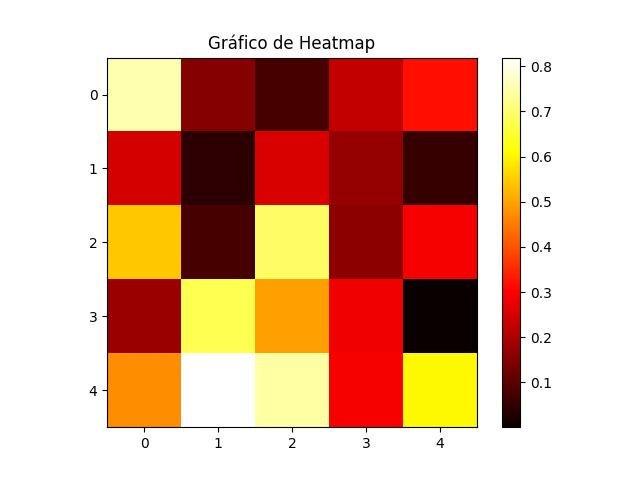

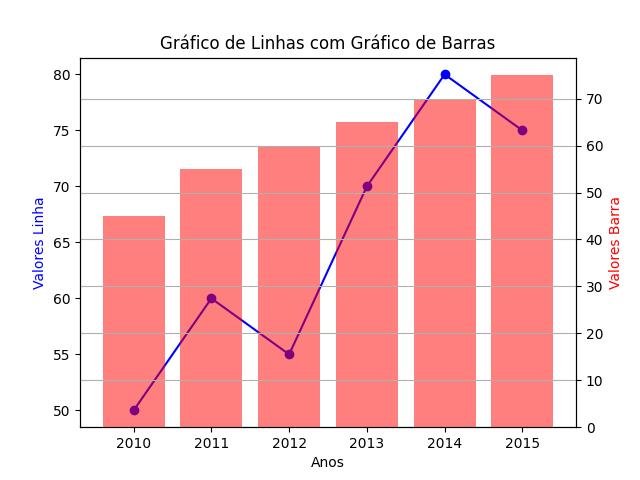

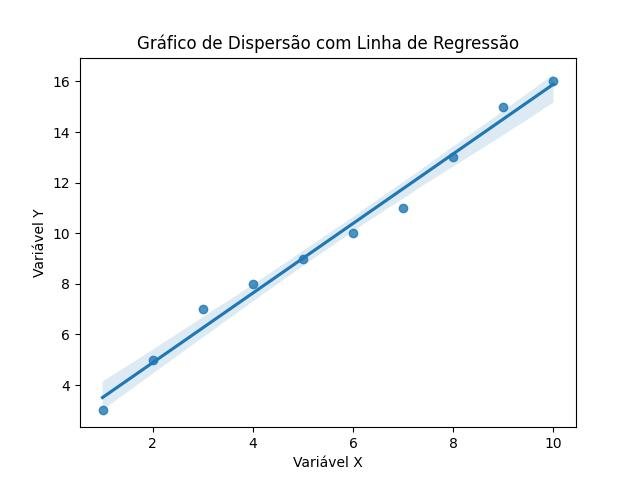

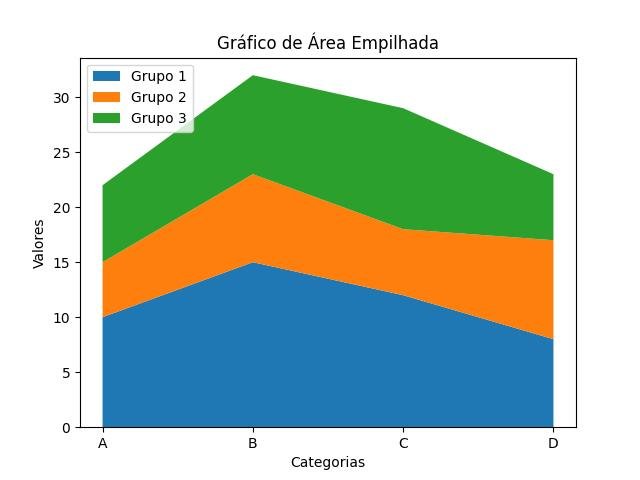

- 2. Análise Exploratória de Dados: no capítulo 2, concentramos nossa atenção na análise exploratória de dados. Discutimos técnicas avançadas de visualização de dados e exploração de padrões, incluindo gráficos complexos, análise de correlação e covariância multivariada, análise de componentes principais e análise fatorial. São ferramentas essenciais para compreensão da estrutura e das relações nos dados, antes de prosseguirmos para análises mais avançadas.

- 3. Testes de Hipóteses e Inferência Estatística: no capítulo 3, abordamos testes de hipóteses e inferência estatística. Exploramos testes paramétricos, testes de aderência e independência, estimação de parâmetros e intervalos de confiança avançados, testes de bootstrap e testes de permutação, além de técnicas para lidar com os desafios de múltiplos testes e ajustes de p-valor.

- 4. Modelos de Regressão: no capítulo 4 abordamos modelos de regressão. Discutimos a regressão linear múltipla, modelos de regressão não linear, modelos lineares generalizados e modelos de sobrevivência e risco proporcional. Também exploramos técnicas robustas de regressão e regressão de quantis.

- 5. Modelos Lineares Generalizados Avançados: no capítulo 5, aprofundamos os modelos lineares generalizados avançados. Cobrimos modelos e regressão de Poisson, modelos de regressão logística, modelos de resposta nominal e ordinal, modelos de contagem multivariada e modelos de regressão com erros de medição.

- 6. Análise de Variância e Experimentos: no capítulo 6, concentramos nossa atenção na análise de variância e experimentos. Exploramos a análise de variância de um fator e multifatorial, planejamento de experimentos, análise de covariância e análise de medidas repetidas. Também abordamos modelos mistos para lidar com estruturas complexas de dados.

- 7. Série Temporais: no capítulo 7, discutimos análise de séries temporais. Exploramos modelos autoregressivos (AR), modelos de médias móveis (MA), modelos ARMA e ARIMA, modelos de séries temporais multivariadas e modelos de componente sazonais. Também abordamos técnicas de previsão e diagnóstico em séries temporais, permitindo aos leitores compreender e analisar dados que evoluem ao longo do tempo.

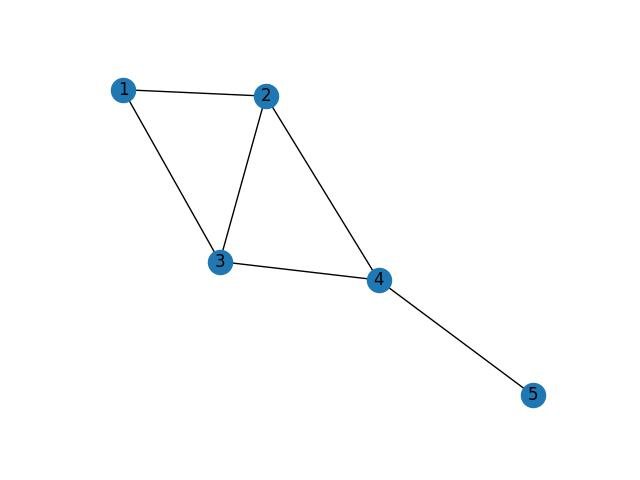

- 8. Análise Multivariada: no capítulo 8, concentramos nossa atenção na análise multivariada. Discutimos técnicas avançadas de análise de agrupamento (cluster analysis), análise de componentes principais (PCA - Principal Component Analysis) multivariada, análise discriminante e classificação, análise de correspondência e análise de escalonamento multidimensional. Também exploramos técnicas de análise de redes e modelos de grafos, que são úteis para entender e visualizar relacionamentos complexos entre variáveis.

- 9. Métodos Bayesianos: no capítulo 9, introduzimos os métodos Bayesianos. Exploramos os fundamentos da inferência bayesiana, modelos de regressão bayesiana, inferência bayesiana não paramétrica e modelos de mistura e clustering bayesianos. Também discutimos técnicas de avaliação e seleção de modelos bayesianos, permitindo que os leitores apliquem esses métodos poderosos para lidar com incerteza e tomar decisões informadas.

- 10. Métodos de Simulação: no capítulo 10, abordamos os métodos de simulação. Discutimos a simulação Monte Carlo, técnicas de redução de variância, amostragem por importância, cadeias de Markov e amostradores de Monte Carlo baseados em cadeias. Também exploramos a modelagem e simulação de eventos discretos, fornecendo aos leitores ferramentas para realizar experimentos virtuais e simular cenários complexos.

- 11. Análise de Sobrevivência: no capítulo 11, concentramos nossa atenção na análise de sobrevivência. Discutimos funções de sobrevivência e estimadores não paramétricos, modelos de risco proporcional de Cox, modelos de riscos competitivos e modelos paramétricos de distribuição de tempo até o evento. Também abordamos técnicas de avaliação e seleção de modelos de sobrevivência, permitindo aos leitores analisar dados de sobrevivência e lidar com eventos ao longo do tempo.

- 12. Métodos de Amostragem: no capítulo 12, discutimos métodos de amostragem. Exploramos amostragem aleatória simples e estratificada, amostragem por conglomerados e multiestágio, métodos de amostragem complexa e ponderação, amostragem de redes sociais e amostragem baseada em contatos. Também abordamos amostragem adaptativa e métodos não probabilísticos, fornecendo aos leitores técnicas avançadas para obter amostras representativas e realizar inferências confiáveis a partir de dados amostrais.

- 13. Análise de Dados Longitudinais: no capítulo 13, concentramos nossa atenção na análise de dados longitudinais. Discutimos modelos lineares generalizados mistos, modelos lineares generalizados para medidas repetidas, modelos de crescimento e trajetórias, modelos de equações de estimativas generalizadas (GEE - Generalized Estimation Equations) e análise de dados de painel. Esses métodos permitem aos leitores lidarem com estruturas de dados longitudinais e capturarem a variação ao longo do tempo, fornecendo uma compreensão mais completa e detalhada das tendências e padrões nos dados.

- 14. Análise Espacial: no capítulo 14, exploramos a análise espacial. Discutimos autocorrelação espacial e estatísticas de Moran, interpolação espacial e krigagem, modelos de regressão espacial, clusterização espacial e detecção de aglomerados, bem como visualização e análise exploratória de dados espaciais. Essas técnicas são úteis para entender a dependência espacial e os padrões geográficos nos dados, permitindo uma análise mais abrangente e contextualizada de fenômenos relacionados à localização geográfica.

- 15. Métodos não paramétricos: no capítulo 15, abordamos métodos não paramétricos. Discutimos testes de hipóteses não paramétricos, estimação de densidade e regressão não paramétrica, métodos de bootstrap não paramétrico, árvores de decisão e florestas aleatórias, bem como outros métodos não paramétricos avançados. Essas técnicas são úteis quando os pressupostos paramétricos não são atendidos ou quando se deseja uma abordagem mais flexível e não restrita por suposições específicas.

- 16. Tópicos Avançados em Estatística: no capítulo 16, abordamos tópicos avançados em estatística, oferecendo uma visão geral de outras áreas de estudos e aplicações da estatística avançada. Esses tópicos podem incluir análise de dados censurados, métodos de redução de dimensionalidade, técnicas de aprendizado de máquina e mineração de dados, análise de redes complexas, análise de dados de alta dimensão e muito mais. Esse capítulo visa expandir ainda mais o conhecimento e despertar o interesse dos leitores para explorar áreas especializadas da estatística avançada.

1.2 - Revisão de conceitos fundamentais

Na seção de revisão de conceitos fundamentais, vamos relembrar e consolidar os principais conceitos e técnicas fundamentais da estatística que servirão de base sólida para a compreensão dos tópicos avançados abordados ao longo do curso.

Essa revisão é essencial para garantir que os leitores estejam familiarizados com os conceitos básicos necessários para aprofundar sua compreensão da estatística avançada.

- Começaremos relembrando as medidas de tendência central, como a média, a mediana e a moda, bem como as medidas de dispersão, como a variância e o desvio padrão. Discutiremos suas definições, propriedades e interpretações, além de explorar técnicas para calcular essas medidas a partir de dados observados. Além de discutir suas definições e cálculos, vamos explorar exemplos práticos com a linguagem Python, ilustrando sua aplicação em diferentes contextos. Você será capaz de entender como essas medidas resumem características importantes dos dados e como interpretá-las corretamente.

- Em seguida, abordaremos os conceitos fundamentais de probabilidade, que desempenham um papel crucial na estatística, e sua importância. Discutiremos as diferentes interpretações da probabilidade, como a frequentista, a subjetiva e outras abordagens modernas. Exploraremos as principais regras e propriedades da probabilidade, como a regra da adição e a regra da multiplicação, que são essenciais para a formulação e construção de modelos estatísticos sólidos.

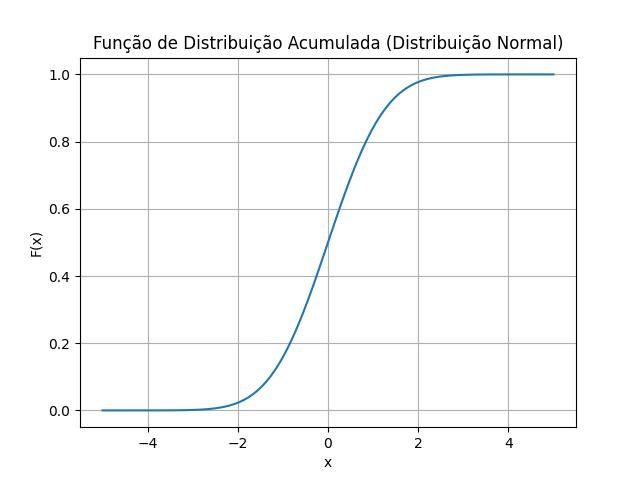

- Em seguida, aprofundaremos nosso entendimento sobre distribuições estatísticas. Você será capaz de reconhecer diferentes tipos de distribuições e entender suas características fundamentais, como a forma da curva, os parâmetros relevantes e os momentos. Discutiremos as distribuições discretas, como a distribuição binomial e a distribuição de Poisson, bem como as distribuições contínuas, como a distribuição normal e a distribuição exponencial. Ao invés de nos atermos apenas às definições formais, buscaremos exemplos práticos para ilustrar a aplicação dessas distribuições em problemas do mundo real. Serão abordados conceitos como função de densidade de probabilidade, função de distribuição acumulada, momentos e características das distribuições.

- Avançando na revisão, exploraremos os conceitos de intervalos de confiança adequados para as amostras e testes de hipóteses, de forma criteriosa, que são fundamentais para realização de inferências estatísticas, com atenção às decisões práticas que podem ser tomadas com base nos resultados obtidos. Em vez de focar apenas nas fórmulas e procedimentos, enfatizaremos a interpretação prática dessas técnicas estatísticas. Exploraremos o conceito de estimativa pontual e estimativa por intervalo, bem como as etapas para construir um intervalo de confiança para uma determinada população. Em relação aos testes de hipóteses, discutiremos a formulação de hipóteses nulas e alternativas, a escolha do nível de significância e a interpretação dos resultados.

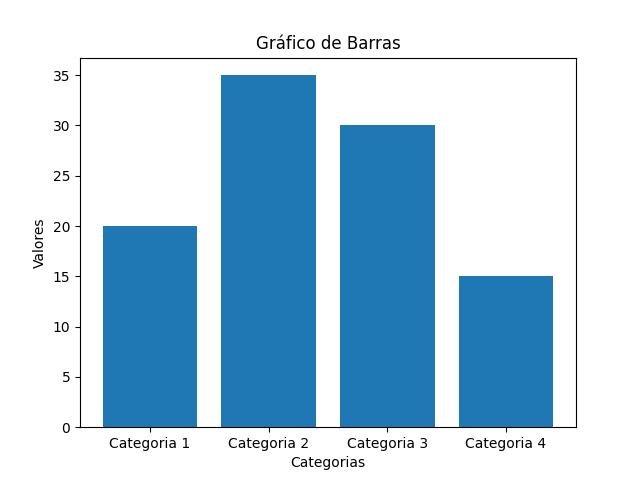

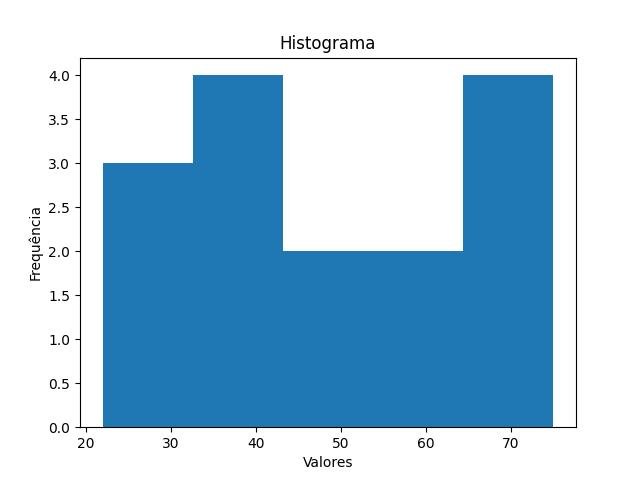

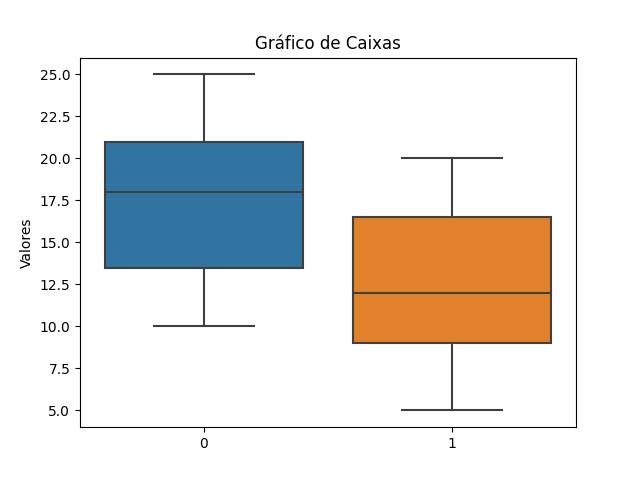

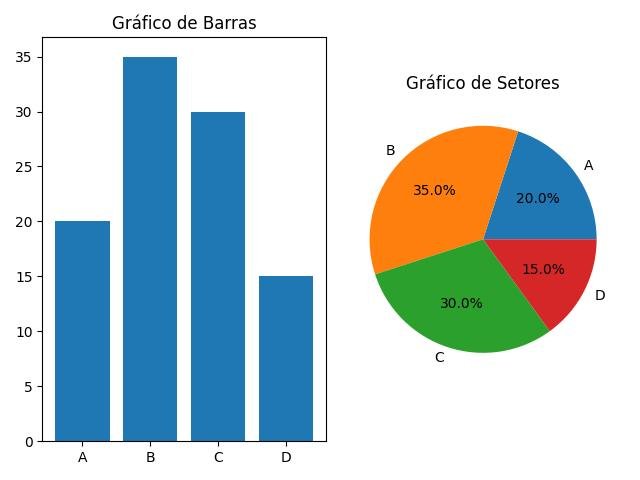

- Por fim, abordaremos técnicas de análise exploratória de dados, que são essenciais para entender e descrever os conjuntos de dados antes de aplicarmos técnicas mais avançadas. Exploraremos gráficos e visualizações, como histogramas, gráficos de dispersão e boxplots, que nos ajudam a identificar padrões, tendências e anomalias nos dados. Ao invés de apresentar uma lista de gráficos e visualizações, nos concentraremos na interpretação dos padrões e nas conclusões que podem ser extraídas. Você aprenderá a identificar tendências, discrepâncias e insights ocultos nos dados, capacitando-o a explorar plenamente o potencial informativo de suas análises estatísticas.

Ao concluir esta seção, os leitores terão revisado e consolidado conceitos-chave fundamentais da estatística, fornecendo uma base sólida para a compreensão dos tópicos avançados que serão abordados no restante do curso.

É importante ter um entendimento claro desses conceitos fundamentais, pois eles serão referência ao longo de toda a obra.

Ao invés de nos atermos apenas às definições formais, buscaremos exemplos práticos para ilustrar a aplicação dessas distribuições em problemas do mundo real.

Esquema da revisão:

Medidas:

Probabilidades:

Distribuições:

Testes:

Intervalos de confiança:

1.2.1 - Medidas de tendência central

Nesta seção, iremos revisitar as medidas de tendência central, como a média, a mediana e a moda.

Essas medidas desempenham um papel fundamental na descrição e resumo dos dados, fornecendo insights sobre o centro ou a tendência central de um conjunto de observações.

Ao explorar essas medidas de tendência central, forneceremos exemplos práticos que ilustram sua aplicação em diferentes contextos, incluindo campos como ciências sociais, economia, saúde, engenharia e muito mais.

Você verá como essas medidas podem ser utilizadas para resumir e comparar dados, ajudando a identificar padrões, tendências e características importantes em uma ampla gama de situações.

Através dessa revisão, você será capaz de entender como as medidas de tendência central podem ser calculadas e interpretadas corretamente, proporcionando uma base sólida para a compreensão dos tópicos avançados de estatística.

1.2.1.1 - Média

A média é a medida mais comumente usada para representar a tendência central dos dados.

Ela é calculada somando todos os valores de um conjunto de observações e dividindo a soma pelo número total de observações.

Exploraremos exemplos práticos para mostrar como calcular a média em diferentes contextos, como média aritmética, média ponderada e média geométrica.

- Média Aritmética: tipo mais comum de média utilizado na estatística, calculada somando todos os valores em um conjunto de dados e dividindo o resultado pelo número de observações. A média aritmética é uma medida de tendência central e representa o valor médio dos dados. É amplamente utilizada para resumir conjuntos de dados numéricos e é representada pelo símbolo "x̄" ou "μ" (para uma população).

- Média Ponderada: semelhante à média aritmética, mas atribui pesos diferentes aos valores do conjunto de dados. Os pesos representam a importância relativa de cada valor na média final. Para calcular a média ponderada, multiplica-se cada valor pelos respectivos pesos, soma-se os produtos e divide-se pelo somatório dos pesos. A média ponderada é útil quando certos valores têm mais impacto ou representatividade do que outros no conjunto de dados.

- Média Geométrica: usada principalmente para calcular a taxa de crescimento média de uma série de números ao longo do tempo. É calculada como a raiz n-ésima do produto dos valores, onde "n" é o número total de observações. A média geométrica é útil quando se trabalha com dados que apresentam um crescimento exponencial ou multiplicativo. Por exemplo, é frequentemente usada para calcular o retorno médio de investimentos financeiros ao longo do tempo.

Cada tipo de média tem sua própria aplicação e interpretação. A média aritmética é amplamente utilizada para resumir conjuntos de dados e determinar o valor médio geral. A média ponderada leva em consideração pesos diferentes, atribuindo maior importância a certos valores. A média geométrica é usada para calcular taxas de crescimento médias. A escolha do tipo de média depende do objetivo da análise estatística e das características dos dados em questão.

Veremos também como a média pode ser influenciada por valores extremos e como interpretá-la corretamente em relação à distribuição dos dados.

1.2.1.1.1 - Média aritmética

A média aritmética, também conhecida como média simples, é uma medida de tendência central amplamente utilizada na estatística. É calculada somando todos os valores em um conjunto de dados e dividindo o resultado pelo número de observações.

Fórmula da média aritmética: $ma$ = $\frac{x_1 + x_2 + x_3 + ... + x_n}{n}$, onde $ma$ é média aritmética, $x_1$, $x_2$, $x_3$, ..., $x_n$ são os valores do conjunto de dados e $n$ é o número total de observações.

Por exemplo, vamos considerar o conjunto de dados [10, 15, 20, 25, 30]. Para calcular a média aritmética, somamos todos os valores e dividimos pelo número de observações:

$ma$ = $\frac{10 + 15 + 20 + 25 + 30}{5}$ = $\frac{100}{5}$ = $20$

Portanto, a média aritmética dos valores fornecidos é igual a 20.

A média aritmética é amplamente utilizada como uma medida de tendência central, pois representa o valor médio dos dados, sendo sensível a todos os valores no conjunto de dados, o que significa que qualquer alteração nos valores afetará o valor da média. Além disso, a média aritmética pode ser calculada para diferentes tipos de dados, incluindo números inteiros, números reais, e até mesmo para certos tipos de dados categóricos.

É importante ressaltar que a média aritmética pode não ser uma representação adequada dos dados em certos casos, especialmente quando há valores extremos (outliers) que podem distorcer o resultado. Nesses casos, outras medidas de tendência central, como a mediana ou a média truncada, podem ser consideradas.

No entanto, a média aritmética é uma medida simples e amplamente compreendida, tornando-a útil para resumir e comparar conjuntos de dados. Ela fornece uma estimativa geral do valor médio de um conjunto de observações e é amplamente utilizada em estudos estatísticos, pesquisas, análises de dados e muitas outras aplicações.

Exemplo: cálculo da média de uma lista de valores usando a biblioteca Numpy.

import numpy as np

# Exemplo de lista de valores

valores = [15, 5, 10, 25, 20]

# Calcular a média usando a função mean() do Numpy

media = np.mean(valores)

# Imprimir o resultado

print("A média dos valores é:", media)Utilizando a função np.mean() do Numpy, calculamos a média dessa lista de valores [15, 5, 10, 25, 20] e armazenamos o resultado na variável media, imprimindo o valor da média na tela.

1.2.1.1.2 - Média ponderada

A média ponderada é uma variação da média aritmética em que cada valor no conjunto de dados é multiplicado por um peso correspondente antes de ser somado. Os pesos atribuídos a cada valor indicam a importância relativa desse valor na média final.

Fórmula da média ponderada: $mp$ = $\frac{p_1 x_1+p_2 x_2+...+p_n x_n}{p_1+p_2+...+ p_n}$, onde $mp$ é a média ponderada, $x_1$, $x_2$, $x_3$, ..., $x_n$ são os valores do conjunto de dados, $p_1$, $p_2$, $p_3$, ..., $p_n$ são os pesos correspondentes a cada valor e $n$ é o número total de observações.

A principal diferença entre a média aritmética e a média ponderada é a inclusão dos pesos na média ponderada. Os pesos indicam a importância relativa de cada valor na média final. Valores com pesos maiores têm uma contribuição maior para o cálculo da média ponderada.

Por exemplo, vamos considerar o conjunto de dados [10, 15, 20] com os respectivos pesos [2, 3, 1]. Para calcular a média ponderada, multiplicamos cada valor pelo peso correspondente, somamos os resultados e dividimos pelo somatório dos pesos:

$mp$ = $\frac{2 . 10 + 3 . 15 + 1 . 20}{2 + 3 + 1}$ = $\frac{20 + 45 + 20}{6}$ = $\frac{85}{6}$ ≈ $14,17$

Portanto, a média ponderada dos valores fornecidos, com os respectivos pesos, é aproximadamente 14,17.

A média ponderada é útil quando certos valores têm maior relevância ou influência nos resultados desejados. Por exemplo, em uma avaliação de desempenho de um aluno, as notas dos exames finais podem ter pesos maiores do que as notas dos trabalhos em grupo. Ao atribuir pesos, podemos refletir a importância relativa desses componentes na média final.

Assim como a média aritmética, a média ponderada é amplamente utilizada em várias áreas, como estatística, finanças, economia e pesquisa de opinião, quando diferentes valores têm importâncias distintas e devem ser considerados na obtenção de uma medida resumida.

Aqui está um exemplo de código em Python usando a biblioteca Numpy para calcular a média ponderada com uma lista de 20 observações desordenadas:

import numpy as np

# Lista de observações

observacoes = [10, 15, 20, 25, 30, 35, 40, 45, 50, 55, 60, 65, 70, 75, 80, 85, 90, 95, 100, 105]

# Lista de pesos correspondentes às observações

pesos = [0.1, 0.2, 0.05, 0.15, 0.1, 0.05, 0.05, 0.01, 0.01, 0.03, 0.02, 0.04, 0.03, 0.01, 0.02, 0.02, 0.03, 0.01, 0.02, 0.01]

# Verificar se o número de observações é igual ao número de pesos

if len(observacoes) != len(pesos):

raise ValueError("O número de observações deve ser igual ao número de pesos")

# Converter as listas para arrays numpy

observacoes = np.array(observacoes)

pesos = np.array(pesos)

# Calcular a média ponderada

media_ponderada = np.average(observacoes, weights=pesos)

# Imprimir o resultado

print("A média ponderada é: {:.2f}".format(media_ponderada))Neste exemplo, temos uma lista de 20 observações desordenadas e uma lista correspondente de pesos para cada observação. Usamos a função np.average() do Numpy para calcular a média ponderada, passando as observações como o primeiro argumento e os pesos como o argumento weights. O resultado é armazenado na variável media_ponderada e, em seguida, é impresso na tela.

Certifique-se de que o número de observações seja igual ao número de pesos para que o cálculo seja válido.

1.2.1.1.3 - Média geométrica

A média geométrica é uma medida estatística que é usada para calcular o valor central de um conjunto de números positivos. É obtida pela multiplicação de todos os valores do conjunto e em seguida, elevando o produto à raiz enésima, onde n é o número total de elementos do conjunto. A fórmula para calcular a média geométrica é a seguinte:

$mg = (x_1 . x_2 . x_3 . ... . x_n)^{\frac{1}{n}}$

Onde:

$mg$ é a média geométrica, $x_1$ , $x_2$, $x_3$, ..., $x_n$ são os valores do conjunto de dados e $n$ é o número total de observações.

A média geométrica é especialmente útil quando se lida com grandezas multiplicativas, como taxas de crescimento, rendimentos financeiros ou índices. Ela captura a taxa de crescimento média ao longo de vários períodos, considerando o efeito cumulativo das multiplicações.

Vamos considerar um exemplo com o conjunto de dados [2, 4, 8]. Para calcular a média geométrica, multiplicamos todos os valores e elevamos o resultado à raiz cúbica (já que há três elementos no conjunto):

$mg = (2.4.8)^\frac{1}{3} = 64^\frac{1}{3} ≈ 4$

Portanto, a média geométrica dos valores fornecidos é aproximadamente 4.

É importante destacar que a média geométrica é mais sensível a valores extremos do que a média aritmética. Isso ocorre porque a multiplicação amplifica o efeito desses valores, resultando em uma média geométrica maior ou menor dependendo da direção do valor extremo. Portanto, a média geométrica é mais adequada para dados que seguem uma progressão multiplicativa ou quando se deseja calcular a taxa de crescimento média.

A média geométrica é amplamente utilizada em áreas como finanças, economia, estatística e ciências naturais, onde os valores são multiplicativos ou seguem uma progressão multiplicativa.

Aqui está um exemplo de código em Python usando a biblioteca Numpy para calcular a média geométrica com uma lista de 20 observações desordenadas:

import numpy as np

# Lista de observações

observacoes = [2, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71]

# Converter as observações para um array numpy

observacoes = np.array(observacoes)

# Calcular a média geométrica

media_geometrica = np.prod(observacoes) ** (1 / len(observacoes))

# Imprimir o resultado

print("A média geométrica é: {:.2f}".format(media_geometrica))Neste exemplo, temos uma lista de 20 observações desordenadas. Usamos a função np.prod() do Numpy para calcular o produto de todos os elementos da lista e, em seguida, usamos a fórmula da média geométrica para calcular a raiz n-ésima do produto, onde n é o número de observações. O resultado é armazenado na variável media_geometrica e, em seguida, é impresso na tela.

Observe que a média geométrica é calculada apenas para valores positivos, pois envolve a multiplicação dos elementos. Certifique-se de ajustar os valores de observação de acordo com o problema que você está resolvendo.

1.2.1.2 - Mediana

A mediana é o valor central em um conjunto de dados ordenados.

Para calcular a mediana, organizamos os dados em ordem crescente e encontramos o valor que divide o conjunto ao meio.

Diferentemente da média, a mediana não é afetada por valores extremos ou discrepantes, o que a torna uma medida robusta para representar a tendência central.

Veremos exemplos práticos de como calcular e interpretar a mediana, especialmente em situações em que a distribuição dos dados não é simétrica.

Exemplo: como calcular a mediana de uma lista de valores usando a biblioteca Numpy:

import numpy as np

# Exemplo de lista de valores

valores = [14, 13, 14, 15, 12, 16, 1750, 24, 18, 19, 20, 21, 22, 23, 24, 25, 26, 27, 28, 29, 30]

# lista ordenada de valores

valores_ordenados = np.sort(valores)

# Imprimir o resultado

# calcular a mediana obtendo o valor que divide o conjunto ao meio

mediana_valores_ordenados = valores_ordenados[len(valores_ordenados) // 2]

# Imprimir a mediana calculada

print("A mediana dos valores é: {:.2f}".format(mediana_valores_ordenados))

# Calcular a mediana usando a função median() do Numpy

mediana = np.median(valores)

# Imprimir a mediana calculada

print("A mediana dos valores é: {:.2f}".format(mediana))

# Calcular a media usando a função mean() do Numpy

media = np.mean(valores)

# Imprimir a média calculada

print("A media dos valores é: {:.2f}".format(media))Neste exemplo, temos uma lista com 31 observações. Utilizando a função np.median() do Numpy, calculamos a mediana dessa lista e armazenamos o resultado na variável mediana. Em seguida, imprimimos o valor da mediana na tela.

Observe como o valor da mediana apresenta valor mais próximo ao da maioria dos valores da lista, mas a presença de uma valor destoando dos demais (1750) provocou um grande aumento no valor da média em relação à maioria das observações.

Diferentemente da média, a mediana não é afetada por valores extremos, o que a torna uma medida robusta para representar a tendência central de um conjunto de dados.

1.2.1.3 - Moda

A moda é o valor que ocorre com mais frequência em um conjunto de dados. Ela pode ser usada para identificar os valores mais comuns ou representativos em uma distribuição. Discutiremos como identificar a moda em conjuntos de dados unimodais, bimodais e multimodais. Além disso, exploraremos casos em que não há uma moda clara ou quando os dados são discretos e podem ter múltiplas modas.

A interpretação correta da moda pode fornecer informações valiosas sobre a distribuição e a forma dos dados.

como calcular a moda de uma lista de valores usando a biblioteca SciPy:

from scipy import stats

# Exemplo de lista de valores

valores = [5, 10, 15, 20, 20, 25, 30, 30, 30]

# Calcular a moda usando a função mode do SciPy

moda = stats.mode(valores)

# Imprimir o resultado

print("A moda dos valores é:", moda.mode)Neste exemplo, temos uma lista de valores [5, 10, 15, 20, 20, 25, 30, 30, 30]. Utilizando a função stats.mode() do SciPy, calculamos a moda dessa lista e armazenamos o resultado na variável moda. O valor da moda é acessado através da propriedade mode(), apontando para uma lista de valores, pois pode haver mais de um valor com a mesma quantidade de ocorrências (multimodal), portanto utilizando apenas o valor do primeiro índice [0], imprimindo a seguir este valor.

Portanto, a moda dos valores [5, 10, 15, 20, 20, 25, 30, 30, 30] é 30. A moda representa o valor que ocorre com maior frequência na lista de valores. No exemplo acima, o valor 30 ocorre três vezes, o que o torna a moda desse conjunto de dados.

1.2.2 - Medidas de dispersão

Além das medidas de tendência central, é importante compreender as medidas de dispersão, como a variância e o desvio padrão. Essas medidas fornecem informações essenciais sobre a dispersão ou a variabilidade dos dados em relação à média. Assim como nas medidas de tendência central, também vamos explorar a aplicação das medidas de dispersão em diferentes contextos. Exemplos práticos serão fornecidos para ilustrar como a variância e o desvio padrão podem ser usados para:

- Comparar a dispersão dos dados em diferentes grupos.

- Identificar padrões de variabilidade.

- Entender a consistência ou a variabilidade dos resultados em estudos científicos.

Compreender a importância dessas medidas de dispersão ajudará a obter uma visão mais completa e precisa dos dados analisados. Através dessa revisão das medidas de dispersão, incluindo a variância e o desvio padrão, você terá uma compreensão mais aprofundada sobre como essas medidas são calculadas e interpretadas corretamente. Isso lhe dará uma base sólida para continuar explorando os tópicos avançados de estatística que serão abordados no curso, permitindo que você compreenda e analise a variabilidade dos dados de forma precisa e informativa.

1.2.2.1 - Variância

A variância é uma medida que quantifica a dispersão dos valores em torno da média.

Ela mede a média dos quadrados das diferenças entre cada valor e a média do conjunto de dados.

Exploraremos exemplos práticos para entender como calcular a variância, suas propriedades e sua interpretação em diferentes situações. Além disso, discutiremos a relação entre a variância e a distribuição dos dados, bem como as implicações práticas dessa medida.

Exemplo: como calcular a variância de uma lista de valores usando a biblioteca NumPy.

import numpy as np

# Exemplo de lista de valores

valores = [5, 10, 15, 20, 25]

# Calcular a variância usando a função var do NumPy

variancia = np.var(valores)

# Imprimir o resultado

print("A variância dos valores é:", variancia)Neste exemplo, temos uma lista de valores [5, 10, 15, 20, 25]. Utilizando a função np.var() do NumPy, calculamos a variância da lista e armazenamos o resultado na variável variancia, imprimindo em seguida o valor da variância na tela.

A variância é uma medida que quantifica a dispersão dos valores em relação à média, sendo calculada como a média dos quadrados das diferenças entre cada valor e a média do conjunto de dados.

1.2.2.2 - Desvio padrão

O desvio padrão é a raiz quadrada da variância e é uma medida comumente utilizada para expressar a dispersão dos dados, fornecendo uma medida de dispersão que está na mesma escala dos dados originais.

Ao calcular o desvio padrão, podemos interpretá-lo como a média das distâncias entre os valores e a média, considerando a dispersão em torno da média.

Veremos como calcular o desvio padrão e como interpretar essa medida em diferentes cenários, além de discutir sua relação com outras medidas estatísticas.

Exemplo: desvio padrão de uma lista de valores usando a biblioteca NumPy.

import numpy as np

# Exemplo de lista de valores

valores = [5, 10, 15, 20, 25]

# Calcular o desvio padrão usando a função std do NumPy

desvio_padrao = np.std(valores)

# Imprimir o resultado

print("O desvio padrão dos valores é:", desvio_padrao)Neste exemplo, temos uma lista de valores [5, 10, 15, 20, 25]. Utilizando a função np.std() do NumPy, calculamos o desvio padrão dessa lista e armazenamos o resultado na variável desvio_padrao, imprimindo em seguida o valor do desvio padrao.

Portanto, o desvio padrão dos valores [5, 10, 15, 20, 25] é aproximadamente 7,91. O desvio padrão é uma medida que expressa a dispersão dos valores em relação à média. Ele é calculado como a raiz quadrada da variância, fornecendo uma medida de dispersão que está na mesma escala dos dados originais.

1.2.3 - Probabilidade

A probabilidade é uma medida numérica que representa a chance ou a frequência relativa de ocorrência de um evento em relação ao conjunto de todos os eventos possíveis. Ela fornece uma maneira de quantificar a incerteza e a aleatoriedade em um experimento, sendo expressa em uma escala de 0 a 1, onde 0 significa impossibilidade absoluta, que o evento é impossível, e 1 significa certeza absoluta, que o evento é certo. Um evento com probabilidade 0 não ocorrerá, enquanto um evento com probabilidade 1 ocorrerá com certeza.

A probabilidade de um evento pode ser determinada de diferentes maneiras, dependendo da natureza do experimento e das informações disponíveis. Existem três abordagens principais para determinar a probabilidade: abordagem clássica, abordagem frequentista e abordagem subjetiva.

A abordagem clássica, também conhecida como probabilidade teórica, é aplicada quando todos os resultados possíveis do experimento são igualmente prováveis. Nesse caso, a probabilidade de um evento é calculada dividindo o número de resultados favoráveis pelo número total de resultados possíveis.

A abordagem frequentista, também conhecida como probabilidade empírica, é baseada na observação de frequências relativas. A probabilidade de um evento é calculada como a proporção de vezes em que o evento ocorre em um grande número de repetições do experimento.

A abordagem subjetiva é baseada nas crenças e nas informações disponíveis de um indivíduo. Nessa abordagem, a probabilidade é uma medida subjetiva de confiança ou grau de crença na ocorrência de um evento.

A probabilidade possui várias propriedades, como a aditividade (a probabilidade da união de eventos é igual à soma das probabilidades dos eventos individuais), a multiplicatividade (a probabilidade da interseção de eventos independentes é igual ao produto das probabilidades) e a complementaridade (a probabilidade do evento complementar é igual a 1 menos a probabilidade do evento).

A teoria da probabilidade é amplamente aplicada em diversas áreas, como estatística, ciência, engenharia, finanças, entre outras, para análise e tomada de decisões com base na incerteza e no risco.

Os conceitos fundamentais de probabilidade desempenham um papel crucial na estatística e são de suma importância na correta compreensão e aplicação dos métodos estatísticos.

A compreensão dos conceitos fundamentais de probabilidade é essencial para aprofundarmos nossos conhecimentos em estatística avançada, uma vez que muitos dos métodos e técnicas estatísticas são baseados em princípios probabilísticos. Portanto, esse estudo introdutório nos fornecerá a base necessária para explorar tópicos mais avançados, como inferência estatística, modelos probabilísticos e técnicas de amostragem, ampliando assim nossa compreensão e habilidades na análise de dados.

inicialmente apresentaremos os diferentes tipos de probabilidade:

- Probabilidade Clássica: também conhecida como probabilidade à priori, é baseada na contagem de casos igualmente prováveis. Por exemplo, ao lançar um dado justo de seis faces, a probabilidade de obter qualquer número é 1/6.

- Probabilidade Empírica: probabilidade determinada pela frequência relativa de um evento em um grande número de repetições de um experimento. Por exemplo, lançar uma moeda várias vezes e contar a proporção de vezes que "cara" ocorre.

- Probabilidade Condicional: probabilidade de um evento ocorrer, dado que outro evento já ocorreu. É denotada por $P(A|B)$, onde $A$ e $B$ são eventos. Por exemplo, a probabilidade de chover, dado que as nuvens estão escuras.

A probabilidade é um campo fundamental da teoria estatística e envolve vários conceitos-chave

A seguir apresentaremos dois importantes conceitos de probabilidade:

- Espaço Amostral: conjunto de todos os resultados possíveis de um experimento. Por exemplo, ao lançar uma moeda, o espaço amostral é composto pelos resultados "cara" e "coroa".

- Evento: subconjunto do espaço amostral representando um conjunto de resultados específicos. Por exemplo, o evento de obter "cara" ao lançar uma moeda.

Em seguida, discutiremos as diferentes interpretações da probabilidade, que oferecem perspectivas distintas sobre como compreender e quantificar a incerteza. Existem diferentes interpretações da probabilidade que refletem perspectivas distintas sobre como compreender e quantificar a incerteza. Essas interpretações fornecem abordagens filosóficas e práticas para lidar com a probabilidade.

Entre essas interpretações, destacam-se:

- Interpretação Frequentista: essa interpretação define a probabilidade como a frequência relativa de um evento em um grande número de repetições de um experimento. Segundo a abordagem frequentista, a probabilidade é objetiva e baseada na observação empírica de eventos repetidos. Por exemplo, a probabilidade de obter "cara" ao lançar uma moeda justa é 0.5, porque, em muitos lançamentos, espera-se que metade dos resultados seja "cara". Essa interpretação é amplamente aplicada em experimentos repetíveis, como jogos de azar e pesquisas estatísticas.

- Interpretação Subjetiva: nessa interpretação, a probabilidade é vista como uma medida subjetiva da crença ou grau de confiança de um indivíduo em relação a um evento ocorrer. As probabilidades são atribuídas com base em conhecimentos prévios, crenças, experiências pessoais e julgamentos subjetivos. Cada pessoa pode ter diferentes probabilidades subjetivas para o mesmo evento, dependendo de suas informações e perspectivas individuais. Essa interpretação é comumente aplicada em situações em que não é possível obter dados empíricos ou quando a incerteza é baseada em julgamentos individuais.

- Interpretação Axiomática ou Clássica: essa interpretação se baseia em um conjunto de axiomas matemáticos que descrevem as propriedades da probabilidade. A probabilidade é tratada como uma medida matemática que segue certas regras e princípios, independentemente de sua interpretação filosófica subjacente. Essa interpretação é amplamente usada na teoria da probabilidade e fornece uma estrutura matemática sólida para a análise probabilística.

- Interpretações modernas: são abordagens como a probabilidade bayesiana, que combina informações à priori (conhecimentos prévios), atualizando com dados observados a probabilidade de eventos (probabilidades a posteriori). A probabilidade bayesiana é especialmente útil em situações em que novas evidências podem alterar as crenças iniciais sobre um evento.

Cada interpretação da probabilidade tem suas vantagens e limitações, e a escolha da interpretação depende do contexto e dos objetivos da análise probabilística. É importante reconhecer que a interpretação da probabilidade pode variar entre os campos da estatística, da ciência e da filosofia, e diferentes abordagens podem ser adequadas em diferentes situações.

Em seguida, examinaremos as principais regras e propriedades da probabilidade:

- Regra da Adição: também conhecida como princípio da soma, é fundamental para calcularmos a probabilidade da ocorrência de pelo menos um de dois eventos mutuamente exclusivos. Essa regra estabelece que a probabilidade da ocorrência de pelo menos um desses eventos é igual à soma das probabilidades individuais de cada evento. A probabilidade da união de dois eventos $A$ e $B$ é dada por $P(A ∪ B) = P(A)+P(B)$.

- Regra da multiplicação: também conhecida como princípio do produto, é aplicada para calcular a probabilidade conjunta de dois eventos eventos independentes. Essa regra estabelece que a probabilidade da ocorrência simultânea de dois eventos independentes é igual ao produto das probabilidades individuais de cada evento. A probabilidade da interseção de dois eventos $A$ e $B$ é dada por $P(A ∩ B) = P(A).P(B)$.

- Regra da complementaridade: estabelece que a probabilidade de um evento ocorrer somada à probabilidade de seu complemento ocorrer é igual a 1, significando que a probabilidade total de ocorrer um evento ou seu complemento é certa. Matematicamente, $P(A) + P(A') = 1$, onde $A'$ representa o complemento de $A$.

- Regra da probabilidade condicional: probabilidade de um evento A ocorrer dado que outro evento B já ocorreu. A regra da probabilidade condicional é expressa por P(A|B) = P(A ∩ B) / P(B), onde P(A|B) é a probabilidade condicional de A dado B.

- Regra da probabilidade total: usada quando um evento pode ocorrer de várias maneiras, cada uma com uma probabilidade associada. A probabilidade total de um evento A é dada pela soma das probabilidades de A ocorrer em cada uma dessas maneiras. Matematicamente, P(A) = ∑[P(A|B) * P(B)], onde a soma é realizada para todos os eventos mutuamente exclusivos B que cobrem todo o espaço amostral.

- Regra de Bayes: permite atualizar probabilidades com base em informações adicionais. É usada para calcular a probabilidade de um evento A ocorrer dado que outro evento B já ocorreu. A fórmula da regra de Bayes é P(A|B) = [P(B|A) * P(A)] / P(B), onde P(A|B) é a probabilidade condicional de A dado B.

Ao compreender e dominar as regras e propriedades da probabilidade, estaremos preparados para formular e construir modelos estatísticos sólidos. Esses modelos são utilizados para descrever e analisar fenômenos aleatórios e incertos, permitindo-nos realizar inferências estatísticas e tomar decisões informadas com base em dados observados.

Esses são apenas alguns dos conceitos fundamentais da teoria da probabilidade. A partir desses conceitos, podemos explorar outros tópicos avançados, como distribuições de probabilidade, teoremas de limite central, teoria das probabilidades condicionais e probabilidade bayesiana.

1.2.3.1 - Probabilidade Clássica

A Probabilidade Clássica, também conhecida como probabilidade teórica ou probabilidade a priori, é uma abordagem para determinar a probabilidade de um evento com base na suposição de que todos os resultados possíveis são igualmente prováveis. Essa abordagem é aplicada quando temos um conjunto finito de resultados possíveis e cada resultado tem a mesma chance de ocorrer.

A Probabilidade Clássica é frequentemente usada em situações de experimentos teóricos ou ideais, onde é possível listar e contar todos os resultados possíveis com igual chance de ocorrência.

Para calcular a probabilidade clássica de um evento, é necessário seguir os seguintes passos:

- Identificar o espaço amostral: o espaço amostral é o conjunto de todos os resultados possíveis do experimento. É importante ter uma compreensão clara dos resultados possíveis.

- Identificar o evento de interesse: o evento é um subconjunto do espaço amostral que descreve uma ou mais condições ou resultados específicos que estamos interessados em calcular a probabilidade.

- Calcular a probabilidade: o probabilidade clássica é calculada dividindo o número de resultados favoráveis ao evento pelo número total de resultados possíveis.

A fórmula para calcular a probabilidade clássica é: $Probabilidade = \frac{favoraveis}{possiveis}$, onde $favoraveis$ é o número de resultados favoráveis e $possiveis$ é o número total de resultados possíveis.

É importante ressaltar que a probabilidade clássica pressupõe que todos os resultados possíveis são equiprováveis, ou seja, cada resultado tem a mesma chance de ocorrer. Essa suposição nem sempre é válida na prática, mas em experimentos teóricos bem definidos e equilibrados, a probabilidade clássica é amplamente utilizada.

Vamos supor que temos uma moeda justa, onde os resultados possíveis são cara (C) ou coroa (K). Queremos calcular a probabilidade de obter cara em um lançamento.

# Importar a biblioteca random

import random

# Definir o espaço amostral e o evento de interesse

espaco_amostral = ['C', 'K']

evento_cara = 'C'

# Simular o lançamento da moeda várias vezes

num_lancamentos = 1000

contador_cara = 0

for _ in range(num_lancamentos):

resultado = random.choice(espaco_amostral)

if resultado == evento_cara:

contador_cara += 1

# Calcular a probabilidade clássica

probabilidade = contador_cara / num_lancamentos

# Imprimir o resultado

print("A probabilidade de obter cara é:", probabilidade)Nesse exemplo, simulamos o lançamento da moeda 1000 vezes e contamos quantas vezes obtivemos o resultado cara. Em seguida, calculamos a probabilidade dividindo o número de vezes que obtivemos cara pelo número total de lançamentos, colaborando no entendimento do conceito de probabilidade Clássica e como calcular a probabilidade em situações em que todos os resultados possíveis são igualmente prováveis!

1.2.3.2 - Probabilidade Empírica

A Probabilidade Empírica, também conhecida como probabilidade experimental, é uma abordagem para determinar a probabilidade de um evento com base em dados observados ou coletados a partir de experimentos ou eventos reais. Diferente da probabilidade clássica, a probabilidade empírica é baseada em evidências empíricas e não pressupõe que todos os resultados possíveis sejam igualmente prováveis.

A Probabilidade Empírica é aplicada quando temos dados ou observações de eventos passados e queremos usar essas informações para estimar a probabilidade de eventos futuros sem fazer suposições teóricas.

Para calcular a probabilidade empírica de um evento, é necessário seguir os seguintes passos:

- Coletar os dados: é necessário coletar dados relevantes sobre o evento de interesse. Isso pode ser feito por meio de observação direta, experimentos ou análise de dados históricos.

- Contar os resultados favoráveis: com base nos dados coletados, é necessário contar o número de vezes que o evento de interesse ocorreu.

- Calcular a probabilidade: a probabilidade empírica é calculada dividindo o número de resultados favoráveis pelo número total de observações.

A fórmula para calcular a probabilidade empírica é: $Probabilidade = \frac{favoraveis}{observacoes}$, onde $favoraveis$ é o número de resultados favoráveis e $observacoes$ é o número total de observações.

É importante ressaltar que a probabilidade empírica é baseada em evidências empíricas limitadas e está sujeita a flutuações e incertezas devido à natureza dos dados coletados. Quanto maior for o tamanho da amostra ou o número de observações, mais confiável será a estimativa da probabilidade.

Vamos supor que temos uma caixa com bolas vermelhas e azuis. Queremos calcular a probabilidade empírica de retirar uma bola vermelha da caixa com base em uma série de experimentos.

# Importar a biblioteca random

import random

# Definir a caixa com bolas

caixa = ['vermelha', 'azul']

# Realizar uma série de experimentos

num_experimentos = 100

contador_vermelha = 0

for _ in range(num_experimentos):

bola = random.choice(caixa)

if bola == 'vermelha':

contador_vermelha += 1

# Calcular a probabilidade empírica

probabilidade_empirica = contador_vermelha / num_experimentos

# Imprimir o resultado

print("A probabilidade empírica de retirar uma bola vermelha é:", probabilidade_empirica)Nesse exemplo, simulamos uma série de experimentos em que retiramos uma bola da caixa (com reposição) e contamos quantas vezes obtivemos uma bola vermelha. Em seguida, calculamos a probabilidade empírica dividindo o número de vezes que obtivemos uma bola vermelha pelo número total de experimentos.

1.2.3.3 - Probabilidade condicional

A Probabilidade Condicional é uma medida de probabilidade que descreve a probabilidade de ocorrência de um evento A dado que outro evento B já ocorreu. Ela permite que levemos em consideração informações adicionais ou restrições ao calcular a probabilidade de um evento.

A probabilidade condicional é denotada como $P(A|B)$, onde $A$ e $B$ são eventos, e lê-se "a probabilidade de A dado B". A fórmula para calcular a probabilidade condicional é:

$P(A|B) = \frac{P(A e B)}{P(B)}$

Aqui estão alguns conceitos-chave relacionados à probabilidade condicional:

- Evento $A$: é o evento cuja probabilidade queremos calcular, dado que o evento B ocorreu.

- Evento $B$: é o evento que já ocorreu ou que estamos considerando como dado. É a base para calcular a probabilidade condicional.

- $P(A e B)$: representa a probabilidade conjunta de ocorrência dos eventos $A$ e $B$, ou seja, a probabilidade de ambos os eventos ocorrerem simultaneamente.

- $P(B)$: representa a probabilidade do evento B ocorrer.

A probabilidade condicional é útil para analisar situações em que a ocorrência de um evento está relacionada ou depende da ocorrência de outro evento. Ela nos permite ajustar nossas estimativas de probabilidade com base nas informações disponíveis.

Vamos considerar um exemplo em que temos uma urna com bolas vermelhas e azuis. Queremos calcular a probabilidade de tirar uma bola vermelha da urna, dado que a primeira bola tirada foi azul.

# Importar a biblioteca random

import random

# Definir a urna com bolas

urna = ['vermelha', 'azul', 'azul']

# Realizar a primeira retirada

primeira_bola = random.choice(urna)

# Verificar se a primeira bola é azul

if primeira_bola == 'azul':

# Retirar uma segunda bola da urna

segunda_bola = random.choice(urna)

if segunda_bola == 'vermelha':

# Calcular a probabilidade condicional P(A|B)

prob_condicional = 1.0

else:

prob_condicional = 0.0

else:

prob_condicional = 0.0

# Imprimir o resultado

print("A probabilidade condicional de tirar uma bola vermelha dado que a primeira bola foi azul é:", prob_condicional)Nesse exemplo, simulamos a retirada de duas bolas da urna com reposição. Se a primeira bola retirada for azul, verificamos a cor da segunda bola. Se a segunda bola for vermelha, a probabilidade condicional é igual a 1 (certeza de que a segunda bola é vermelha). Caso contrário, a probabilidade condicional é igual a 0 (impossibilidade de a segunda bola ser vermelha).

1.2.3.4 - Espaço Amostral

O espaço amostral é um dos conceitos fundamentais da teoria das probabilidades. Ele representa o conjunto de todos os resultados possíveis de um experimento aleatório. Em outras palavras, o espaço amostral é o conjunto de todos os eventos elementares que podem ocorrer em um experimento.

Vamos considerar um exemplo simples: lançar um dado comum de seis faces. O espaço amostral nesse caso seria o conjunto {1, 2, 3, 4, 5, 6}, que representa todos os resultados possíveis do lançamento do dado. Cada número nesse conjunto é um evento elementar, ou seja, um resultado individual que pode ocorrer.

O espaço amostral pode ser finito, como no exemplo do dado, em que temos um número limitado de resultados possíveis. No entanto, também pode ser infinito, como no caso de lançar uma moeda infinitas vezes, em que o espaço amostral seria o conjunto de todos os resultados possíveis (cara ou coroa) repetidos infinitamente.

É importante ressaltar que o espaço amostral deve ser bem definido e abranger todos os resultados possíveis do experimento. Ele é a base para a análise de probabilidades, pois todos os eventos e suas respectivas probabilidades são derivados do espaço amostral.

Além do espaço amostral, outros conceitos importantes relacionados à teoria das probabilidades incluem eventos, probabilidade, combinação de eventos e cálculo de probabilidades. Todos esses conceitos juntos nos permitem quantificar e estudar a incerteza associada a um determinado fenômeno aleatório.

import numpy as np

# Definindo o espaço amostral

espaco_amostral = np.array([1, 2, 3, 4, 5, 6])

# Imprimindo o espaço amostral

print("Espaço Amostral:", espaco_amostral)Neste exemplo, usamos a biblioteca numpy para criar um array com os elementos do espaço amostral, que são os números de 1 a 6, representando as faces do dado. Em seguida, imprimimos o espaço amostral na tela.

Lembrando que o espaço amostral pode ser personalizado de acordo com o contexto do problema. Neste caso, consideramos o espaço amostral de um dado comum, mas você pode ajustar o código para outros experimentos aleatórios, modificando os valores dentro do array espaco_amostral.

1.2.3.5 - Eventos

Um evento é um conjunto de resultados possíveis em um experimento aleatório. Em outras palavras, é um subconjunto do espaço amostral. Podemos dizer que um evento ocorre quando um ou mais resultados do espaço amostral são observados.

Os eventos podem ser classificados em diferentes tipos:

- Evento Simples: é um evento que contém apenas um resultado específico. Por exemplo, ao lançar um dado, obter o resultado "4" é um evento simples.

- Evento Composto: é um evento que contém mais de um resultado possível. Por exemplo, ao lançar um dado, obter um número par (2, 4 ou 6) é um evento composto.

- Evento Mutuamente Exclusivo: são eventos que não podem ocorrer simultaneamente. Se um evento acontece, o outro evento não pode ocorrer ao mesmo tempo. Por exemplo, ao lançar um dado, obter um número par e obter um número ímpar são eventos mutuamente exclusivos.

- Evento Independente: são eventos cuja ocorrência ou não ocorrência de um evento não afeta a probabilidade de ocorrência do outro evento. Por exemplo, ao lançar uma moeda, obter "cara" e obter "coroa" são eventos independentes.

1.2.3.5.1 - Evento Simples

Um evento simples contém apenas um resultado específico em um experimento aleatório. Em outras palavras, é um evento que ocorre quando um resultado específico do espaço amostral é observado. Os eventos simples são indivisíveis, pois não podem ser decompostos em subeventos menores.

Vamos considerar um experimento de lançamento de um dado de seis faces, onde queremos calcular a probabilidade de obter um resultado específico, como "4".

# Importando a biblioteca random para gerar números aleatórios

import random

# Definindo a função para simular o lançamento de um dado

def lancamento_dado():

return random.randint(1, 6)

# Definindo o número de experimentos

num_experimentos = 1000

# Contador para o número de vezes que o evento "4" ocorre

num_evento_4 = 0

# Realizando os experimentos

for _ in range(num_experimentos):

resultado = lancamento_dado()

if resultado == 4:

num_evento_4 += 1

# Calculando a probabilidade do evento "4"

probabilidade_4 = num_evento_4 / num_experimentos

# Imprimindo o resultado

print("Probabilidade de obter o resultado 4:", probabilidade_4)Neste exemplo, estamos simulando o lançamento de um dado em 1000 experimentos. A função lancamento_dado() retorna um número aleatório entre 1 e 6, simulando o lançamento do dado. Em cada experimento, verificamos se o resultado é igual a 4 e incrementamos o contador num_evento_4 se for o caso. Por fim, calculamos a probabilidade dividindo o número de vezes que o evento "4" ocorre pelo número total de experimentos.

É importante ressaltar que os eventos podem ser combinados usando operações de conjuntos, como união, interseção e complementaridade, para criar eventos mais complexos.

1.2.3.5.2 - Evento Composto

Um evento composto é um evento que ocorre quando dois ou mais resultados específicos de um experimento aleatório são observados. Em outras palavras, é a combinação de dois ou mais eventos simples. Os eventos compostos podem ser divididos em dois tipos principais: eventos unidos por "E" (interseção) e eventos unidos por "OU" (união).

- Evento Composto com "E" (Interseção): O evento ocorre quando ambos os eventos individuais ocorrem simultaneamente.

- Evento Composto com "OU" (União): O evento ocorre quando pelo menos um dos eventos individuais ocorre.

Vamos considerar um experimento de lançamento de uma moeda e um dado, onde queremos calcular a probabilidade de obter "cara" na moeda e "5" no dado. Faremos isso usando o operador lógico "E" para a interseção dos eventos.

# Importando a biblioteca random para gerar números aleatórios

import random

# Definindo a função para simular o lançamento de uma moeda

def lancamento_moeda():

return random.choice(['cara', 'coroa'])

# Definindo a função para simular o lançamento de um dado

def lancamento_dado():

return random.randint(1, 6)

# Definindo o número de experimentos

num_experimentos = 1000

# Contador para o número de vezes que o evento composto ocorre

num_evento_composto = 0

# Realizando os experimentos

for _ in range(num_experimentos):

resultado_moeda = lancamento_moeda()

resultado_dado = lancamento_dado()

if resultado_moeda == 'cara' and resultado_dado == 5:

num_evento_composto += 1

# Calculando a probabilidade do evento composto

probabilidade_evento_composto = num_evento_composto / num_experimentos

# Imprimindo o resultado

print("Probabilidade de obter 'cara' na moeda e '5' no dado:", probabilidade_evento_composto)Neste exemplo, estamos simulando o lançamento de uma moeda e um dado em 1000 experimentos. A função lancamento_moeda() retorna aleatoriamente "cara" ou "coroa" para simular o lançamento da moeda, e a função lancamento_dado() retorna um número aleatório entre 1 e 6 para simular o lançamento do dado. Em cada experimento, verificamos se o resultado da moeda é "cara" e o resultado do dado é 5, e incrementamos o contador num_evento_composto se ambos os eventos ocorrerem simultaneamente. Por fim, calculamos a probabilidade dividindo o número de vezes que o evento composto ocorre pelo número total de experimentos.

1.2.3.5.3 - Eventos Mutuamente Exclusivo

Dois eventos são considerados mutuamente exclusivos se eles não puderem ocorrer simultaneamente, ou seja, a ocorrência de um evento exclui a ocorrência do outro. Matematicamente, dois eventos $A$ e $B$ são mutuamente exclusivos se a interseção entre eles for vazia, ou seja, $A ∩ B = ∅$. Isso significa que se um evento ocorrer, o outro não pode ocorrer ao mesmo tempo.

Vamos considerar dois eventos: "obter um número par" e "obter um número ímpar" ao lançar um dado. Vamos calcular a probabilidade de ocorrer um dos eventos mutuamente exclusivos usando um exemplo de código Python.

# Importando a biblioteca random para gerar números aleatórios

import random

# Definindo a função para simular o lançamento de um dado

def lancamento_dado():

return random.randint(1, 6)

# Definindo o número de experimentos

num_experimentos = 1000

# Contadores para o número de vezes que cada evento ocorre

num_par = 0

num_impar = 0

# Realizando os experimentos

for _ in range(num_experimentos):

resultado = lancamento_dado()

if resultado % 2 == 0:

num_par += 1

else:

num_impar += 1

# Calculando a probabilidade de um dos eventos ocorrer

probabilidade_mutuamente_exclusivo = (num_par + num_impar) / num_experimentos

# Imprimindo os resultados

print("Probabilidade de ocorrer um número par ou ímpar:", probabilidade_mutuamente_exclusivo)

print("Probabilidade de ocorrer um número par:", num_par / num_experimentos)

print("Probabilidade de ocorrer um número ímpar:", num_impar / num_experimentos)Neste exemplo, estamos simulando o lançamento de um dado em 1000 experimentos. A função lancamento_dado() retorna um número aleatório entre 1 e 6 para simular o lançamento do dado. Em cada experimento, verificamos se o resultado é par ou ímpar e incrementamos os contadores num_par e num_impar de acordo. Por fim, calculamos a probabilidade de ocorrer um dos eventos mutuamente exclusivos dividindo o número de vezes que um dos eventos ocorre pelo número total de experimentos.

1.2.3.5.4 - Eventos Independentes

Dois eventos $A$ e $B$ são considerados independentes se a ocorrência (ou não ocorrência) de um evento não afeta a probabilidade do outro evento ocorrer. Em outras palavras, a probabilidade de ambos os eventos A e B ocorrerem é o produto das probabilidades individuais de cada evento. Matematicamente, dois eventos $A$ e $B$ são independentes se $P(A ∩ B) = P(A) × P(B)$.

Vamos considerar dois eventos: "obter cara em uma moeda" e "obter um número par em um dado". Vamos calcular a probabilidade de ambos os eventos ocorrerem simultaneamente usando um exemplo de código Python.

# Importando a biblioteca random para gerar números aleatórios

import random

# Definindo a função para simular o lançamento de uma moeda

def lancamento_moeda():

return random.choice(['cara', 'coroa'])

# Definindo a função para simular o lançamento de um dado

def lancamento_dado():

return random.randint(1, 6)

# Definindo o número de experimentos

num_experimentos = 1000

# Contadores para o número de vezes que ambos os eventos ocorrem

num_cara_e_par = 0

# Realizando os experimentos

for _ in range(num_experimentos):

resultado_moeda = lancamento_moeda()

resultado_dado = lancamento_dado()

if resultado_moeda == 'cara' and resultado_dado % 2 == 0:

num_cara_e_par += 1

# Calculando a probabilidade de ambos os eventos ocorrerem

probabilidade_independente = num_cara_e_par / num_experimentos

# Imprimindo o resultado

print("Probabilidade de obter cara e número par:", probabilidade_independente)Neste exemplo, estamos simulando o lançamento de uma moeda e um dado em 1000 experimentos. A função lancamento_moeda() retorna "cara" ou "coroa" para simular o lançamento da moeda, e a função lancamento_dado() retorna um número aleatório entre 1 e 6 para simular o lançamento do dado. Em cada experimento, verificamos se o resultado da moeda é "cara" e se o resultado do dado é par. Se ambos os eventos ocorrerem, incrementamos o contador num_cara_e_par. Por fim, calculamos a probabilidade de ambos os eventos ocorrerem dividindo o número de vezes que isso acontece pelo número total de experimentos.

1.2.3.6 - Interpretação Frequentista

A interpretação frequentista é uma das principais interpretações da probabilidade e baseia-se na frequência relativa de ocorrência de um evento em um grande número de experimentos repetidos. Segundo essa interpretação, a probabilidade de um evento é definida como a proporção de vezes que o evento ocorre em relação ao número total de experimentos.

De acordo com a interpretação frequentista, a probabilidade é uma propriedade objetiva do mundo físico e está diretamente relacionada à frequência com que um evento ocorre em uma série infinita de observações. Essa interpretação se baseia na ideia de que, à medida que o número de experimentos aumenta, a frequência relativa de ocorrência de um evento se aproxima de um valor constante, que é a probabilidade do evento.

Principais pontos da interpretação frequentista:

- Experimentos repetidos: a interpretação frequentista considera a repetição de um experimento em condições idênticas para obter uma série de resultados.

- Frequência relativa: a probabilidade é definida como a frequência relativa de ocorrência de um evento em relação ao número total de experimentos.

- Estabilidade no longo prazo: a interpretação frequentista assume que, à medida que o número de experimentos aumenta, a frequência relativa de um evento se aproxima de um valor constante, que representa a probabilidade do evento.

- Probabilidade como proporção: na interpretação frequentista, a probabilidade é expressa como uma proporção entre o número de vezes que um evento ocorre e o número total de experimentos.

- Limitações: essa interpretação requer a possibilidade de repetir um experimento em condições idênticas e não é aplicável a eventos únicos ou não repetíveis.

A interpretação frequentista é amplamente utilizada em estatística e na análise de dados, especialmente quando se trata de experimentos repetidos em que a probabilidade pode ser estimada com base na frequência relativa dos resultados observados.

É importante ressaltar que outras interpretações da probabilidade, como a interpretação subjetiva e a interpretação proporcional, também são utilizadas em diferentes contextos e abordagens teóricas.

1.2.3.6.1 - Experimentos repetidos

Experimentos repetidos referem-se à realização de um mesmo experimento várias vezes, com o objetivo de observar a frequência com que um evento ocorre ao longo dessas repetições. Isso está relacionado à interpretação frequentista da probabilidade, que se baseia na ideia de que a probabilidade de um evento é igual à frequência relativa com que ele ocorre em um grande número de experimentos repetidos. Vamos detalhar essa abordagem e fornecer um exemplo de código Python para ilustrar o conceito.

Na interpretação frequentista da probabilidade, consideramos um experimento que pode ser repetido um grande número de vezes, e o objetivo é observar a frequência com que um evento específico ocorre em relação ao número total de repetições. A ideia é que, à medida que o número de repetições aumenta, a frequência relativa do evento converge para a probabilidade do evento.

Para realizar experimentos repetidos, precisamos definir um procedimento experimental bem definido, no qual cada repetição do experimento seja idêntica às demais. Em seguida, executamos o experimento um grande número de vezes e registramos quantas vezes o evento de interesse ocorre.

A interpretação frequentista é amplamente utilizada em experimentos científicos e estudos estatísticos, pois nos permite fazer inferências sobre a probabilidade de eventos com base na observação empírica de sua frequência relativa em experimentos repetidos.

Vamos considerar um exemplo simples para ilustrar experimentos repetidos usando Python. Suponha que queremos simular o lançamento de um dado de seis faces e contar quantas vezes um número específico, como o número 4, aparece em um grande número de lançamentos. Usaremos a biblioteca random do Python para simular o lançamento do dado.

import random

def experimento_lancamento_dado():

# Simula o lançamento de um dado de seis faces

return random.randint(1, 6)

def experimentos_repetidos(n, evento):

# Realiza n experimentos repetidos

ocorrencias = 0

for _ in range(n):

resultado = experimento_lancamento_dado()

if resultado == evento:

ocorrencias += 1

return ocorrencias

# Configurações do experimento

num_repeticoes = 10000

numero_evento = 4

# Realiza os experimentos repetidos

ocorrencias_evento = experimentos_repetidos(num_repeticoes, numero_evento)

# Calcula a frequência relativa do evento

frequencia_relativa = ocorrencias_evento / num_repeticoes

# Imprime o resultado

print(f"A frequência relativa do número {numero_evento} é de {frequencia_relativa:.4f}")Nesse exemplo, realizamos 10.000 lançamentos do dado e contamos quantas vezes o número 4 apareceu. Em seguida, calculamos a frequência relativa dividindo o número de ocorrências do evento pelo número total de repetições. O resultado é impresso na tela.

Esse é apenas um exemplo básico para ilustrar como realizar experimentos repetidos e calcular a frequência relativa de um evento específico. Em problemas mais complexos, podem ser necessárias abordagens estatísticas mais avançadas para analisar os resultados dos experimentos repetidos e fazer inferências sobre a probabilidade dos eventos.

1.2.3.6.2 - Frequência relativa

Frequência relativa é um conceito importante na estatística e probabilidade que se refere à proporção de vezes em que um evento ocorre em relação ao número total de observações ou experimentos realizados. É uma medida empírica que nos permite estimar a probabilidade de um evento com base nos dados coletados. Vamos detalhar esse conceito e fornecer um exemplo de código Python para calcular a frequência relativa.

A frequência relativa é uma medida estatística que expressa a proporção de ocorrências de um evento em relação ao número total de observações ou experimentos. Ela é calculada dividindo-se o número de vezes em que o evento ocorre pelo número total de observações ou experimentos.

A frequência relativa é uma estimativa empírica da probabilidade de um evento. Quanto mais observações ou experimentos são realizados, maior é a precisão da estimativa. Se um evento tiver uma frequência relativa estável ao longo de um grande número de observações, podemos interpretar essa frequência como uma estimativa da probabilidade do evento.

A frequência relativa é expressa como uma proporção ou um valor decimal entre 0 e 1, ou como uma porcentagem entre 0% e 100%. Se um evento ocorre em todas as observações ou experimentos, sua frequência relativa é igual a 1 (ou 100%). Se um evento nunca ocorre, sua frequência relativa é igual a 0 (ou 0%).

Aqui está um exemplo simples de como calcular a frequência relativa usando Python. Suponha que temos uma lista de observações de um evento e queremos calcular a frequência relativa desse evento.

def calcular_frequencia_relativa(observacoes, evento):

ocorrencias = observacoes.count(evento)

total_observacoes = len(observacoes)

frequencia_relativa = ocorrencias / total_observacoes

return frequencia_relativa

# Exemplo de observações

observacoes = [1, 2, 3, 1, 4, 1, 5, 1, 6, 1]

# Evento a ser calculado a frequência relativa

evento = 1

# Cálculo da frequência relativa

frequencia = calcular_frequencia_relativa(observacoes, evento)

# Imprimir o resultado

print(f"A frequência relativa do evento {evento} é de {frequencia:.2f}")Neste exemplo, temos uma lista de observações [1, 2, 3, 1, 4, 1, 5, 1, 6, 1] e queremos calcular a frequência relativa do evento "1". A função calcular_frequencia_relativa recebe a lista de observações e o evento desejado, conta o número de ocorrências do evento na lista e divide pelo total de observações para obter a frequência relativa. O resultado é impresso na tela com duas casas decimais.

Lembre-se de que a frequência relativa é uma estimativa da probabilidade do evento com base nos dados observados. Quanto mais observações forem feitas, maior será a confiabilidade da estimativa.

1.2.3.6.3 - Estabilidade no longo prazo

Estabilidade no longo prazo é um conceito importante na probabilidade e estatística que se refere à consistência das estimativas de probabilidade ou frequência relativa à medida que o número de observações aumenta. Nesse contexto, "longo prazo" significa realizar um grande número de observações ou repetir um experimento muitas vezes. Vamos detalhar esse conceito e fornecer um exemplo de código Python para demonstrar a estabilidade no longo prazo.

A estabilidade no longo prazo é um princípio fundamental na probabilidade e estatística, relacionado à consistência das estimativas de probabilidade ou frequência relativa à medida que aumentamos o número de observações. O princípio afirma que, à medida que realizamos um número cada vez maior de observações ou repetimos um experimento muitas vezes, as estimativas de probabilidade ou frequência relativa se aproximam cada vez mais do valor verdadeiro.

Em termos simples, isso significa que a probabilidade estimada de um evento ou a frequência relativa desse evento tende a se estabilizar e se aproximar da probabilidade real à medida que coletamos mais dados. Por exemplo, se estivermos lançando uma moeda justa e registrando a frequência relativa de caras, à medida que o número de lançamentos aumenta, a frequência relativa se aproximará cada vez mais de 0,5, que é a probabilidade verdadeira de obter cara em um lançamento justo.

Esse conceito é importante porque nos permite fazer inferências mais precisas com base em um grande número de observações. Quanto mais estável uma estimativa é no longo prazo, mais confiáveis são as conclusões que podemos tirar dela.

Aqui está um exemplo simples em Python para ilustrar a estabilidade no longo prazo. Suponha que estamos lançando um dado equilibrado e queremos estimar a probabilidade de obter o número 6. Vamos realizar um grande número de lançamentos e verificar como a estimativa da probabilidade se aproxima do valor verdadeiro à medida que aumentamos o número de lançamentos.

import random

def estimar_probabilidade(numero_desejado, num_lancamentos):

ocorrencias = 0

for _ in range(num_lancamentos):

resultado = random.randint(1, 6)

if resultado == numero_desejado:

ocorrencias += 1

probabilidade = ocorrencias / num_lancamentos

return probabilidade

# Configurações do experimento

numero_desejado = 6

num_lancamentos = 10000

# Estimativa inicial da probabilidade

probabilidade_estimada = estimar_probabilidade(numero_desejado, num_lancamentos)

print(f"Estimativa inicial da probabilidade: {probabilidade_estimada:.4f}")

# Aumentar o número de lançamentos

num_lancamentos *= 10

probabilidade_estimada = estimar_probabilidade(numero_desejado, num_lancamentos)

print(f"Estimativa após {num_lancamentos} lançamentos: {probabilidade_estimada:.4f}")

# Aumentar o número de lançamentos novamente

num_lancamentos *= 10

probabilidade_estimada = estimar_probabilidade(numero_desejado, num_lancamentos)

print(f"Estimativa após {num_lancamentos} lançamentos: {probabilidade_estimada:.4f}")

# Aumentar o número de lançamentos novamente

num_lancamentos *= 10

probabilidade_estimada = estimar_probabilidade(numero_desejado, num_lancamentos)

print(f"Estimativa após {num_lancamentos} lançamentos: {probabilidade_estimada:.4f}")Neste exemplo, definimos uma função estimar_probabilidade que recebe o número desejado (6) e o número de lançamentos e retorna uma estimativa da probabilidade de obter esse número com base nos resultados dos lançamentos. A função utiliza a função random.randint para simular os lançamentos do dado. À medida que aumentamos o número de lançamentos, a função é chamada repetidamente para atualizar a estimativa da probabilidade.

Executando o código, podemos observar como a estimativa da probabilidade se aproxima do valor verdadeiro (1/6) à medida que aumentamos o número de lançamentos. Conforme o número de lançamentos aumenta, a estimativa se torna mais estável e converge para o valor verdadeiro. Isso demonstra o conceito de estabilidade no longo prazo na probabilidade e estatística.

1.2.3.6.4 - Probabilidade como proporção

Probabilidade como proporção é um conceito fundamental na teoria das probabilidades que define a probabilidade de um evento como a proporção de vezes em que esse evento ocorre em relação ao número total de possíveis ocorrências. Vamos detalhar esse conceito e fornecer um exemplo de código Python para ilustrar a ideia de probabilidade como proporção.

A interpretação da probabilidade como proporção é uma abordagem comum na teoria das probabilidades. Segundo essa interpretação, a probabilidade de um evento ocorrer é definida como a proporção de vezes em que esse evento ocorre em relação ao número total de possíveis ocorrências.

Em outras palavras, se temos um conjunto de eventos possíveis e realizamos um grande número de experimentos ou observações, a probabilidade de um evento específico ocorrer é dada pela razão entre o número de vezes que o evento ocorre e o número total de experimentos realizados.

Essa interpretação intuitiva é frequentemente usada em situações do mundo real. Por exemplo, considere o lançamento de um dado justo de seis faces. Se queremos calcular a probabilidade de obter o número 3, podemos realizar um grande número de lançamentos do dado e contar quantas vezes o número 3 aparece. A probabilidade de obter o número 3 será a razão entre o número de vezes que o número 3 ocorreu e o número total de lançamentos.

Aqui está um exemplo simples em Python para ilustrar o conceito de probabilidade como proporção. Vamos simular o lançamento de um dado justo e calcular a probabilidade de obter o número 3.

import random

def calcular_probabilidade(evento, num_lancamentos):

ocorrencias = 0

for _ in range(num_lancamentos):

resultado = random.randint(1, 6)

if resultado == evento:

ocorrencias += 1

probabilidade = ocorrencias / num_lancamentos

return probabilidade

# Configurações do experimento

evento = 3

num_lancamentos = 10000

# Calcular a probabilidade

probabilidade = calcular_probabilidade(evento, num_lancamentos)

print(f"A probabilidade de obter o número {evento} é: {probabilidade:.4f}")Neste exemplo, temos a função calcular_probabilidade que recebe o número do evento (3) e o número de lançamentos e retorna a probabilidade de obter esse número com base nos resultados dos lançamentos. Utilizamos a função random.randint para simular o lançamento do dado e contamos o número de vezes que o evento ocorre.