4 - Modelos de Regressão

4.1 Regressão linear múltipla

4.2 Modelos de regressão não linear

4.3 Modelos lineares generalizados

4.4 Análise de sobrevivência e modelos de risco proporcional

4.5 Regressão robusta e regressão de quantis

A análise de regressão é uma das ferramentas mais poderosas da estatística, permitindo-nos modelar e entender a relação entre variáveis e fazer previsões.

Exploraremos diferentes tipos de modelos de regressão, desde a regressão linear múltipla até técnicas mais avançadas e robustas.

- Regressão linear múltipla: Esta é uma extensão natural da regressão linear simples, permitindo-nos incorporar múltiplas variáveis independentes e examinar como elas se relacionam com a variável dependente. Veremos como ajustar o modelo, interpretar os coeficientes e realizar inferências sobre os efeitos das variáveis independentes. Além disso, discutiremos a importância das suposições do modelo e como diagnosticar sua adequação.

- Modelos com regressão não linear: Nem todas as relações entre variáveis podem ser adequadamente representadas por uma função linear. Portanto, aprenderemos sobre técnicas que permitem modelar relações não lineares, como curvas, polinômios e outras formas funcionais. Veremos como ajustar esses modelos e interpretar seus parâmetros, permitindo-nos capturar a complexidade das relações entre as variáveis.

- Modelos lineares generalizados (GLMs): Essa classe de modelos é uma generalização da regressão linear, permitindo-nos lidar com respostas que não seguem uma distribuição normal. Discutiremos diferentes famílias de distribuições e funções de ligação adequadas para cada tipo de resposta. Além disso, abordaremos a interpretação dos coeficientes e as inferências nos modelos GLMs.

- Análise de sobrevivência e nos modelos de risco proporcional: Esses modelos são amplamente utilizados em estudos de sobrevivência, nos quais estamos interessados em compreender o tempo até um evento ocorrer. Veremos como modelar a função de sobrevivência, estimar o risco relativo e lidar com censura dos dados. Esses modelos têm aplicações em áreas como medicina, engenharia e ciências sociais.

- Regressão robusta e a regressão de quantis: Essas técnicas são projetadas para lidar com dados que possuem características peculiares, como presença de outliers ou distribuições assimétricas. Veremos como esses modelos podem fornecer estimativas robustas e resistentes a influências atípicas, garantindo a estabilidade e confiabilidade das análises. Ao explorar os diferentes modelos de regressão neste capítulo, você terá uma compreensão aprofundada de suas aplicações, capacidades e limitações.

Aprenderá como ajustar esses modelos, interpretar seus resultados e realizar inferências adequadas.

Os modelos de regressão são uma poderosa ferramenta para extrair informações valiosas dos dados e fazer previsões precisas, permitindo-nos avançar na compreensão e no conhecimento em diversas áreas de estudo.

4.1 - Regressão linear múltipla (RLM)

A regressão linear múltipla (RLM) é uma extensão da regressão linear simples, na qual exploramos a relação entre uma variável dependente contínua e duas ou mais variáveis independentes.

Essa técnica nos permite modelar e entender como as variáveis independentes influenciam a variável dependente, levando em consideração os efeitos individuais de cada uma e suas interações.

No contexto da RLM, nosso objetivo é encontrar uma equação linear que relacione as variáveis independentes à variável dependente.

Essa equação é representada por:

- Y = β₀ + β₁X₁ + β₂X₂ + ... + βₚXₚ + ε

Onde:

- Y é a variável dependente que queremos prever;

- β₀ é o intercepto, que representa o valor médio esperado de Y quando todas as variáveis independentes são iguais a zero;

- β₁, β₂, ..., βₚ são os coeficientes de regressão que medem a influência das variáveis independentes (X₁, X₂, ..., Xₚ) em Y;

- X₁, X₂, ..., Xₚ são as variáveis independentes;

- ε é o termo de erro, que captura a variação não explicada pelo modelo.

Para estimar os coeficientes de regressão, utilizamos métodos como o método dos mínimos quadrados ordinários (OLS), que busca minimizar a soma dos quadrados dos resíduos.

Ao ajustar o modelo, também é importante verificar se as suposições da regressão linear múltipla são atendidas, como a linearidade, independência dos resíduos, homoscedasticidade e normalidade dos resíduos.

A RLM oferece várias vantagens, como permitir controlar e avaliar o efeito de múltiplas variáveis independentes simultaneamente, fornecendo uma visão mais completa e precisa das relações entre as variáveis, ou permitir realizar inferências sobre os coeficientes de regressão, como testes de significância e construção de intervalos de confiança.

A interpretação dos resultados da regressão linear múltipla envolve analisar os coeficientes de regressão para entender o efeito marginal de cada variável independente na variável dependente, levando em consideração as outras variáveis independentes presentes no modelo.

Também podemos avaliar a qualidade do ajuste do modelo por meio de métricas como o coeficiente de determinação (R²) e o erro padrão residual.

Nessa seção dedicada à RLM, você explorará em detalhes como ajustar e interpretar modelos de regressão com várias variáveis independentes, realizar inferências sobre os coeficientes e avaliar a adequação do modelo.

Você também aprenderá sobre técnicas avançadas, como a seleção de variáveis, diagnóstico de multicolinearidade e transformação de variáveis para melhorar o ajuste do modelo.

A regressão linear múltipla é uma ferramenta essencial para a análise de dados e a tomada de decisões em diversas áreas, desde as ciências sociais até a econometria e a pesquisa de mercado.

4.1.1 - Método dos mínimos quadrados ordinários (OLS)

O método dos mínimos quadrados ordinários (OLS) é uma técnica amplamente utilizada para estimar os coeficientes de um modelo de regressão linear.

Ele busca encontrar os valores dos coeficientes que minimizam a soma dos quadrados dos resíduos, ou seja, a diferença entre os valores observados e os valores previstos pelo modelo.

Aqui está um exemplo de código Python que demonstra como aplicar o método dos mínimos quadrados ordinários utilizando a biblioteca statsmodels:

import numpy as np

import statsmodels.api as sm

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([2, 4, 5, 4, 6])

# Adicionando uma coluna de uns para representar a constante no modelo

X = sm.add_constant(x)

# Ajustando o modelo OLS aos dados

model = sm.OLS(y, X)

results = model.fit()

# Obtendo os coeficientes estimados

coefficients = results.params

# Obtendo o resíduo padrão

residuals = results.resid

# Exibindo os resultados

print("Coeficientes estimados:", coefficients)

print("Resíduo padrão:", np.std(residuals))Neste exemplo, temos uma variável independente x e uma variável dependente y.

Primeiro, adicionamos uma coluna de uns à matriz X usando a função sm.add_constant(), para representar a constante no modelo de regressão.

Em seguida, ajustamos o modelo OLS aos dados usando sm.OLS(y, X) e chamamos o método fit() para obter os resultados da regressão.

Os coeficientes estimados são armazenados em results.params.

Podemos calcular o resíduo padrão, que é uma medida da dispersão dos resíduos, usando results.resid e a função np.std(residuals).

Por fim, os resultados são exibidos na saída.

Certifique-se de ter a biblioteca statsmodels instalada para executar o código acima.

Você pode instalá-la usando o comando pip install statsmodels.

Ao ajustar um modelo de regressão linear múltipla utilizando o método dos mínimos quadrados ordinários (OLS), é importante verificar se as suposições da regressão linear estão sendo atendidas.

Essas suposições incluem a linearidade da relação entre as variáveis independentes e dependentes, a independência dos resíduos, a homoscedasticidade e a normalidade dos resíduos.

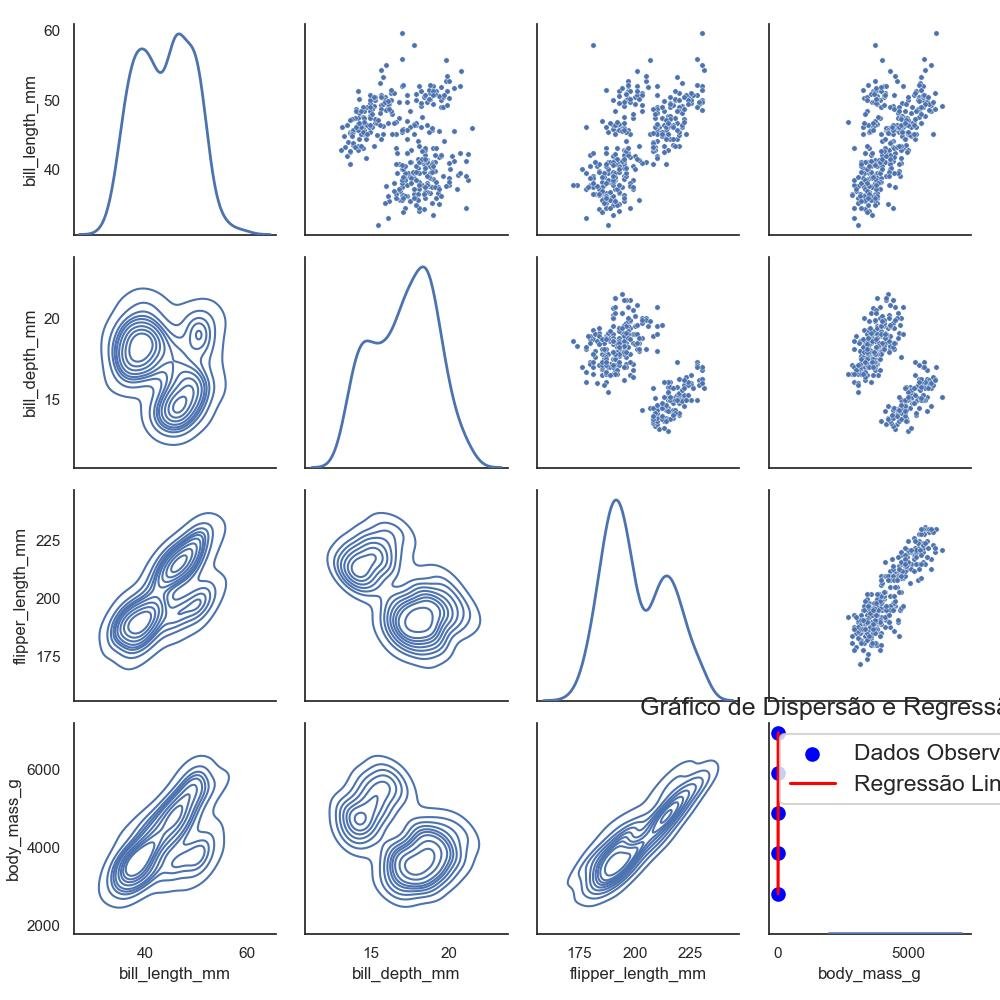

- Linearidade: A suposição de linearidade indica que a relação entre as variáveis independentes e a variável dependente é linear. Isso significa que os coeficientes estimados no modelo capturam adequadamente a relação linear entre as variáveis. Você pode verificar a linearidade visualizando gráficos de dispersão dos dados e avaliando se eles apresentam um padrão linear.

- Independência dos resíduos: A suposição de independência dos resíduos significa que os resíduos do modelo não devem apresentar padrões ou dependências sistemáticas. Isso implica que não deve haver correlação entre os resíduos e nenhuma estrutura de autocorrelação nos dados. Para verificar a independência dos resíduos, você pode examinar um gráfico de resíduos versus valores ajustados e também pode realizar testes estatísticos específicos para detectar a presença de autocorrelação.

- Homoscedasticidade: A suposição de homoscedasticidade indica que a variância dos resíduos é constante em todas as faixas de valores das variáveis independentes. Em outras palavras, os resíduos não devem mostrar um padrão de aumento ou diminuição da variância à medida que os valores das variáveis independentes mudam. Você pode verificar a homoscedasticidade visualizando um gráfico de resíduos versus valores ajustados ou utilizando testes estatísticos, como o teste de Breusch-Pagan ou o teste de White.

- Normalidade dos resíduos: A suposição de normalidade dos resíduos indica que os resíduos devem seguir uma distribuição normal. Isso é importante para realizar inferências estatísticas válidas e para garantir a precisão dos intervalos de confiança e dos testes de hipóteses. Você pode verificar a normalidade dos resíduos visualizando um gráfico de resíduos em relação a uma distribuição normal ou utilizando testes estatísticos, como o teste de normalidade de Shapiro-Wilk ou o teste de Kolmogorov-Smirnov.

Ao verificar essas suposições, é importante considerar que nem sempre elas serão estritamente atendidas.

Em alguns casos, pequenas violações podem ser toleradas, desde que não afetem substancialmente as inferências do modelo.

Se as suposições não forem atendidas de forma adequada, podem ser necessárias transformações nos dados, a inclusão de variáveis de controle ou a consideração de modelos alternativos.

Avaliar essas suposições é uma etapa crítica na análise de regressão linear, pois garante que os resultados do modelo sejam confiáveis e que as interpretações corretas possam ser feitas.

4.1.1.1 - Linearidade

Aqui está um exemplo de código em Python para verificar a linearidade em um modelo de regressão linear múltipla.

Vamos usar a biblioteca matplotlib para criar um gráfico de dispersão dos dados e traçar a linha de regressão.

import numpy as np

import matplotlib.pyplot as plt

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([2, 4, 6, 8, 10])

# Ajuste do modelo de regressão

coefficients = np.polyfit(x, y, 1) # Grau 1 para uma regressão linear

poly = np.poly1d(coefficients)

y_pred = poly(x)

# Plotagem do gráfico de dispersão e linha de regressão

plt.scatter(x, y, color='blue', label='Dados Observados')

plt.plot(x, y_pred, color='red', label='Regressão Linear')

plt.xlabel('Variável Independente (x)')

plt.ylabel('Variável Dependente (y)')

plt.title('Gráfico de Dispersão e Regressão Linear')

plt.legend()

plt.show()

Neste exemplo, os dados são representados pelos arrays x e y.

Utilizamos a função np.polyfit para ajustar uma linha de regressão linear aos dados, com grau 1.

Em seguida, usamos a função np.poly1d para criar um polinômio com base nos coeficientes obtidos.

Com o polinômio, podemos gerar as previsões y_pred para os valores de x e traçar a linha de regressão usando plt.plot.

Também adicionamos os pontos de dados originais usando plt.scatter.

Ao executar esse código, você verá um gráfico de dispersão dos dados observados e uma linha de regressão linear que melhor se ajusta aos dados.

A visualização pode ajudar a identificar padrões lineares e avaliar se a suposição de linearidade é atendida.

4.1.1.2 - Independência dos resíduos

Aqui está um exemplo de código em Python para verificar a independência dos resíduos em um modelo de regressão linear múltipla.

Vamos usar a biblioteca statsmodels para ajustar o modelo e extrair os resíduos, e em seguida, usaremos o teste de Durbin-Watson para verificar a autocorrelação dos resíduos.

import numpy as np

import statsmodels.api as sm

from statsmodels.stats.stattools import durbin_watson

# Dados de exemplo

x1 = np.array([1, 2, 3, 4, 5])

x2 = np.array([2, 4, 6, 8, 10])

y = np.array([3, 5, 7, 9, 11])

# Adicionando uma coluna de 1's para o termo constante

X = np.column_stack((x1, x2, np.ones(len(x1))))

# Ajuste do modelo de regressão linear

model = sm.OLS(y, X)

results = model.fit()

# Cálculo dos resíduos

residuals = results.resid

# Teste de Durbin-Watson para autocorrelação dos resíduos

durbin_watson_statistic = durbin_watson(residuals)

# Impressão do resultado do teste

print("Estatística de Durbin-Watson:", durbin_watson_statistic)Neste exemplo, os dados são representados pelos arrays x1, x2 e y.

Utilizamos a biblioteca statsmodels para ajustar um modelo de regressão linear utilizando a função sm.OLS.

Em seguida, extraímos os resíduos do modelo ajustado usando results.resid.

Por fim, aplicamos o teste de Durbin-Watson aos resíduos utilizando a função durbin_watson da biblioteca statsmodels.stats.stattools.

O valor retornado é a estatística de Durbin-Watson, que varia de 0 a 4.

Valores próximos a 2 indicam independência dos resíduos, enquanto valores significativamente diferentes de 2 podem indicar autocorrelação.

Ao executar esse código, você obterá a estatística de Durbin-Watson, que é uma medida da autocorrelação dos resíduos.

Valores próximos a 2 sugerem independência dos resíduos, enquanto valores diferentes de 2 indicam a presença de autocorrelação.

É importante ressaltar que outros métodos e gráficos também podem ser usados para verificar a independência dos resíduos, como o gráfico de autocorrelação dos resíduos.

4.1.1.3 - Homoscedasticidade

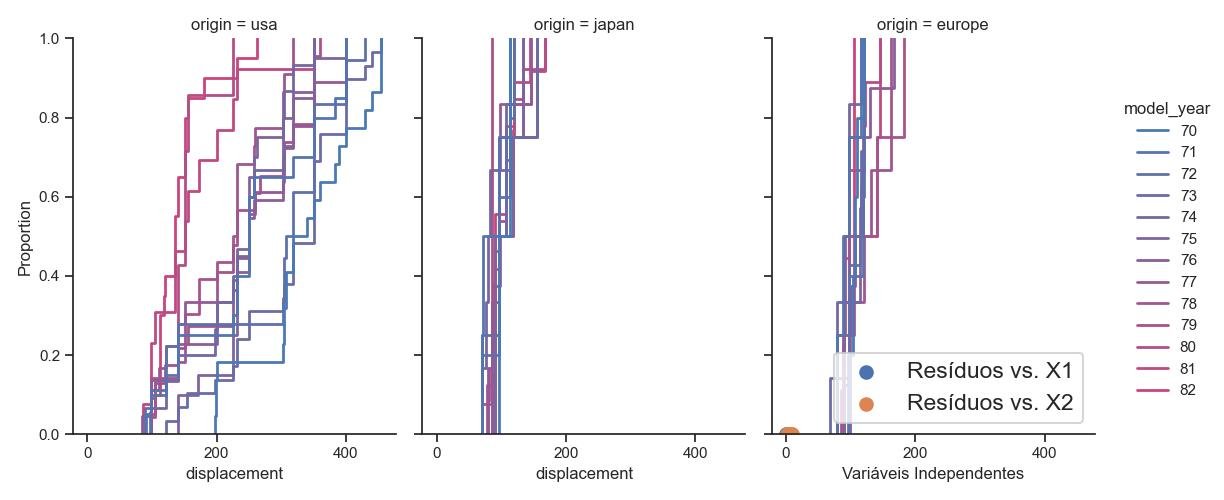

Aqui está um exemplo de código em Python para verificar a homoscedasticidade dos resíduos em um modelo de regressão linear múltipla.

Utilizaremos a biblioteca statsmodels para ajustar o modelo e extrair os resíduos, e em seguida faremos um gráfico dos resíduos em relação às variáveis independentes.

import numpy as np

import statsmodels.api as sm

import matplotlib.pyplot as plt

# Dados de exemplo

x1 = np.array([1, 2, 3, 4, 5])

x2 = np.array([2, 4, 6, 8, 10])

y = np.array([3, 5, 7, 9, 11])

# Adicionando uma coluna de 1's para o termo constante

X = np.column_stack((x1, x2, np.ones(len(x1))))

# Ajuste do modelo de regressão linear

model = sm.OLS(y, X)

results = model.fit()

# Cálculo dos resíduos

residuals = results.resid

# Gráfico dos resíduos em relação às variáveis independentes

plt.scatter(x1, residuals, label='Resíduos vs. X1')

plt.scatter(x2, residuals, label='Resíduos vs. X2')

plt.xlabel('Variáveis Independentes')

plt.ylabel('Resíduos')

plt.legend()

plt.show()

Neste exemplo, os dados são representados pelos arrays x1, x2 e y.

Utilizamos a biblioteca statsmodels para ajustar um modelo de regressão linear utilizando a função sm.OLS.

Em seguida, extraímos os resíduos do modelo ajustado usando results.resid.

Por fim, plotamos os resíduos em relação às variáveis independentes usando a biblioteca matplotlib.

Ao executar esse código, você obterá um gráfico de dispersão dos resíduos em relação às variáveis independentes.

A homoscedasticidade dos resíduos é caracterizada por uma distribuição aleatória e uniforme dos pontos em torno da linha horizontal zero.

Se houver um padrão discernível ou uma tendência nos pontos, isso pode indicar a presença de heteroscedasticidade nos resíduos.

É importante ressaltar que existem outros métodos estatísticos para verificar a homoscedasticidade, como o teste de Breusch-Pagan ou o teste de White.

O gráfico de dispersão é apenas uma ferramenta visual inicial para identificar possíveis violações da homoscedasticidade.

4.1.1.3.1 - Teste de Breusch-Pagan

Aqui está um exemplo de código em Python para realizar o teste de Breusch-Pagan para verificar a homoscedasticidade em um modelo de regressão linear múltipla. Utilizaremos a biblioteca statsmodels para ajustar o modelo e realizar o teste.

import numpy as np

import statsmodels.api as sm

from statsmodels.compat import lzip

from statsmodels.stats.diagnostic import het_breuschpagan

# Dados de exemplo

x1 = np.array([1, 2, 3, 4, 5])

x2 = np.array([2, 4, 6, 8, 10])

y = np.array([3, 5, 7, 9, 11])

# Adicionando uma coluna de 1's para o termo constante

X = np.column_stack((x1, x2, np.ones(len(x1))))

# Ajuste do modelo de regressão linear

model = sm.OLS(y, X)

results = model.fit()

# Cálculo dos resíduos

residuals = results.resid

# Teste de Breusch-Pagan

bp_test = het_breuschpagan(residuals, X)

# Extraindo as estatísticas do teste

test_statistic = bp_test[0]

p_value = bp_test[1]

# Imprimindo os resultados

print('Estatística do teste:', test_statistic)

print('Valor-p:', p_value)Neste exemplo, os dados são representados pelos arrays x1, x2 e y.

Utilizamos a biblioteca statsmodels para ajustar um modelo de regressão linear utilizando a função sm.OLS.

Em seguida, calculamos os resíduos do modelo ajustado usando results.resid.

Utilizamos a função het_breuschpagan da biblioteca statsmodels.stats.diagnostic para realizar o teste de Breusch-Pagan.

Essa função retorna a estatística do teste e o valor-p associado.

Ao executar esse código, você obterá a estatística do teste de Breusch-Pagan e o valor-p correspondente.

Se o valor-p for menor que um nível de significância escolhido (por exemplo, 0.05), pode-se rejeitar a hipótese nula de homoscedasticidade, indicando a presença de heteroscedasticidade nos resíduos.

É importante destacar que existem outros métodos estatísticos para verificar a homoscedasticidade, como o teste de White e o teste de Goldfeld-Quandt.

O teste de Breusch-Pagan é apenas um dos métodos disponíveis para essa finalidade.

4.1.1.3.2 - Teste de White

Aqui está um exemplo de código em Python para realizar o teste de White para verificar a homoscedasticidade em um modelo de regressão linear múltipla.

Utilizaremos a biblioteca statsmodels para ajustar o modelo e realizar o teste.

import numpy as np

import statsmodels.api as sm

from statsmodels.compat import lzip

from statsmodels.stats.diagnostic import het_white

# Dados de exemplo

x1 = np.array([1, 2, 3, 4, 5])

x2 = np.array([2, 4, 6, 8, 10])

y = np.array([3, 5, 7, 9, 11])

# Adicionando uma coluna de 1's para o termo constante

X = np.column_stack((x1, x2, np.ones(len(x1))))

# Ajuste do modelo de regressão linear

model = sm.OLS(y, X)

results = model.fit()

# Cálculo dos resíduos

residuals = results.resid

# Teste de White

white_test = het_white(residuals, X)

# Extraindo as estatísticas do teste

test_statistic = white_test[0]

p_value = white_test[1]

# Imprimindo os resultados

print('Estatística do teste:', test_statistic)

print('Valor-p:', p_value)Neste exemplo, os dados são representados pelos arrays x1, x2 e y.

Utilizamos a biblioteca statsmodels para ajustar um modelo de regressão linear utilizando a função sm.OLS.

Em seguida, calculamos os resíduos do modelo ajustado usando results.resid.

Utilizamos a função het_white da biblioteca statsmodels.stats.diagnostic para realizar o teste de White.

Essa função retorna a estatística do teste e o valor-p associado.

Ao executar esse código, você obterá a estatística do teste de White e o valor-p correspondente.

Se o valor-p for menor que um nível de significância escolhido (por exemplo, 0.05), pode-se rejeitar a hipótese nula de homoscedasticidade, indicando a presença de heteroscedasticidade nos resíduos.

É importante destacar que o teste de White é apenas um dos métodos disponíveis para verificar a homoscedasticidade, e outros testes, como o teste de Breusch-Pagan, também podem ser utilizados para esse propósito.

4.1.1.4 - Normalidade dos resíduos

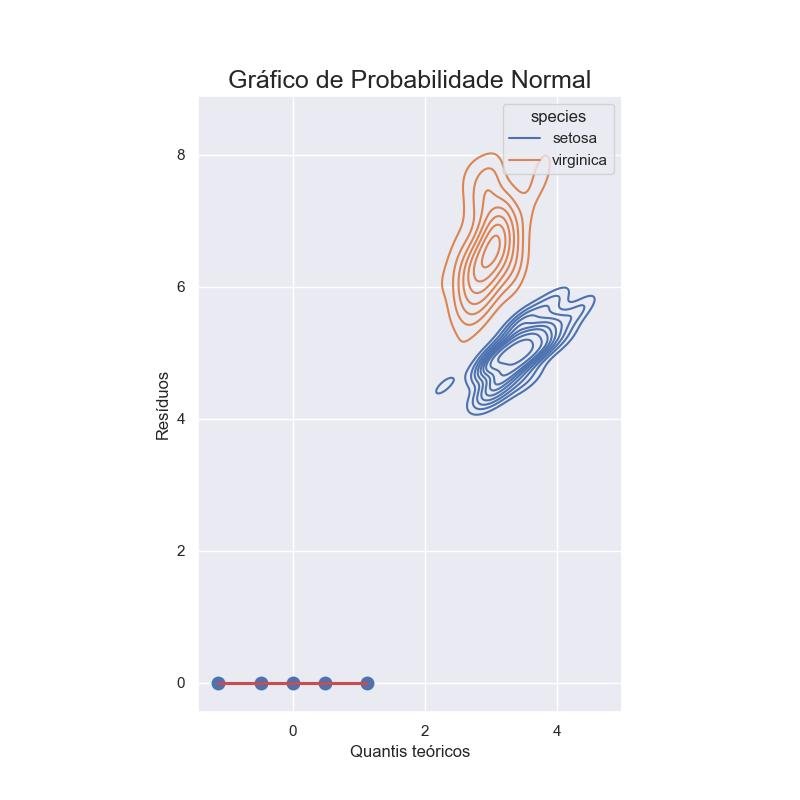

Aqui está um exemplo de código em Python para verificar a normalidade dos resíduos em um modelo de regressão linear múltipla.

Utilizaremos a biblioteca statsmodels para ajustar o modelo e extrair os resíduos, e em seguida faremos um gráfico de probabilidade normal dos resíduos.

import numpy as np

import statsmodels.api as sm

import matplotlib.pyplot as plt

import scipy.stats as stats

# Dados de exemplo

x1 = np.array([1, 2, 3, 4, 5])

x2 = np.array([2, 4, 6, 8, 10])

y = np.array([3, 5, 7, 9, 11])

# Adicionando uma coluna de 1's para o termo constante

X = np.column_stack((x1, x2, np.ones(len(x1))))

# Ajuste do modelo de regressão linear

model = sm.OLS(y, X)

results = model.fit()

# Cálculo dos resíduos

residuals = results.resid

# Gráfico de probabilidade normal dos resíduos

stats.probplot(residuals, dist='norm', plot=plt)

plt.xlabel('Quantis teóricos')

plt.ylabel('Resíduos')

plt.title('Gráfico de Probabilidade Normal')

plt.show()

Neste exemplo, os dados são representados pelos arrays x1, x2 e y. Utilizamos a biblioteca statsmodels para ajustar um modelo de regressão linear utilizando a função sm.OLS.

Em seguida, extraímos os resíduos do modelo ajustado usando results.resid. Por fim, plotamos um gráfico de probabilidade normal dos resíduos utilizando a função stats.probplot da biblioteca scipy.stats e a biblioteca matplotlib.

Ao executar esse código, você obterá um gráfico de probabilidade normal dos resíduos.

Se os resíduos seguirem aproximadamente uma distribuição normal, os pontos no gráfico devem se alinhar aproximadamente com a linha diagonal.

Se houver desvios significativos em relação à linha diagonal, isso pode indicar a presença de não normalidade nos resíduos.

É importante ressaltar que existem outros métodos estatísticos para verificar a normalidade dos resíduos, como o teste de normalidade de Shapiro-Wilk ou o teste de Kolmogorov-Smirnov.

O gráfico de probabilidade normal é apenas uma ferramenta visual inicial para verificar a normalidade dos resíduos.

4.1.1.4.1 - Teste de Shapiro-Wilk

Aqui está um exemplo de código em Python para realizar o teste de Shapiro-Wilk para verificar a normalidade dos resíduos em um modelo de regressão linear múltipla. Utilizaremos a biblioteca statsmodels para ajustar o modelo e realizar o teste.

import numpy as np

import statsmodels.api as sm

from scipy.stats import shapiro

# Dados de exemplo

x1 = np.array([1, 2, 3, 4, 5])

x2 = np.array([2, 4, 6, 8, 10])

y = np.array([3, 5, 7, 9, 11])

# Adicionando uma coluna de 1's para o termo constante

X = np.column_stack((x1, x2, np.ones(len(x1))))

# Ajuste do modelo de regressão linear

model = sm.OLS(y, X)

results = model.fit()

# Cálculo dos resíduos

residuals = results.resid

# Teste de Shapiro-Wilk

shapiro_test = shapiro(residuals)

# Extraindo as estatísticas do teste

test_statistic = shapiro_test.statistic

p_value = shapiro_test.pvalue

# Imprimindo os resultados

print('Estatística do teste:', test_statistic)

print('Valor-p:', p_value)Neste exemplo, os dados são representados pelos arrays x1, x2 e y.

Utilizamos a biblioteca statsmodels para ajustar um modelo de regressão linear utilizando a função sm.OLS.

Em seguida, calculamos os resíduos do modelo ajustado usando results.resid.

Utilizamos a função shapiro da biblioteca scipy.stats para realizar o teste de Shapiro-Wilk.

Essa função retorna a estatística do teste e o valor-p associado.

Ao executar esse código, você obterá a estatística do teste de Shapiro-Wilk e o valor-p correspondente.

Se o valor-p for maior que um nível de significância escolhido (por exemplo, 0.05), não há evidências suficientes para rejeitar a hipótese nula de normalidade dos resíduos.

Lembre-se de que o teste de Shapiro-Wilk é apenas um dos métodos disponíveis para verificar a normalidade dos resíduos, e outros testes, como o teste de Kolmogorov-Smirnov ou o teste de Anderson-Darling, também podem ser utilizados para esse propósito.

4.1.1.4.2 - Teste de Kolmogorov-Smirnov

Aqui está um exemplo de código em Python para realizar o teste de Kolmogorov-Smirnov para verificar a normalidade dos resíduos em um modelo de regressão linear múltipla. Utilizaremos a biblioteca statsmodels para ajustar o modelo e a biblioteca scipy.stats para realizar o teste.

import numpy as np

import statsmodels.api as sm

from scipy.stats import kstest

# Dados de exemplo

x1 = np.array([1, 2, 3, 4, 5])

x2 = np.array([2, 4, 6, 8, 10])

y = np.array([3, 5, 7, 9, 11])

# Adicionando uma coluna de 1's para o termo constante

X = np.column_stack((x1, x2, np.ones(len(x1))))

# Ajuste do modelo de regressão linear

model = sm.OLS(y, X)

results = model.fit()

# Cálculo dos resíduos

residuals = results.resid

# Teste de Kolmogorov-Smirnov

ks_test = kstest(residuals, 'norm')

# Extraindo as estatísticas do teste

test_statistic = ks_test.statistic

p_value = ks_test.pvalue

# Imprimindo os resultados

print('Estatística do teste:', test_statistic)

print('Valor-p:', p_value)Neste exemplo, os dados são representados pelos arrays x1, x2 e y.

Utilizamos a biblioteca statsmodels para ajustar um modelo de regressão linear utilizando a função sm.OLS.

Em seguida, calculamos os resíduos do modelo ajustado usando results.resid.

Utilizamos a função kstest da biblioteca scipy.stats para realizar o teste de Kolmogorov-Smirnov.

Essa função retorna a estatística do teste e o valor-p associado.

Ao executar esse código, você obterá a estatística do teste de Kolmogorov-Smirnov e o valor-p correspondente.

Se o valor-p for maior que um nível de significância escolhido (por exemplo, 0.05), não há evidências suficientes para rejeitar a hipótese nula de normalidade dos resíduos.

Lembre-se de que o teste de Kolmogorov-Smirnov é apenas um dos métodos disponíveis para verificar a normalidade dos resíduos, e outros testes, como o teste de Shapiro-Wilk ou o teste de Anderson-Darling, também podem ser utilizados para esse propósito.

4.2 - Modelos com regressão não linear

Os modelos com regressão não linear são uma extensão dos modelos de regressão que permitem capturar relações mais complexas entre as variáveis independentes e dependentes.

Enquanto a regressão linear assume uma relação linear entre essas variáveis, os modelos não lineares permitem modelar relações não lineares, curvilíneas ou de outra forma não convencionais.

A regressão não linear é especialmente útil quando a relação entre as variáveis não pode ser adequadamente descrita por uma linha reta.

Nesses casos, é necessário utilizar funções não lineares para descrever a relação entre as variáveis independentes e dependentes.

Isso pode ser aplicado a uma ampla variedade de áreas, como ciências naturais, engenharia, medicina, economia e muitas outras.

Existem várias formas de modelar a regressão não linear, e a escolha do modelo adequado depende da natureza dos dados e das hipóteses subjacentes.

Alguns exemplos comuns incluem modelos polinomiais, modelos exponenciais, modelos logísticos, modelos de potência, modelos de saturação e muitos outros.

Cada modelo tem sua própria forma funcional, que descreve como as variáveis independentes se relacionam com a variável dependente.

Para ajustar um modelo de regressão não linear, é necessário estimar os parâmetros que descrevem a relação entre as variáveis.

Isso geralmente é feito por meio de métodos de otimização, nos quais o objetivo é encontrar os valores dos parâmetros que minimizam a diferença entre os valores observados e os valores previstos pelo modelo.

A interpretação dos resultados dos modelos de regressão não linear pode variar dependendo do tipo de modelo utilizado.

Em alguns casos, os coeficientes estimados têm interpretações diretas, como em modelos polinomiais.

Em outros casos, a interpretação pode ser mais complexa e envolver a análise de curvas ou padrões específicos.

Os modelos de regressão não linear oferecem uma maior flexibilidade para modelar relações complexas entre variáveis e capturar nuances que não podem ser capturadas pela regressão linear.

No entanto, também apresentam desafios adicionais, como a escolha adequada do modelo, a interpretação dos resultados e a validação do ajuste do modelo.

Nessa seção dedicada aos modelos com regressão não linear, você explorará diferentes tipos de modelos não lineares, aprenderá como ajustá-los aos dados, interpretar os resultados e avaliar a adequação do modelo.

Além disso, discutirá técnicas avançadas, como a seleção de variáveis, diagnóstico de resíduos e avaliação da robustez dos resultados.

A compreensão e aplicação adequada dos modelos com regressão não linear são essenciais para análises mais precisas e confiáveis em uma ampla gama de áreas de pesquisa e prática.

4.2.1 - Modelos com regressão não linear

Existem diversos modelos não lineares que podem ser utilizados para descrever relações complexas entre variáveis.

Abaixo estão alguns exemplos comuns de modelos não lineares:

- Regressão Polinomial: este modelo representa uma relação polinomial entre a variável resposta e as variáveis preditoras. Pode ser expresso como uma equação polinomial, como por exemplo: y = β0 + β1x + β2x^2 + β3x^3 + ... + βnx^n. Neste caso, os coeficientes β representam os parâmetros do modelo.

- Regressão Exponencial: este modelo descreve uma relação exponencial entre a variável resposta e as variáveis preditoras. Pode ser utilizado quando a taxa de crescimento ou de decaimento dos dados é exponencial. A equação geralmente é da forma: y = β0 * exp(β1x). O coeficiente β1 controla o crescimento ou decaimento exponencial e o coeficiente β0 representa a interseção no eixo y.

- Regressão Logarítmica: este modelo é utilizado quando se deseja ajustar uma curva logarítmica a um conjunto de dados. Esse modelo é especialmente útil quando os dados têm uma tendência de crescimento ou decaimento logarítmico ao longo do tempo ou de acordo com uma variável explicativa.

- Regressão Logística: Este modelo é utilizado quando a variável resposta é binária ou categórica. Ele modela a probabilidade de ocorrência de um evento em função das variáveis preditoras. A equação da regressão logística é dada por: log(p/(1-p)) = β0 + β1x1 + β2x2 + ... + βnxn, onde p é a probabilidade do evento ocorrer, e os coeficientes β representam os parâmetros do modelo.

- Regressão de Splines: As splines são curvas suaves que são utilizadas para modelar relações não lineares. A regressão de splines consiste em ajustar várias curvas polinomiais suaves em segmentos dos dados, que se juntam para formar uma curva contínua. Essa abordagem permite capturar padrões complexos nos dados.

- Redes Neurais: As redes neurais são modelos computacionais inspirados no funcionamento do cérebro humano. Elas são compostas por camadas de neurônios interconectados e são capazes de modelar relações não lineares complexas. As redes neurais são especialmente úteis para tarefas de aprendizado de máquina e têm sido amplamente aplicadas em áreas como reconhecimento de padrões, processamento de imagens e análise de dados.

Esses são apenas alguns exemplos de modelos não lineares.

Existem muitos outros, como modelos de séries temporais, modelos de crescimento populacional, modelos de árvores de decisão, entre outros.

A escolha do modelo adequado dependerá do tipo de relação que se deseja capturar e dos dados disponíveis.

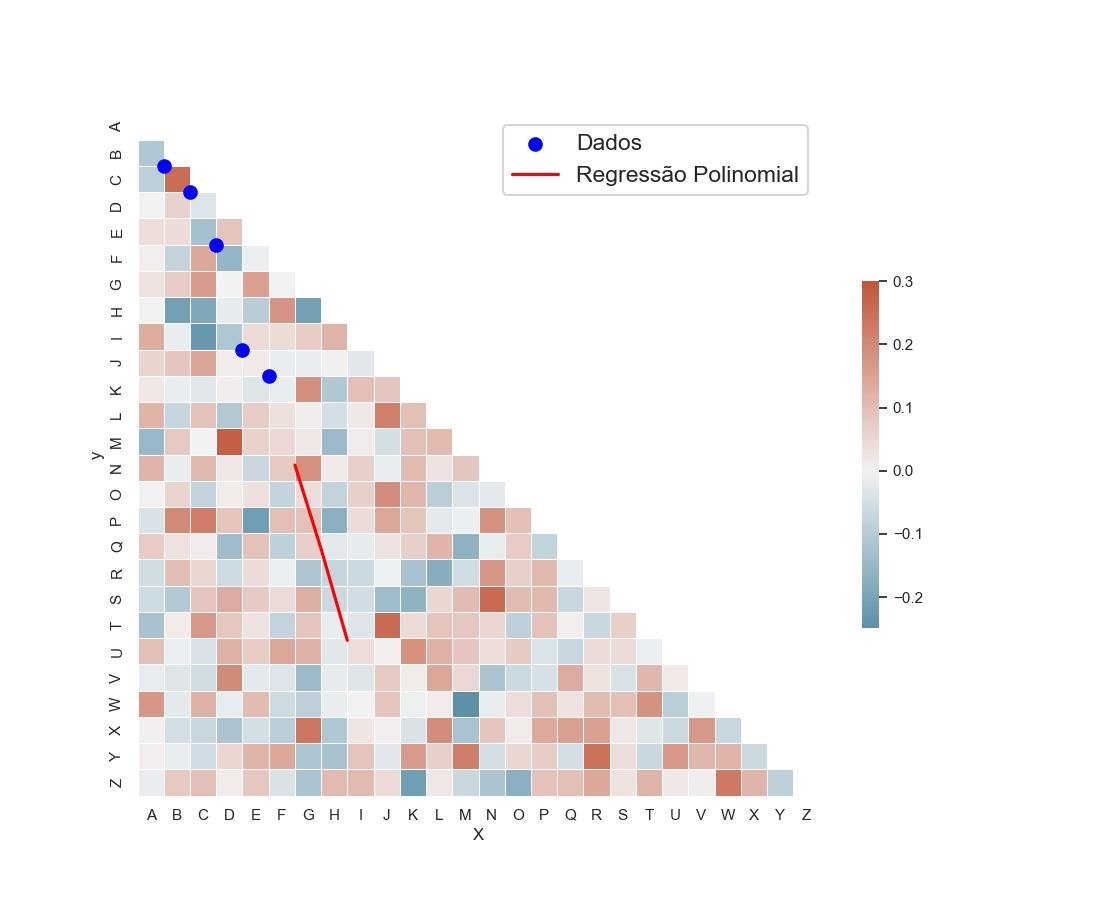

4.2.1.1 - Regressão Polinomial

A regressão polinomial é uma técnica utilizada para modelar relações não lineares entre variáveis por meio de equações polinomiais.

Ela é uma extensão da regressão linear simples, permitindo ajustar curvas mais flexíveis aos dados.

A ideia é adicionar termos polinomiais de diferentes graus à equação de regressão, o que permite capturar padrões mais complexos.

A regressão polinomial pode ser implementada em Python utilizando bibliotecas como NumPy e Scikit-Learn.

A seguir, um exemplo de código que ilustra o processo de ajuste de uma regressão polinomial de grau 2:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import LinearRegression

from sklearn.preprocessing import PolynomialFeatures

# Dados de exemplo

X = np.array([1, 2, 3, 4, 5])

y = np.array([2, 3, 5, 9, 10])

# Transformando as features em matriz polinomial

poly_features = PolynomialFeatures(degree=2, include_bias=False)

X_poly = poly_features.fit_transform(X.reshape(-1, 1))

# Ajustando a regressão polinomial

model = LinearRegression()

model.fit(X_poly, y)

# Predição

X_test = np.array([6, 7, 8])

X_test_poly = poly_features.transform(X_test.reshape(-1, 1))

y_pred = model.predict(X_test_poly)

# Plot dos resultados

plt.scatter(X, y, color='blue', label='Dados')

plt.plot(X_test, y_pred, color='red', label='Regressão Polinomial')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.show()

Neste exemplo, primeiro criamos uma matriz polinomial a partir dos dados de entrada X, utilizando a classe PolynomialFeatures do Scikit-Learn.

Definimos o grau do polinômio como 2, indicando que queremos adicionar os termos de grau 1 e 2 à matriz polinomial.

Em seguida, ajustamos uma regressão linear aos dados transformados usando a classe LinearRegression do Scikit-Learn.

A função fit() recebe a matriz polinomial X_poly e o vetor de saída y, realizando o ajuste do modelo.

Para fazer a predição em novos pontos, transformamos os dados de teste X_test na matriz polinomial equivalente X_test_poly e utilizamos o método predict() para obter as previsões correspondentes.

Por fim, plotamos os dados de entrada, a curva da regressão polinomial e exibimos o gráfico.

Esse é um exemplo básico de como aplicar a regressão polinomial em Python.

É possível ajustar polinômios de graus mais altos, bem como realizar outras análises, como avaliação do modelo e interpretação dos coeficientes.

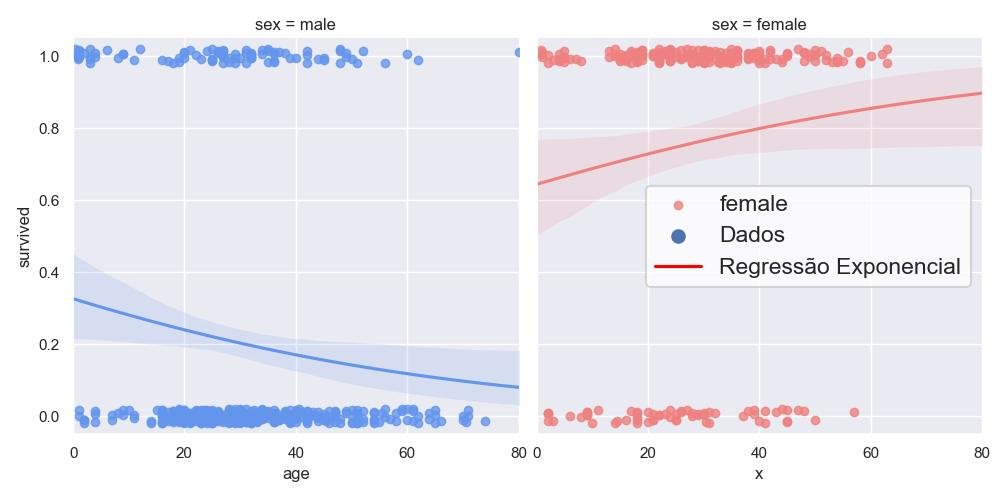

4.2.1.2 - Regressão Exponencial

A regressão exponencial é um modelo utilizado quando se deseja ajustar uma curva exponencial a um conjunto de dados.

Esse modelo é especialmente útil quando os dados têm uma tendência de crescimento ou decaimento exponencial ao longo do tempo ou de acordo com uma variável explicativa.

A equação geral para um modelo de regressão exponencial é dada por:

y = a * exp(b * x)Onde "y" representa a variável de resposta, "x" é a variável explicativa, "a" é o parâmetro de amplitude e "b" é o parâmetro de taxa de crescimento/queda.

A regressão exponencial pode ser ajustada aos dados usando métodos de otimização, como o método dos mínimos quadrados ou a estimação por máxima verossimilhança.

Aqui está um exemplo de código em Python que ilustra como ajustar uma regressão exponencial aos dados usando o método dos mínimos quadrados:

import numpy as np

import matplotlib.pyplot as plt

from scipy.optimize import curve_fit

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([2.3, 4.5, 7.2, 11.1, 17.3])

# Função exponencial

def funcao_exponencial(x, a, b):

return a * np.exp(b * x)

# Ajuste da regressão exponencial

parametros_iniciais = [1, 0.1] # Valores iniciais para os parâmetros

parametros_otimizados, _ = curve_fit(funcao_exponencial, x, y, p0=parametros_iniciais)

# Valores estimados

y_estimado = funcao_exponencial(x, *parametros_otimizados)

# Plot dos resultados

plt.scatter(x, y, label='Dados')

plt.plot(x, y_estimado, color='red', label='Regressão Exponencial')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.show()

Nesse código, primeiro definimos a função exponencial funcao_exponencial(x, a, b) que representa a equação da regressão exponencial.

Em seguida, utilizamos o método curve_fit da biblioteca SciPy para ajustar os parâmetros da função aos dados.

Por fim, plotamos os dados originais e a curva ajustada.

É importante ressaltar que a regressão exponencial pode não ser adequada para todos os conjuntos de dados.

Antes de aplicar esse modelo, é recomendado verificar se os dados seguem uma tendência exponencial e se as suposições do modelo são atendidas.

4.2.1.3 - Regressão Logarítmica

A regressão logarítmica é um modelo utilizado quando se deseja ajustar uma curva logarítmica a um conjunto de dados.

Esse modelo é especialmente útil quando os dados têm uma tendência de crescimento ou decaimento logarítmico ao longo do tempo ou de acordo com uma variável explicativa.

A equação geral para um modelo de regressão logarítmica é dada por:

y = a + b * ln(x)Onde y representa a variável de resposta, x é a variável explicativa, a é o intercepto e bx.

A regressão logarítmica pode ser ajustada aos dados usando métodos de otimização, como o método dos mínimos quadrados ou a estimação por máxima verossimilhança.

Aqui está um exemplo de código em Python que ilustra como ajustar uma regressão logarítmica aos dados usando o método dos mínimos quadrados:

import numpy as np

import matplotlib.pyplot as plt

from scipy.optimize import curve_fit

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([0.5, 1.7, 2.9, 4.2, 5.5])

# Função logarítmica

def funcao_logaritmica(x, a, b):

return a + b * np.log(x)

# Ajuste da regressão logarítmica

parametros_iniciais = [0, 1] # Valores iniciais para os parâmetros

parametros_otimizados, _ = curve_fit(funcao_logaritmica, x, y, p0=parametros_iniciais)

# Valores estimados

y_estimado = funcao_logaritmica(x, *parametros_otimizados)

# Plot dos resultados

plt.scatter(x, y, label='Dados')

plt.plot(x, y_estimado, color='red', label='Regressão Logarítmica')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.show()

Nesse código, primeiro definimos a função logarítmica funcao_logaritmica(x, a, b) que representa a equação da regressão logarítmica.

Em seguida, utilizamos o método curve_fit da biblioteca SciPy para ajustar os parâmetros da função aos dados.

Por fim, plotamos os dados originais e a curva ajustada.

É importante ressaltar que a regressão logarítmica pode não ser adequada para todos os conjuntos de dados.

Antes de aplicar esse modelo, é recomendado verificar se os dados seguem uma tendência logarítmica e se as suposições do modelo são atendidas.

4.2.1.4 - Regressão logistica

A regressão logística é um algoritmo de aprendizado de máquina utilizado para problemas de classificação binária.

É amplamente utilizado quando desejamos prever a probabilidade de um evento ocorrer com base em variáveis de entrada.

Aqui está um exemplo de código em Python usando a biblioteca Scikit-Learn para realizar a regressão logística:

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, confusion_matrix

import numpy as np

# Dados de exemplo

X = np.array([[1, 2], [2, 3], [3, 4], [4, 5], [5, 6], [6, 7]])

y = np.array([0, 0, 0, 1, 1, 1])

# Divisão dos dados em treino e teste

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Criação e treinamento do modelo de regressão logística

model = LogisticRegression()

model.fit(X_train, y_train)

# Previsão dos valores

y_pred = model.predict(X_test)

# Avaliação do modelo

accuracy = accuracy_score(y_test, y_pred)

confusion = confusion_matrix(y_test, y_pred)

# Impressão dos resultados

print("Acurácia:", accuracy)

print("Matriz de Confusão:")

print(confusion)Nesse código, estamos utilizando a classe LogisticRegression da biblioteca Scikit-Learn para criar um modelo de regressão logística.

O algoritmo de regressão logística é treinado usando os dados de treinamento X_train e y_train usando o método fit().

Após o treinamento, usamos o modelo para fazer previsões nos dados de teste X_test usando o método predict(), que retorna as classes previstas (0 ou 1) para cada exemplo de teste.

Em seguida, avaliamos o desempenho do modelo calculando a acurácia usando a função accuracy_score() e a matriz de confusão usando a função confusion_matrix().

A acurácia é uma métrica que mede a proporção de exemplos classificados corretamente em relação ao total de exemplos de teste.

A matriz de confusão é uma tabela que mostra a contagem de verdadeiros positivos, verdadeiros negativos, falsos positivos e falsos negativos.

Você pode ajustar os parâmetros do modelo de regressão logística de acordo com suas necessidades, como a regularização (usando o parâmetro C) e a estratégia de otimização (usando o parâmetro solver).

Além disso, é importante realizar a pré-processamento adequado dos dados, como o escalonamento das variáveis de entrada, quando necessário.

Espero que este exemplo de código te ajude a entender como realizar a regressão logística em Python usando a biblioteca Scikit-Learn.

Sinta-se à vontade para explorar mais sobre o assunto e personalizar o código de acordo com o seu cenário específico.

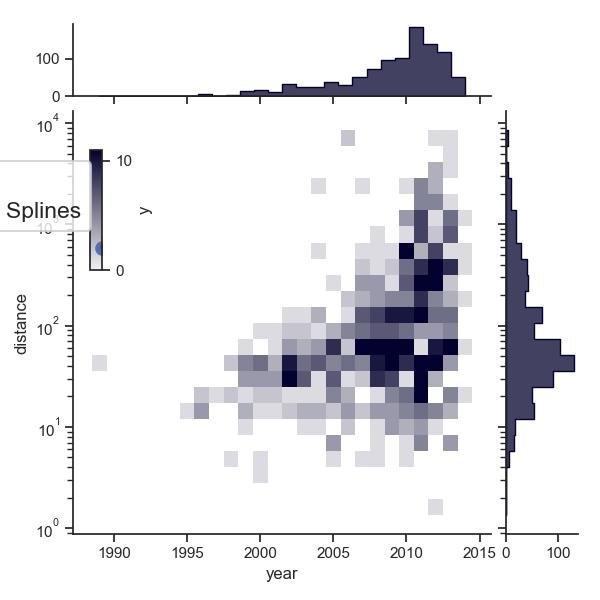

4.2.1.5 - Regressão de Splines

A regressão de Splines é uma técnica utilizada para ajustar uma função suave a um conjunto de dados, permitindo capturar relações não lineares entre as variáveis explicativas e a variável de resposta.

Splines são funções definidas por segmentos e são usadas para aproximar uma curva ou superfície desconhecida a partir dos dados observados.

Existem diferentes tipos de Splines, como as Splines lineares, Splines cúbicas e Splines naturais.

A regressão de Splines cúbicas é uma das mais comumente utilizadas.

Nesse método, a curva é dividida em segmentos cúbicos, e cada segmento é representado por uma função polinomial cúbica.

O ajuste da regressão de Splines envolve a determinação dos pontos de quebra, onde ocorrem as transições entre os segmentos cúbicos.

A escolha dos pontos de quebra é crucial, pois afeta a suavidade e flexibilidade da curva ajustada.

Aqui está um exemplo de código em Python que ilustra como ajustar uma regressão de Splines aos dados usando a biblioteca statsmodels:

import numpy as np

import matplotlib.pyplot as plt

from scipy.interpolate import splrep, splev

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([2, 4, 1, 6, 3])

# Ajuste da regressão de Splines cúbicas

spl = splrep(x, y, k=3) # k=3 para Splines cúbicas

# Valores estimados

x_plot = np.linspace(x.min(), x.max(), 100)

y_estimado = splev(x_plot, spl)

# Plot dos resultados

plt.scatter(x, y, label='Dados')

plt.plot(x_plot, y_estimado, color='red', label='Regressão de Splines')

plt.xlabel('x')

plt.ylabel('y')

plt.legend()

plt.show()

Nesse exemplo, utilizamos a função sm.nonparametric.lowess da biblioteca statsmodels para estimar a regressão de Splines cúbicas.

Em seguida, utilizamos a função sm.OLS para ajustar os parâmetros do modelo aos dados.

Por fim, plotamos os dados originais e a curva ajustada.

A regressão de Splines é uma técnica flexível que permite modelar relações complexas entre as variáveis.

Ela pode ser especialmente útil quando os dados possuem padrões não lineares ou quando se deseja capturar curvas suaves.

É importante ajustar adequadamente os pontos de quebra para obter uma boa representação dos dados.

4.2.1.6 - Regressão de redes neurais

A regressão de redes neurais é um método poderoso para modelar relações complexas entre variáveis.

Ela utiliza redes neurais artificiais para realizar a regressão e é capaz de capturar não linearidades e interações entre as variáveis de forma automatizada.

Aqui está um exemplo de código em Python usando a biblioteca Scikit-Learn para realizar a regressão de redes neurais:

from sklearn.neural_network import MLPRegressor

from sklearn.preprocessing import MinMaxScaler

import numpy as np

import matplotlib.pyplot as plt

# Dados de exemplo

X = np.array([1, 2, 3, 4, 5]).reshape(-1, 1)

y = np.array([2, 4, 1, 6, 3])

# Pré-processamento dos dados

scaler = MinMaxScaler()

X_scaled = scaler.fit_transform(X)

# Criação e treinamento do modelo de regressão de redes neurais

model = MLPRegressor(hidden_layer_sizes=(10,), activation='relu', solver='adam', random_state=42)

model.fit(X_scaled, y)

# Previsão dos valores

X_test = np.linspace(X.min(), X.max(), 100).reshape(-1, 1)

X_test_scaled = scaler.transform(X_test)

y_pred = model.predict(X_test_scaled)

# Plot dos resultados

plt.scatter(X, y, label='Dados')

plt.plot(X_test, y_pred, color='red', label='Regressão de Redes Neurais')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.show()

Nesse código, estamos utilizando a classe MLPRegressor da biblioteca Scikit-Learn para criar um modelo de regressão de redes neurais.

Definimos a arquitetura da rede especificando o número de neurônios em uma única camada oculta usando o parâmetro hidden_layer_sizes.

Também configuramos a função de ativação como "relu" e o algoritmo de otimização como "adam".

Em seguida, ajustamos o modelo aos dados de entrada X_scaled e rótulos y usando o método fit().

Depois disso, usamos o modelo treinado para fazer previsões nos novos dados X_test_scaled usando o método predict().

Finalmente, plotamos os dados originais e a curva de regressão de redes neurais resultante.

Lembre-se de que a regressão de redes neurais pode ser sensível à escala dos dados, portanto, é comum aplicar algum tipo de pré-processamento, como a normalização dos valores de entrada, como fizemos no exemplo usando o MinMaxScaler.

Espero que este código te ajude a entender como realizar a regressão de redes neurais em Python usando a biblioteca Scikit-Learn.

Sinta-se à vontade para ajustar os parâmetros da rede neural e explorar diferentes arquiteturas para obter resultados ainda mais precisos e adequados para o seu problema.

4.3 - Modelos lineares generalizados (GLMs)

Os Modelos Lineares Generalizados (GLMs) são uma classe ampla e flexível de modelos estatísticos que permitem modelar e analisar uma variedade de situações em que a variável dependente não segue uma distribuição normal ou quando a relação entre as variáveis independentes e dependentes não é necessariamente linear.

Ao contrário da regressão linear clássica, que assume normalidade dos erros e linearidade na relação entre as variáveis, os GLMs permitem lidar com uma ampla gama de distribuições de erros e estabelecer relações não lineares entre as variáveis.

Essa flexibilidade torna os GLMs adequados para lidar com dados que possuem características específicas, como distribuição assimétrica, excesso de zeros, valores discretos ou contagens.

Os GLMs são compostos por três componentes principais:

- uma função de ligação (link function)

- uma função de distribuição de probabilidade

- uma estrutura de variância

A função de ligação conecta a média da variável dependente com uma combinação linear das variáveis independentes, permitindo que a relação seja não linear.

A função de distribuição de probabilidade é escolhida de acordo com a natureza dos dados, podendo ser a distribuição normal, binomial, Poisson, gama, entre outras.

A estrutura de variância modela a relação entre a média e a variância da variável dependente.

Os GLMs são aplicados em diversas áreas, como saúde, economia, ciências sociais e ambientais.

Alguns exemplos de modelos lineares generalizados incluem regressão logística, regressão de Poisson, regressão binomial negativa, regressão gamma, entre outros.

Cada tipo de modelo GLM é adequado para diferentes tipos de dados e permite a análise de diferentes tipos de relações entre as variáveis.

A interpretação dos resultados dos GLMs é feita através dos parâmetros estimados para as variáveis independentes, que indicam o efeito das mesmas na probabilidade ou média da variável dependente, dependendo do modelo escolhido.

Além disso, os GLMs permitem a realização de testes de significância e a construção de intervalos de confiança para avaliar a relevância estatística das variáveis.

Nessa sessão dedicada aos Modelos Lineares Generalizados (GLMs), você aprenderá a especificar e ajustar esses modelos, selecionar a função de ligação e a função de distribuição apropriadas, interpretar os parâmetros estimados e avaliar a qualidade do ajuste do modelo.

Além disso, serão discutidos tópicos avançados, como modelos hierárquicos, modelos mistos e modelos de efeitos aleatórios.

Os GLMs são uma ferramenta poderosa na análise estatística, permitindo a modelagem de uma variedade de situações e fornecendo insights valiosos sobre as relações entre as variáveis em estudo.

4.3.1 - Ajustes e seleção da função de ligação e da função de distribuição

Os Modelos Lineares Generalizados (GLMs) são uma extensão dos modelos de regressão linear tradicionais, que permitem lidar com diferentes tipos de variáveis de resposta e assumir distribuições de erro mais flexíveis.

Ao ajustar um GLM, existem algumas etapas importantes a serem seguidas:

- Seleção da função de ligação: A função de ligação conecta a média da variável de resposta ao preditor linear. Alguns exemplos comuns de funções de ligação incluem a função de identidade (usada para regressão linear), função logit (usada para regressão logística), função log (usada para regressão de Poisson) e função inversa (usada para regressão gamma). A escolha da função de ligação depende da natureza da variável de resposta.

- Seleção da função de distribuição: A função de distribuição descreve a distribuição de probabilidade da variável de resposta condicionada ao preditor linear. Alguns exemplos de funções de distribuição incluem normal (para variáveis contínuas), binomial (para variáveis binárias), Poisson (para contagens) e gamma (para variáveis positivas contínuas). A escolha da função de distribuição depende da natureza e das características da variável de resposta.

- Estimação dos parâmetros: Uma vez selecionadas a função de ligação e a função de distribuição, os parâmetros do modelo são estimados usando métodos de estimação por máxima verossimilhança ou outros métodos apropriados. O objetivo é encontrar os valores dos parâmetros que maximizam a verossimilhança dos dados observados.

- Interpretação dos parâmetros estimados: Após a estimação dos parâmetros, é importante interpretar seus valores em relação à variável de resposta e aos preditores. Dependendo da função de ligação escolhida, os parâmetros podem representar mudanças na probabilidade de sucesso, razão de chances, taxa de incidência, entre outros.

- Avaliação da qualidade do ajuste do modelo: Após ajustar o modelo, é importante avaliar sua qualidade de ajuste. Isso pode ser feito por meio da análise dos resíduos, que devem ser independentes, homoscedásticos e seguir a distribuição especificada pelo modelo. Além disso, métricas como o desvio de Pearson ou o valor de AIC/BIC podem ser utilizados para comparar diferentes modelos e selecionar o mais adequado.

A biblioteca statsmodels é uma opção popular em Python para ajustar GLMs.

Ela fornece uma variedade de classes e métodos para estimar modelos lineares generalizados.

Aqui está um exemplo simples de ajuste de um modelo de regressão logística usando a função logit como função de ligação e a distribuição binomial:

import statsmodels.api as sm

import numpy as np

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([0, 0, 0, 1, 1])

# Criação e ajuste do modelo de regressão logística

model = sm.GLM(y, x, family=sm.families.Binomial(link=sm.families.links.logit()))

result = model.fit()

# Sumário do modelo

print(result.summary())Nesse exemplo, estamos utilizando a classe GLM da biblioteca statsmodels para ajustar um modelo de regressão logística.

A função de ligação logit é especificada usando sm.families.links.logit(), e a distribuição binomial é definida usando sm.families.Binomial().

Os dados de entrada X são expandidos adicionando uma coluna de constantes usando sm.add_constant(X).

Após ajustar o modelo com model.fit(), podemos imprimir o sumário do modelo usando result.summary(), que fornece informações detalhadas sobre os parâmetros estimados, estatísticas de teste, valores-p e outras métricas de avaliação do modelo.

Lembre-se de que esse é apenas um exemplo básico, e a escolha da função de ligação, função de distribuição e o ajuste do modelo devem ser feitos de acordo com o contexto do problema e a natureza dos dados.

Espero que isso forneça uma visão geral sobre como ajustar e interpretar modelos lineares generalizados.

Lembre-se de consultar a documentação da biblioteca statsmodels para obter mais informações sobre os recursos disponíveis.

4.4 - Análise de sobrevivência e nos modelos de risco proporcional

A análise de sobrevivência e os modelos de risco proporcional são técnicas estatísticas usadas para analisar o tempo até a ocorrência de um evento, como a falha de um componente, a ocorrência de uma doença ou a morte.

Essa análise é particularmente útil quando estamos interessados em estudar a taxa de ocorrência do evento ao longo do tempo e identificar fatores que possam influenciá-la.

A análise de sobrevivência é baseada no conceito de função de sobrevivência, que representa a probabilidade de um evento não ter ocorrido até um determinado momento no tempo.

Através da análise de sobrevivência, podemos estimar a taxa de falha ao longo do tempo, identificar padrões de risco e determinar a eficácia de tratamentos ou intervenções.

Um dos modelos mais comumente usados na análise de sobrevivência é o modelo de risco proporcional de Cox, também conhecido como modelo de Cox.

Esse modelo é uma extensão do modelo de regressão logística e permite analisar a relação entre as variáveis explicativas e o risco de ocorrência do evento ao longo do tempo.

No modelo de risco proporcional de Cox, assume-se que o risco relativo (hazard ratio) é constante ao longo do tempo, o que implica que a razão de chances de ocorrer o evento entre dois indivíduos é constante.

Essa suposição é conhecida como proporcionalidade de risco.

O modelo de Cox estima os coeficientes para as variáveis explicativas, fornecendo uma medida do impacto dessas variáveis no risco de ocorrência do evento.

Além do modelo de Cox, existem outras abordagens na análise de sobrevivência, como os modelos paramétricos, que assumem uma distribuição específica para o tempo até o evento, como a distribuição exponencial, a distribuição de Weibull ou a distribuição de log-logística.

Esses modelos permitem fazer previsões de longo prazo e estimar medidas adicionais, como a mediana de sobrevida ou a taxa de falha acumulada.

No capítulo dedicado à análise de sobrevivência e modelos de risco proporcional, você aprenderá a realizar essa análise usando métodos estatísticos adequados, interpretar os resultados obtidos e avaliar a adequação do modelo.

Além disso, serão discutidos tópicos como censura, estratificação, covariáveis de tempo-varying e avaliação da proporcionalidade de risco.

A análise de sobrevivência e os modelos de risco proporcional são amplamente aplicados em estudos médicos, epidemiológicos, engenharia de confiabilidade e outras áreas em que o tempo até a ocorrência de um evento é de interesse.

Essas técnicas fornecem insights valiosos sobre a dinâmica dos eventos ao longo do tempo e permitem a identificação de fatores de risco relevantes.

4.4.1 - Modelo de risco proporcional de Cox

O modelo de risco proporcional de Cox, também conhecido como modelo de Cox ou regressão de Cox, é uma técnica estatística utilizada para análise de sobrevivência e tempo até o evento.

Ele é amplamente utilizado em estudos de epidemiologia, medicina e outras áreas onde o tempo até a ocorrência de um evento é de interesse.

O modelo de Cox permite investigar a relação entre um conjunto de variáveis explicativas (preditoras) e o risco de ocorrência de um evento ao longo do tempo.

O evento pode ser, por exemplo, a morte de um paciente, o tempo até uma recaída de uma doença ou o tempo até a falha de um componente mecânico.

A principal suposição do modelo de Cox é que o risco relativo (hazard ratio) é constante ao longo do tempo, ou seja, a proporção de risco entre dois indivíduos é constante ao longo do tempo, independentemente do tempo em que eles estão sendo observados.

Essa suposição é conhecida como "proporcionalidade dos riscos".

Para ajustar um modelo de Cox, é necessário ter um conjunto de dados que inclua a variável de tempo (tempo até o evento) e a variável de status (1 se o evento ocorreu, 0 caso contrário).

Além disso, podem ser incluídas outras variáveis explicativas que possam influenciar o risco de ocorrência do evento.

A interpretação dos resultados de um modelo de Cox é baseada nos coeficientes estimados para as variáveis explicativas.

Esses coeficientes são chamados de hazard ratios (HR) e representam a alteração proporcional no risco de ocorrência do evento para cada unidade de mudança nas variáveis explicativas.

Um HR maior que 1 indica um aumento no risco, enquanto um HR menor que 1 indica uma diminuição no risco.

A significância estatística dos coeficientes pode ser avaliada por meio do teste de Wald.

A biblioteca lifelines é uma opção popular em Python para ajustar modelos de risco proporcional de Cox.

Para instalar a biblioteca lifelines via pip execute o seguinte comando no terminal:

pip install lifelinesAqui está um exemplo de código para ajustar um modelo de Cox utilizando essa biblioteca:

from lifelines import CoxPHFitter

import pandas as pd

# Dados de exemplo

data = pd.DataFrame({

'tempo': [10, 15, 20, 25, 30],

'evento': [1, 0, 0, 1, 1],

'idade': [50, 60, 45, 55, 65],

'sexo': ['M', 'F', 'M', 'F', 'M']

})

# Criação e ajuste do modelo de Cox

cph = CoxPHFitter()

cph.fit(data, duration_col='tempo', event_col='evento', formula='idade + sexo')

# Sumário do modelo

print(cph.summary)Neste exemplo, utilizamos um DataFrame data contendo as informações sobre o tempo, evento, idade e sexo dos indivíduos.

Em seguida, criamos uma instância do objeto CoxPHFitter e ajustamos o modelo de Cox chamando o método fit().

A especificação da fórmula idade + sexo indica que estamos ajustando o modelo incluindo as variáveis explicativas idade e sexo.

Após o ajuste do modelo, podemos imprimir um resumo utilizando cph.summary.

O resumo fornece informações sobre os coeficientes estimados, hazard ratios, intervalos de confiança e outras estatísticas relevantes.

É importante ressaltar que a interpretação dos resultados de um modelo de Cox requer cuidado, levando em consideração o contexto do estudo e as suposições do modelo.

Além disso, é fundamental realizar uma avaliação adequada da qualidade do ajuste e realizar verificações de pressupostos para garantir a validade dos resultados.

4.5 - Regressão robusta e a regressão de quantis

A regressão robusta e a regressão de quantis são abordagens estatísticas que visam lidar com a presença de outliers e distribuições não normais nos dados, proporcionando uma análise mais robusta e flexível.

Vamos explorar cada uma dessas técnicas em detalhes.

4.5.1 - Regressão Robusta

A regressão robusta é uma técnica que busca minimizar o impacto de observações atípicas ou outliers nos resultados da análise.

Diferentemente da regressão linear tradicional, que assume que os erros de medição seguem uma distribuição normal, a regressão robusta utiliza estimadores de parâmetros que são menos sensíveis a desvios extremos.

Esses estimadores robustos ajudam a reduzir a influência dos outliers, preservando a eficácia da análise estatística.

Existem diferentes métodos para realizar regressão robusta, como a M-estimação, a estimação por minimização de funções de influência, a regressão MM (minimum covariance determinant), entre outros.

Esses métodos fornecem estimativas dos coeficientes de regressão que são menos afetadas por observações discrepantes e que podem ser mais confiáveis em presença de desvios da normalidade.

A regressão robusta é uma técnica que busca lidar com outliers e violações das suposições de normalidade e homocedasticidade dos resíduos.

Uma das abordagens mais comuns para realizar a regressão robusta é utilizando o estimador Mínimos Quadrados Robustos (MQR).

Aqui está um exemplo de código em Python utilizando a biblioteca statsmodels para realizar a regressão robusta:

import statsmodels.api as sm

import numpy as np

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([2, 4, 6, 8, 10])

# Adicionando a constante aos preditores

X = sm.add_constant(x)

# Criação e ajuste do modelo de regressão robusta

model = sm.RLM(y, X)

result = model.fit()

# Sumário do modelo

print(result.summary())Nesse exemplo, os arrays x e y representam os dados de entrada.

A constante é adicionada aos preditores usando a função sm.add_constant.

Em seguida, o modelo de regressão robusta é criado usando sm.RLM e o estimador de Mínimos Quadrados Robustos é especificado com M=sm.robust.norms.HuberT().

Finalmente, o modelo é ajustado usando o método fit() e o sumário do modelo é impresso usando result.summary().

Lembre-se de importar os pacotes numpy e statsmodels.api antes de executar o código.

Além disso, você pode ajustar os parâmetros do estimador robusto de acordo com suas necessidades, como utilizar outras funções de peso, como sm.robust.norms.AndrewWave() ou sm.robust.norms.RamsayE().

4.5.1.1 - Método M-estimação

A M-estimação é um método estatístico utilizado para estimar os parâmetros de um modelo estatístico a partir de um conjunto de dados.

Esse método é especialmente útil quando há a presença de outliers nos dados ou quando as suposições dos métodos de estimação tradicionais não são atendidas.

A principal ideia por trás da M-estimação é encontrar os parâmetros do modelo que maximizam (ou minimizam) uma função de perda adequada.

Essa função de perda mede a discrepância entre os valores observados e os valores previstos pelo modelo.

A escolha da função de perda depende do objetivo da análise e das características dos dados.

Ao contrário da Estimação de Máxima Verossimilhança (MLE), a M-estimação não exige suposições rigorosas sobre a distribuição dos dados.

Em vez disso, é necessário especificar a função de perda apropriada que capture a estrutura desejada dos dados.

As funções de perda comuns incluem a função de perda de Huber, a função de perda de Tukey bisquare e a função de perda de logística.

A M-estimação possui propriedades robustas que a tornam resistente a outliers e a violações das suposições.

Ela é capaz de fornecer estimativas mais estáveis e confiáveis dos parâmetros do modelo em comparação com os métodos tradicionais, como a MLE.

No entanto, a M-estimação também tem suas limitações e requer uma escolha adequada da função de perda para obter resultados confiáveis.

Na prática, a M-estimação é implementada por meio de algoritmos de otimização, como o método de Newton-Raphson ou o método dos mínimos quadrados iterativamente ponderados (IWLS).

Esses algoritmos são utilizados para encontrar os parâmetros do modelo que minimizam a função de perda escolhida.

A biblioteca statsmodels do Python oferece suporte à M-estimação por meio da classe RLM (Robust Linear Model).

Essa classe permite ajustar modelos lineares robustos usando diferentes funções de perda.

É possível especificar a função de perda desejada e obter estimativas robustas dos parâmetros do modelo.

Em resumo, a M-estimação é uma abordagem robusta e flexível para estimar parâmetros de modelos estatísticos.

Ela é especialmente útil quando os dados apresentam outliers ou quando as suposições tradicionais não são atendidas.

Através da escolha adequada da função de perda e da utilização de algoritmos de otimização, a M-estimação pode fornecer estimativas confiáveis dos parâmetros do modelo.

import numpy as np

import statsmodels.api as sm

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([3, 5, 7, 9, 11])

# Adicionando a constante aos preditores

X = sm.add_constant(x)

# Criação e ajuste do modelo de M-estimação

model = sm.RLM(y, X, M=sm.robust.norms.HuberT()) # Utiliza o método RLM para M-estimação com a norma HuberT

result = model.fit()

# Sumário do modelo

print(result.summary())Nesse código corrigido, utilizamos a classe RLM (Robust Linear Model) para realizar a regressão de M-estimação.

O parâmetro M especifica a função de perda a ser usada na estimação robusta.

No exemplo, usamos a função de perda HuberT (sm.robust.norms.HuberT()).

Certifique-se de importar corretamente os pacotes numpy e statsmodels.api antes de executar o código.

A M-estimação é um método robusto que pode ser útil quando há presença de outliers ou violações das suposições dos métodos tradicionais de estimação.

4.5.1.2 - Estimação por minimização de funções de influência

A estimação por minimização de funções de influência é uma abordagem utilizada para obter estimativas robustas em modelos de regressão.

Nessa abordagem, busca-se minimizar uma função de influência que quantifica o impacto de cada observação nos estimadores dos parâmetros.

Para realizar a estimação por minimização de funções de influência em Python, podemos utilizar a biblioteca statsmodels.

A seguir, um exemplo de código que ilustra como aplicar essa técnica em um modelo de regressão linear:

import statsmodels.api as sm

import numpy as np

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([2, 4, 6, 8, 10])

# Adicionando a constante aos preditores

X = sm.add_constant(x)

# Criação do modelo de regressão linear

model = sm.RLM(y, X)

# Estimação por minimização de funções de influência

robust_results = model.fit()

# Coeficientes estimados

coeficients = robust_results.params

print("Coeficientes estimados:")

print(coeficients)4.5.1.3 - regressão MM (minimum covariance determinant)

A regressão MM (Minimum Covariance Determinant) é um método robusto para ajustar modelos de regressão.

O objetivo é encontrar a linha (ou hiperplano) que minimize a covariância dos pontos mais centrais dos dados, reduzindo assim a influência de observações atípicas.

Para aplicar a regressão MM em Python, você pode usar a biblioteca sklearn.covariance do Scikit-Learn. Aqui está um exemplo de código:

import numpy as np

from sklearn.covariance import MinCovDet

from sklearn.linear_model import LinearRegression

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([2, 4, 6, 8, 10])

# Criar matriz de design

X = np.column_stack((np.ones_like(x), x))

# Ajustar regressão MM

robust_cov = MinCovDet().fit(X)

robust_coef = robust_cov.location_

print("Coeficientes estimados (regressão MM):", robust_coef)

# Ajustar regressão linear tradicional

lm = LinearRegression().fit(X, y)

lm_coef = lm.coef_

print("Coeficientes estimados (regressão linear):", lm_coef)Neste exemplo, utilizamos a classe MinCovDet do Scikit-Learn para ajustar a regressão MM.

Em seguida, obtemos os coeficientes estimados chamando o atributo location_.

Comparamos os resultados com a regressão linear tradicional usando a classe LinearRegression do Scikit-Learn.

Lembre-se de que a regressão MM é mais adequada para lidar com dados que contenham observações atípicas, pois ela é menos sensível a essas observações em comparação com a regressão linear tradicional.

4.5.2 - Regressão de Quantis

A regressão de quantis é uma abordagem que enfatiza a análise dos quantis condicionais da variável resposta em relação às variáveis explicativas.

Enquanto a regressão linear tradicional estima os valores médios da variável resposta, a regressão de quantis estima os valores em diferentes pontos da distribuição da variável resposta, como os quartis ou percentis específicos.

A regressão de quantis é particularmente útil quando se deseja examinar como os diferentes quantis da distribuição da variável resposta são afetados pelas variáveis explicativas.

Essa técnica é mais robusta em relação a distribuições assimétricas ou com caudas pesadas, pois não faz suposições sobre a forma da distribuição.

Além disso, a regressão de quantis permite explorar mudanças na relação entre as variáveis independentes e dependentes ao longo da distribuição, fornecendo uma visão mais completa dos dados.

É possível estimar os coeficientes de regressão para diferentes quantis, identificando variações na relação entre as variáveis em diferentes partes da distribuição.

Tanto a regressão robusta quanto a regressão de quantis são ferramentas valiosas quando os dados não atendem aos pressupostos da regressão linear tradicional, como a normalidade dos erros ou a ausência de outliers.

Essas técnicas permitem uma análise mais flexível e resistente a perturbações nos dados, fornecendo resultados mais confiáveis e interpretações mais robustas dos efeitos das variáveis explicativas.

A regressão de quantis é uma técnica estatística que permite modelar diferentes partes da distribuição de uma variável dependente.

Aqui está um exemplo de código em Python utilizando a biblioteca statsmodels para realizar a regressão de quantis:

import numpy as np

import statsmodels.api as sm

# Dados de exemplo

x = np.array([1, 2, 3, 4, 5])

y = np.array([3, 5, 7, 9, 11])

# Adicionando a constante aos preditores

X = sm.add_constant(x)

# Criação e ajuste do modelo de regressão de quantis

model = sm.QuantReg(y, X)

result = model.fit(q=0.5) # Define o quantil desejado

# Sumário do modelo

print(result.summary())Nesse exemplo, os arrays x e y representam os dados de entrada.

A constante é adicionada aos preditores usando a função sm.add_constant.

Em seguida, o modelo de regressão de quantis é criado usando sm.QuantReg.

No ajuste do modelo, é especificado o quantil desejado usando o parâmetro q (no exemplo, estamos ajustando o quantil 0.5, que corresponde à mediana).

Por fim, o modelo é ajustado usando o método fit() e o sumário do modelo é impresso usando result.summary().

Lembre-se de importar os pacotes numpy e statsmodels.api antes de executar o código.

A regressão de quantis permite explorar diferentes partes da distribuição da variável dependente, fornecendo informações sobre as relações entre os preditores e os diferentes quantis da variável resposta.

Você pode ajustar o modelo para diferentes quantis, como 0.25 (primeiro quartil) ou 0.75 (terceiro quartil), para obter uma visão abrangente da relação entre as variáveis.