3 - Python para Aprendizado de Máquina

Adentrar o mundo do Python avançado é como abrir uma porta para um reino de possibilidades infinitas na busca por excelência em Aprendizado de Máquina (ML - Machine Learning).

Nesse emocionante território, o conhecimento básico é apenas a chave que abre a entrada, e o que você encontra lá dentro é uma sinfonia de poderosos conceitos, técnicas e ferramentas que elevam o ML a uma arte de vanguarda.

Aqui, não nos contentamos com fórmulas prontas. Avançar é questionar, desafiar e remodelar. É entender que, embora a regressão e a classificação sejam os primeiros acordes, os verdadeiros solos estão nos modelos profundos e complexos que moldam o futuro. Com bibliotecas como TensorFlow e PyTorch, nós esculpimos redes neurais e camadas profundas capazes de entender os dados mais intricados e fazer previsões precisas que eram inimagináveis há apenas alguns anos.

Mas não se engane: Python avançado é como um quebra-cabeças, e o ML é a peça mais brilhante e complexa desse quebra-cabeças. Aqui, não nos limitamos a um único tipo de algoritmo. Em vez disso, dançamos com árvores de decisão e florestas aleatórias, exploramos o mundo misterioso das máquinas de vetor de suporte e deciframos os segredos ocultos nas redes Bayesianas.

É claro, nessa jornada, a transformação dos dados é uma arte em si mesma. Usamos as mãos habilidosas da normalização e padronização para criar harmonia nos nossos conjuntos de dados. Com a elegância do PolynomialFeatures, polimos nossas características até que brilhem com insights ocultos, enquanto as técnicas de redução de dimensionalidade, como o PCA, transformam o excesso de informações em uma sinfonia de insights claros e concisos.

Quando exploramos as profundezas, a validação cruzada não é apenas um conceito, mas uma prática sagrada. Dividimos nossos dados, treinamos e testamos, garantindo que nosso modelo não apenas cante bem em um palco, mas que também mantenha a harmonia em todo o concerto.

E enquanto nos deleitamos com os resultados, a ética nos lembra de que a tecnologia avançada traz responsabilidade. Abraçamos a ética de ponta a ponta, questionando os vieses, considerando os impactos e nos esforçando para tornar nossa busca pelo conhecimento uma contribuição positiva para a sociedade.

Python avançado com ML é uma jornada, e o trajeto é iluminado pelo brilho da inovação. À medida que desvendamos o enigma das redes neurais convolucionais, sentimentos profundos de realização e curiosidade nos impulsionam adiante.

Portanto, avance sem medo, pois aqui, a vanguarda tecnológica é sua aliada. Seja a magia dos algoritmos de otimização ou a maravilha das redes generativas adversárias, o futuro se desdobra diante de nós em um ritmo acelerado. Então, pegue o código, abrace o conhecimento e desafie os limites do que é possível em Python avançado com ML.

O ML em Python é alimentada por um ecossistema robusto de bibliotecas e ferramentas que oferecem uma ampla gama de algoritmos, técnicas e recursos para treinar, avaliar e implantar modelos.

Vamos explorar os detalhes técnicos desse ecossistema:

- Bibliotecas Principais: O Python oferece várias bibliotecas líderes em ML, amplamente utilizadas por cientistas de dados e engenheiros de machine learning em todo o mundo, formando o núcleo do ecossistema de ML em Python, e oferecendo as ferramentas necessárias para você desenvolver, treinar e avaliar modelos de ML com eficácia e eficiência.

- Scikit-Learn: O Scikit-Learn é uma biblioteca amplamente usada para ML clássico. Ela oferece uma ampla variedade de algoritmos para tarefas como regressão, classificação, agrupamento e seleção de modelos. Além disso, fornece ferramentas para pré-processamento de dados e avaliação de modelos, tornando-a essencial para projetos de ML.

- TensorFlow: TensorFlow é uma biblioteca de ML de código aberto desenvolvida pelo Google. É especialmente poderosa para treinar redes neurais profundas e implementar modelos de aprendizado profundo. Sua flexibilidade e suporte à computação em GPUs o tornam uma escolha popular para projetos de aprendizado profundo.

- Keras: Keras é uma API de alto nível que roda em cima de bibliotecas de ML, como o TensorFlow. Ela simplifica a criação de redes neurais artificiais, permitindo que você desenvolva modelos complexos com menos código. Keras é conhecida por sua usabilidade e é ótima para iniciantes e desenvolvedores avançados.

- PyTorch: PyTorch é outra biblioteca de ML voltada para aprendizado profundo. É elogiada por sua flexibilidade e facilidade de depuração. PyTorch adota uma abordagem mais dinâmica para a construção de modelos, tornando-o uma escolha popular entre pesquisadores e desenvolvedores.

- XGBoost: XGBoost é uma biblioteca dedicada ao algoritmo de gradient boosting. Essa técnica avançada melhora a precisão do modelo ao combinar muitos modelos de aprendizado fracos. XGBoost é conhecido por sua eficácia em competições de ciência de dados e é amplamente usado para problemas de regressão e classificação.

- LightGBM: LightGBM é outra biblioteca focada em gradient boosting. Ele se destaca por sua eficiência e velocidade, sendo uma escolha sólida para conjuntos de dados grandes. LightGBM é especialmente útil quando você precisa de resultados rápidos e de alta qualidade.

- Pandas: Pandas é uma biblioteca fundamental para manipulação e análise de dados. É frequentemente usada para carregar, limpar, transformar e explorar dados antes de treinar modelos de ML. As estruturas de dados do Pandas, como o DataFrame, tornam a manipulação de dados mais eficiente e intuitiva.

- NumPy: O NumPy é uma biblioteca fundamental para computação científica em Python. Ele fornece suporte para arrays multidimensionais e funções matemáticas que são essenciais para manipulação de dados numéricos. O NumPy é amplamente utilizado para realizar operações eficientes em dados numéricos, o que é essencial em projetos de ML.

- Matplotlib: Matplotlib é uma biblioteca de visualização de dados em Python. Ela permite criar gráficos estáticos, gráficos de dispersão, histogramas e muitos outros tipos de visualizações. Essas visualizações são úteis para entender seus dados, avaliar modelos e comunicar resultados de forma eficaz.

- Pré-processamento de Dados: Antes de treinar modelos, os dados geralmente precisam ser limpos e transformados. Isso pode envolver preenchimento de valores ausentes, normalização, codificação de variáveis categóricas e muito mais. As bibliotecas como Scikit-Learn e Pandas oferecem ferramentas para essas tarefas.

- Escolha do Modelo: A escolha do modelo depende do problema que você está resolvendo. Para problemas de classificação, você pode optar por algoritmos como regressão logística, máquinas de vetor de suporte ou árvores de decisão. Para problemas de regressão, regressão linear e algoritmos de árvore são comuns. Além disso, algoritmos de aprendizado profundo (redes neurais) são ideais para problemas complexos de visão computacional, processamento de linguagem natural e muito mais.

- Treinamento e Avaliação: Para treinar um modelo, você divide seus dados em conjuntos de treinamento e teste. O modelo é treinado usando os dados de treinamento e, em seguida, avaliado nos dados de teste para medir sua performance. Métricas como precisão, recall, F1-score, erro médio quadrado, entre outras, são usadas para avaliar a eficácia do modelo.

- Ajuste de Hiperparâmetros: Cada algoritmo possui hiperparâmetros que precisam ser ajustados para obter o melhor desempenho. Isso pode ser feito por tentativa e erro, ou com técnicas como busca em grade ou busca aleatória.

- Validação Cruzada: A validação cruzada é usada para estimar o desempenho do modelo em dados não vistos. Ela envolve dividir os dados em várias partes (dobras) e treinar/avaliar o modelo em diferentes combinações de dobras.

- Regularização: Para evitar o sobreajuste (overfitting, quando o modelo se adapta demais aos dados de treinamento), a regularização é usada. Ela penaliza modelos mais complexos, incentivando a simplicidade.

- Visualização de Dados e Modelos: Bibliotecas como Matplotlib, Seaborn e TensorBoard permitem visualizar dados, métricas de desempenho e até mesmo a estrutura das redes neurais.

- Implantação de Modelos: Uma vez que você treinou um modelo, você pode implantá-lo para fazer previsões em novos dados. Isso pode ser feito usando bibliotecas como DJango, Flask, FastAPI, ou até mesmo plataformas de nuvem como AWS, Azure e Google Cloud.

- Aprendizado Contínuo: O ML é um campo em constante evolução. Manter-se atualizado com novas técnicas, algoritmos e melhores práticas é fundamental para obter o melhor desempenho dos seus modelos.

Lembre-se, o ML é tanto uma arte quanto uma ciência. Explorar e experimentar são partes essenciais do processo. Com o Python avançado como seu aliado, você tem as ferramentas para desvendar os padrões ocultos nos dados e transformá-los em conhecimento e insights valiosos.

3.1 - Scikit-Learn

O Scikit-Learn é uma das bibliotecas mais populares para aprendizado de máquina em Python, oferece uma ampla gama de algoritmos e ferramentas para realizar tarefas de aprendizado de máquina, desde pré-processamento de dados até avaliação de modelos.

Vamos detalhar algumas das principais funcionalidades do Scikit-Learn:

- Pré-processamento: O Scikit-Learn oferece funções para lidar com tarefas de pré-processamento, como lidar com valores ausentes (Imputer), normalização (StandardScaler), codificação de variáveis categóricas (OneHotEncoder), entre outras.

- Seleção de Modelos Supervisionado e Não Supervisionado: O Scikit-Learn suporta algoritmos de aprendizado supervisionado (classificação, regressão) e não supervisionado (agrupamento, redução de dimensionalidade).

- Algoritmos Diversificados: Ele oferece uma variedade de algoritmos, incluindo regressão linear, regressão logística, máquinas de vetor de suporte (SVM), árvores de decisão, k-means, PCA, entre outros.

- Treinamento e Avaliação de Modelos:

- Interface Uniforme: Todos os algoritmos de aprendizado de máquina no Scikit-Learn seguem uma interface uniforme. Você pode usar os métodos .fit() para treinar modelos e .predict() para fazer previsões.

- Métricas de Avaliação: A biblioteca oferece uma variedade de métricas de avaliação, como precisão, recall, F1-score, erro médio quadrado, coeficiente de determinação (R²) e muitos outros.

- Validação Cruzada: O Scikit-Learn oferece funções para realizar validação cruzada, como cross_val_score(), que ajuda a avaliar o desempenho do modelo em diferentes conjuntos de treinamento/teste.

- Seleção de Hiperparâmetros com Busca em Grade: O Scikit-Learn oferece ferramentas para realizar uma busca em grade, onde você pode especificar um conjunto de hiperparâmetros e ele tentará todas as combinações possíveis para encontrar a melhor configuração.

- Pipeline de Modelagem: O Scikit-Learn permite criar pipelines de modelagem, onde você pode encadear várias etapas, como pré-processamento, seleção de modelos e avaliação, tornando o processo mais eficiente e organizado.

- Manipulação de Dados: Você pode usar o Scikit-Learn para dividir seus dados em conjuntos de treinamento e teste, bem como para dividir conjuntos de dados em lotes menores para treinamento incremental.

- Visualização: Embora o foco principal do Scikit-Learn não seja a visualização, ele oferece algumas ferramentas básicas para visualizar os resultados dos modelos.

- Integração com Outras Bibliotecas: O Scikit-Learn é facilmente integrado com outras bibliotecas populares como NumPy e Pandas, permitindo uma manipulação eficaz de dados.

- Documentação Rica e Detalhada: A documentação oficial do Scikit-Learn é extensa, incluindo guias, tutoriais e exemplos detalhados.

- Comunidade Ativa: O projeto é de código aberto e tem uma comunidade ativa, o que significa que você pode encontrar suporte e recursos online facilmente.

O Scikit-Learn é uma ferramenta poderosa para explorar e experimentar com algoritmos de aprendizado de máquina. Sua interface consistente e ampla gama de funcionalidades tornam-no uma escolha popular para iniciantes e especialistas em aprendizado de máquina.

3.1.1 - Preparação de dados

Aqui está um exemplo de código utilizando o Scikit-Learn para treinar um modelo de regressão linear simples com preparação de dados:

# Importar bibliotecas

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# Criar dados simulados

np.random.seed(42)

dados_simulados = np.random.rand(100, 1) * 10 # Recurso (variável independente)

alvos_simulados = 2 * dados_simulados + 1 + np.random.randn(100, 1) # Rótulo (variável dependente com ruído)

# Dividir os dados em treinamento e teste

dados_treino, dados_teste, alvos_treino, alvos_teste = train_test_split(

dados_simulados, alvos_simulados, test_size=0.2, random_state=42)

# Pré-processamento dos dados: Padronização (escalonamento)

scaler = StandardScaler()

dados_treino_dimensionado = scaler.fit_transform(dados_treino)

dados_teste_dimensionado = scaler.transform(dados_teste)

# Treinar o modelo de regressão linear

reglin = LinearRegression()

reglin.fit(dados_treino_dimensionado, alvos_treino)

# Fazer previsões

alvos_previstos = reglin.predict(dados_teste_dimensionado)

# Calcular o erro médio quadrático

mse = mean_squared_error(alvos_teste, alvos_previstos)

print("Coeficiente:", reglin.coef_[0][0])

print("Interceptação:", reglin.intercept_[0])

print("Erro Médio Quadrático:", mse)Neste exemplo, estamos treinando um modelo de regressão linear para prever um rótulo (variável dependente) com base em uma única característica (variável independente). O código inclui os seguintes passos:

- Importamos as bibliotecas necessárias do Scikit-Learn.

- Criamos dados simulados usando numpy.

- Dividimos os dados em conjuntos de treinamento e teste usando train_test_split.

- Padronizamos os dados usando StandardScaler.

- Inicializamos um modelo de regressão linear usando LinearRegression.

- Treinamos o modelo usando os dados de treinamento padronizados.

- Fazemos previsões usando os dados de teste padronizados.

- Calculamos o erro médio quadrático usando mean_squared_error para avaliar o desempenho do modelo.

Este exemplo demonstra como preparar dados, treinar um modelo de regressão linear e avaliar suas previsões usando o Scikit-Learn.

3.1.2 - Seleção de modelos

Aqui está um exemplo de código utilizando o Scikit-Learn para selecionar um modelo de regressão linear:

# Importar bibliotecas

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# Criar dados simulados

np.random.seed(42)

dados_simulados = np.random.rand(100, 1) * 10 # Recurso (variável independente)

alvos_simulados = 2 * dados_simulados + 1 + np.random.randn(100, 1) # Rótulo (variável dependente com ruído)

# Dividir os dados em treinamento e teste

dados_treino, dados_teste, alvos_treino, alvos_teste = train_test_split(

dados_simulados, alvos_simulados, test_size=0.2, random_state=42)

# Pré-processamento dos dados: Padronização (escalonamento)

scaler = StandardScaler()

dados_treino_dimensionado = scaler.fit_transform(dados_treino)

dados_teste_dimensionado = scaler.transform(dados_teste)

# Treinar o modelo de regressão linear

reglin = LinearRegression()

reglin.fit(dados_treino_dimensionado, alvos_treino)

# Selecionar o melhor modelo

from sklearn.model_selection import cross_val_score

# Utilizar cross_val_score para avaliar o modelo

escores = cross_val_score(reglin, dados_treino_dimensionado, alvos_treino, scoring="neg_mean_squared_error", cv=10)

escores_rmse = np.sqrt(-escores)

# Exibir os resultados

print("Escores:", escores_rmse)

print("Média:", escores_rmse.mean())

print("Desvio Padrão:", escores_rmse.std())Aqui está um exemplo de código utilizando o Scikit-Learn para realizar seleção de modelos usando validação cruzada:

# Importar bibliotecas

import numpy as np

from sklearn.datasets import load_diabetes

from sklearn.model_selection import train_test_split, cross_val_score

from sklearn.linear_model import LinearRegression, Ridge, Lasso

from sklearn.ensemble import RandomForestRegressor

from sklearn.metrics import mean_squared_error

# Carregar o conjunto de dados de exemplo (Diabetes dataset)

data = load_diabetes()

dados_diabetes, alvos_diabetes = data.data, data.target

# Dividir os dados em treinamento e teste

dados_treino, dados_teste, alvos_treino, alvos_teste = train_test_split(

dados_diabetes, alvos_diabetes, test_size=0.2, random_state=42)

# Criar uma lista de modelos para avaliar

modelos = [

("Regressão Linear", LinearRegression()),

("Regressão Ridge", Ridge()),

("Regressão Lasso", Lasso()),

("Regressão Florestas Aleatórias", RandomForestRegressor())

]

# Avaliar os modelos usando validação cruzada

for nome_modelo, reglin in modelos:

escores = cross_val_score(reglin, dados_treino, alvos_treino, cv=5, scoring="neg_mean_squared_error")

escores_rmse = np.sqrt(-escores)

media_rmse = np.mean(escores_rmse)

print(f"Modelo: {nome_modelo}")

print(f"Média RMSE: {media_rmse}\n")

# Escolher o melhor modelo com base no menor RMSE

melhor_modelo = min(modelos, key=lambda x: np.mean(np.sqrt(-cross_val_score(x[1], dados_treino, alvos_treino, cv=5, scoring="neg_mean_squared_error"))))

print(f"Melhor Modelo: {melhor_modelo[0]}")Neste exemplo, estamos utilizando o conjunto de dados de exemplo "Diabets" do Scikit-Learn para ilustrar a seleção de modelos usando validação cruzada.

O código inclui os seguintes passos:

- Importamos as bibliotecas necessárias do Scikit-Learn e Numpy.

- Carregamos o conjunto de dados de exemplo "Diabets" do Scikit-Learn.

- Dividimos os dados em conjuntos de treinamento e teste.

- Criamos uma lista de modelos (regressão linear, regressão Ridge, regressão Lasso e Florestas Aleatórias).

- Avaliamos os modelos usando validação cruzada (CV) com 5 amostras de teste, calculando o RMSE (erro médio quadrático) negativo e obtendo a média dos RMSEs.

- Identificamos o melhor modelo com base no menor RMSE médio.

Este exemplo demonstra como usar o Scikit-Learn para realizar seleção de modelos com validação cruzada e escolher o melhor modelo com base na métrica de desempenho.

3.1.3 - Treinamento e avaliação de modelos

Aqui está um exemplo de código usando o Scikit-Learn para treinar e avaliar modelos de classificação com o conjunto de dados "Iris":

# Importar bibliotecas

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

from sklearn.tree import DecisionTreeClassifier

from sklearn.metrics import accuracy_score, classification_report

from sklearn.datasets import load_iris

# Carregar o conjunto de dados de exemplo (dataset "Iris")

data = load_iris()

dados_iris, alvos_iris = data.data, data.target

# Dividir os dados em treinamento e teste

dados_treino, dados_teste, alvos_treino, alvos_teste = train_test_split(

dados_iris, alvos_iris, test_size=0.2, random_state=42)

# Treinar um modelo de Regressão Logística

reglog = LogisticRegression(max_iter=1000)

reglog.fit(dados_treino, alvos_treino)

# Fazer previsões no conjunto de teste

previsoes = reglog.predict(dados_teste)

# Avaliar o desempenho do modelo de Regressão Logística

acuracia_reglog = accuracy_score(alvos_teste, previsoes)

relatorio_classificacao_reglog = classification_report(alvos_teste, previsoes)

print("*** Modelo de Regressão Logística")

print(f"Acurâcia: {acuracia_reglog}")

print("*** Relatório de classificação")

print(relatorio_classificacao_reglog)

print()

# Treinar um modelo de Árvore de Decisão

dtc = DecisionTreeClassifier()

dtc.fit(dados_treino, alvos_treino)

# Fazer previsões no conjunto de teste

previsoes_arvore = dtc.predict(dados_teste)

# Avaliar o desempenho do modelo de Árvore de Decisão

acuracia_arvore = accuracy_score(alvos_teste, previsoes_arvore)

relatorio_classificacao_arvore = classification_report(alvos_teste, previsoes_arvore)

print("Modelo de Árvore de Decisão:")

print(f"Acurâcia: {acuracia_arvore}")

print("Relatório de classificação:")

print(relatorio_classificacao_arvore)Neste exemplo, estamos usando o conjunto de dados "Iris dataset" do Scikit-Learn para ilustrar o treinamento e avaliação de modelos de classificação. O código inclui os seguintes passos:

- Importamos as bibliotecas necessárias do Scikit-Learn e numpy.

- Carregamos o conjunto de dados de exemplo "Iris dataset".

- Dividimos os dados em conjuntos de treinamento e teste.

- Treinamos um modelo de Regressão Logística e fazemos previsões no conjunto de teste.

- Avaliamos o desempenho do modelo usando a acurácia e o relatório de classificação.

- Treinamos um modelo de Árvore de Decisão e fazemos previsões no conjunto de teste.

- Avaliamos o desempenho do modelo usando a acurácia e o relatório de classificação.

Este exemplo ilustra como usar o Scikit-Learn para treinar e avaliar modelos de classificação em um conjunto de dados.

3.1.4 - Hiperparâmetros

Aqui está um exemplo de código usando o Scikit-Learn para realizar a seleção de hiperparâmetros usando Grid Search em um modelo de regressão de máquina de vetores de suporte (SVM):

# Importar bibliotecas

import numpy as np

from sklearn.model_selection import train_test_split, GridSearchCV

from sklearn.svm import SVC

from sklearn.datasets import load_iris

# Carregar o conjunto de dados de exemplo (Iris dataset)

data = load_iris()

dados_iris, alvos_iris = data.data, data.target

# Dividir os dados em treinamento e teste

dados_treino, dados_teste, alvos_treino, alvos_teste = train_test_split(

dados_iris, alvos_iris, test_size=0.2, random_state=42)

# Definir os hiperparâmetros a serem testados na grade de pesquisa

param_grid = {

'C': [0.1, 1, 10],

'kernel': ['linear', 'rbf', 'poly'],

'degree': [2, 3, 4]

}

# Criar o modelo SVM

modelo_svm = SVC()

# Criar o objeto da grade de pesquisa

grade_pesquisa = GridSearchCV(estimator=modelo_svm, param_grid=param_grid, cv=5)

# Realizar o grade de pesquisa no conjunto de treinamento

grade_pesquisa.fit(dados_treino, alvos_treino)

# Imprimir os melhores hiperparâmetros encontrados

print("Melhores Hiperparâmetros:", grade_pesquisa.best_params_)

# Avaliar o desempenho do modelo com os melhores hiperparâmetros no conjunto de teste

melhor_modelo = grade_pesquisa.best_estimator_

acuracia_teste = melhor_modelo.score(dados_teste, alvos_teste)

print("Acurâcia Teste:", acuracia_teste)Neste exemplo, estamos usando o conjunto de dados "Iris" do Scikit-Learn para ilustrar a seleção de hiperparâmetros usando grade de pesquisa em um modelo SVM. O código inclui os seguintes passos:

- Importamos as bibliotecas necessárias do Scikit-Learn e numpy.

- Carregamos o conjunto de dados de exemplo "Iris dataset".

- Dividimos os dados em conjuntos de treinamento e teste.

- Definimos uma grade de hiperparâmetros a serem testados no grade de pesquisa.

- Criamos um modelo SVM.

- Criamos um objeto da grade de pesquisa especificando o estimador, a grade de hiperparâmetros e o número de dobras para validação cruzada.

- Realizamos o Grid Search no conjunto de treinamento para encontrar os melhores hiperparâmetros.

- Imprimimos os melhores hiperparâmetros encontrados.

- Avaliamos o desempenho do modelo com os melhores hiperparâmetros no conjunto de teste.

Este exemplo demonstra como usar o Scikit-Learn para realizar a seleção de hiperparâmetros usando Grid Search em um modelo de aprendizado de máquina.

3.1.5 - Pipeline de Modelagem

Aqui está um exemplo de código usando o Scikit-Learn para criar um pipeline de modelagem que inclui pré-processamento de dados e treinamento de um modelo de regressão linear:

# Importar bibliotecas

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LinearRegression

from sklearn.pipeline import Pipeline

from sklearn.metrics import mean_squared_error

from sklearn.datasets import load_diabetes

# Carregar o conjunto de dados de exemplo (Diabetes dataset)

data = load_diabetes()

dados_diabetes, alvos_diabetes = data.data, data.target

# Dividir os dados em treinamento e teste

dados_treino, dados_teste, alvos_treino, alvos_teste = train_test_split(dados_diabetes, alvos_diabetes, test_size=0.2, random_state=42)

# Criar um pipeline de modelagem

pipeline_modelo = Pipeline([

('scaler', StandardScaler()), # Pré-processamento: Padronização dos dados

('regressor', LinearRegression()) # Modelo: Regressão Linear

])

# Treinar o modelo usando o pipeline

pipeline_modelo.fit(dados_treino, alvos_treino)

# Fazer previsões no conjunto de teste

alvos_previstos = pipeline_modelo.predict(dados_teste)

# Calcular o erro médio quadrático (MSE) das previsões

mse = mean_squared_error(alvos_teste, alvos_previstos)

print("Erro Médio Quadrático:", mse)Neste exemplo, estamos usando o conjunto de dados "Diabetes dataset" do Scikit-Learn para criar um pipeline de modelagem que inclui pré-processamento (padronização) dos dados usando StandardScaler e treinamento de um modelo de regressão linear. O código inclui os seguintes passos:

- Importamos as bibliotecas necessárias do Scikit-Learn e numpy.

- Carregamos o conjunto de dados de exemplo "Diabetes dataset".

- Dividimos os dados em conjuntos de treinamento e teste.

- Criamos um pipeline de modelagem que consiste em duas etapas: pré-processamento (padronização) usando StandardScaler e treinamento de um modelo de regressão linear.

- Treinamos o modelo usando o pipeline no conjunto de treinamento.

- Fazemos previsões no conjunto de teste usando o pipeline.

- Calculamos o erro médio quadrático (MSE) das previsões para avaliar o desempenho do modelo.

Este exemplo ilustra como criar um pipeline de modelagem no Scikit-Learn, permitindo que você encadeie etapas de pré-processamento e treinamento de modelos de maneira eficiente e organizada.

3.1.6 - Manipulação de Dados

Aqui está um exemplo de código usando o Scikit-Learn para realizar manipulação de dados, incluindo codificação de variáveis categóricas e imputação de valores faltantes:

# Importar bibliotecas

import numpy as np

import pandas as pd

from sklearn.preprocessing import OneHotEncoder, StandardScaler

from sklearn.impute import SimpleImputer

from sklearn.compose import ColumnTransformer

from sklearn.pipeline import Pipeline

# Criar um DataFrame de exemplo

data = {'idade': [25, 30, np.nan, 35, 28],

'gênero': ['M', 'F', 'F', 'M', 'M'],

'salário': [50000, 60000, 45000, np.nan, 55000]}

df = pd.DataFrame(data)

# Definir colunas numéricas e categóricas

caracteristicas_numericas = ['idade', 'salário']

caracteristicas_categoricas = ['gênero']

# Criar transformadores para pré-processamento

numeric_transformer = Pipeline(steps=[

('imputer', SimpleImputer(strategy='mean')),

('scaler', StandardScaler())

])

categorical_transformer = Pipeline(steps=[

('imputer', SimpleImputer(strategy='most_frequent')),

('encoder', OneHotEncoder())

])

# Combinar os transformadores usando ColumnTransformer

preprocessor = ColumnTransformer(

transformers=[

('num', numeric_transformer, caracteristicas_numericas),

('cat', categorical_transformer, caracteristicas_categoricas)

])

# Aplicar o pré-processamento aos dados

X = preprocessor.fit_transform(df)

# Exibir os dados pré-processados

print(X)Neste exemplo, estamos usando um DataFrame de exemplo para ilustrar a manipulação de dados com o scikit-learn. O código inclui os seguintes passos:

- Importamos as bibliotecas necessárias, incluindo o numpy, pandas e as classes do scikit-learn para pré-processamento de dados.

- Criamos um DataFrame de exemplo com colunas "idade", "gênero" e "salário".

- Definimos quais colunas são numéricas e categóricas.

- Criamos transformadores separados para pré-processamento numérico e categórico. Usamos o SimpleImputer para imputar valores faltantes e o StandardScaler para padronizar os valores numéricos. Para variáveis categóricas, usamos o SimpleImputer com estratégia 'most_frequent' e o OneHotEncoder para codificar as categorias.

- Usamos o ColumnTransformer para combinar os transformadores em um único pré-processador.

- Aplicamos o pré-processamento aos dados usando o método fit_transform.

- Exibimos os dados pré-processados.

Este exemplo ilustra como criar um pipeline de transformaçã de modelagem no Scikit-Learn, permitindo que você encadeie etapas de pré-processamento e treinamento de modelos de maneira eficiente e organizada, demonstrando como usar o scikit-learn para pré-processar dados, incluindo imputação de valores faltantes e codificação de variáveis categóricas, utilizando o pipeline.

3.1.7 - Visualização

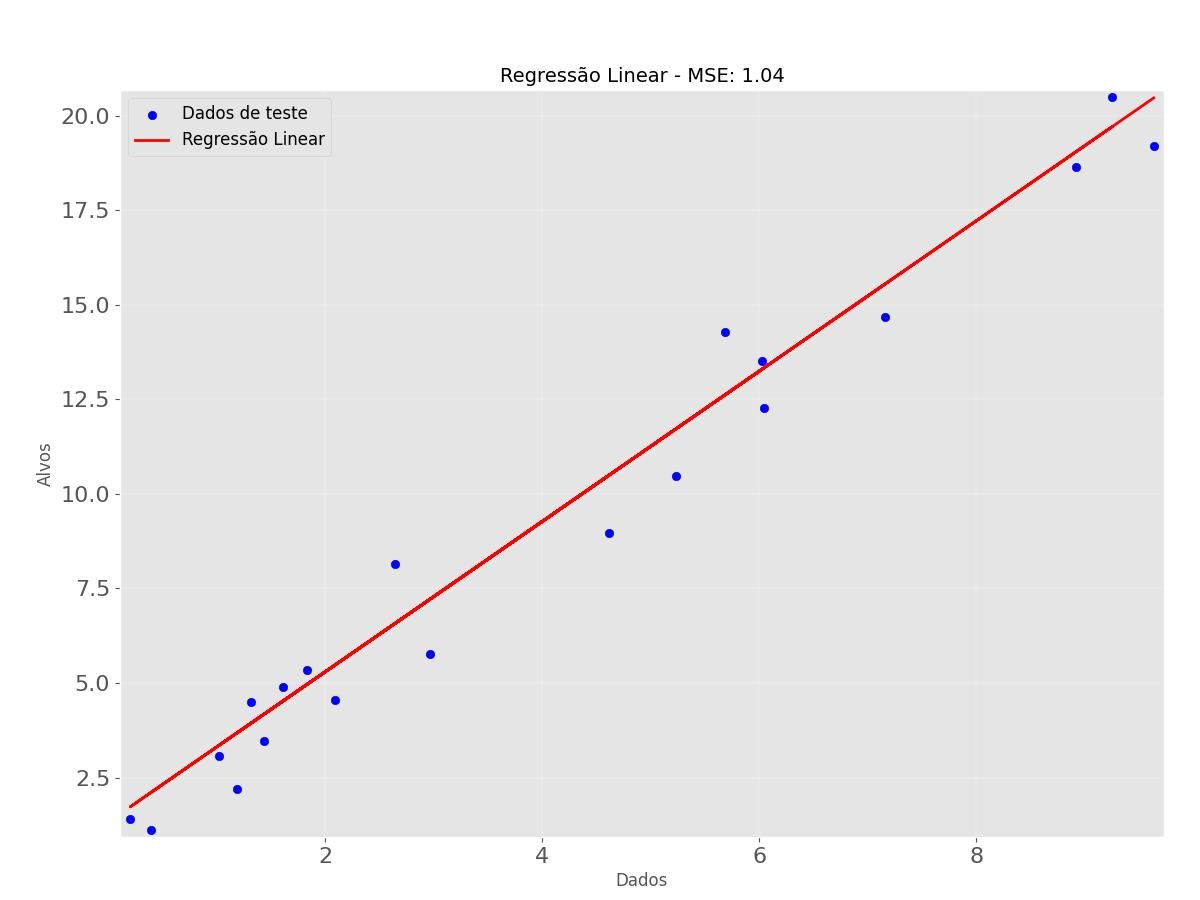

Aqui está um exemplo de código usando o Scikit-Learn para treinar um modelo de regressão linear e, em seguida, visualizar os resultados:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# Gerar dados de exemplo

np.random.seed(0)

dados_aleatorios = np.random.rand(100, 1) * 10

alvos_aleatorios = 2 * dados_aleatorios + 1 + np.random.randn(100, 1)

# Dividir os dados em conjunto de treinamento e teste

dados_treino, dados_teste, alvos_treino, alvos_teste = train_test_split(

dados_aleatorios, alvos_aleatorios, test_size=0.2, random_state=0)

# Treinar o modelo de regressão linear

reglin = LinearRegression()

reglin.fit(dados_treino, alvos_treino)

# Fazer previsões no conjunto de teste

alvos_previstos = reglin.predict(dados_teste)

# Calcular o erro médio quadrado

mse = mean_squared_error(alvos_teste, alvos_previstos)

# Ajustar tamanhos de fonte

plt.rc('font', size=12) # Tamanho da fonte das etiquetas dos eixos e título

plt.rc('axes', titlesize=14) # Tamanho da fonte do título do gráfico

# Visualizar os resultados

plt.scatter(dados_teste, alvos_teste, color='blue', label='Dados de teste')

plt.plot(dados_teste, alvos_previstos, color='red', linewidth=2, label='Regressão Linear')

plt.xlabel('Dados', fontsize=12)

plt.ylabel('Alvos', fontsize=12)

plt.title(f'Regressão Linear - MSE: {mse:.2f}')

plt.legend()

plt.show()

Neste exemplo, estamos gerando dados de exemplo, dividindo-os em conjuntos de treinamento e teste, treinando um modelo de regressão linear, fazendo previsões e, finalmente, visualizando os resultados usando a biblioteca matplotlib.

O código inclui os seguintes passos:

- Importamos as bibliotecas necessárias, incluindo numpy, matplotlib, train_test_split, LinearRegression e mean_squared_error do Scikit-Learn.

- Geramos dados de exemplo usando numpy, incluindo uma relação linear com ruído.

- Dividimos os dados em conjunto de treinamento e teste usando train_test_split.

- Treinamos um modelo de regressão linear usando LinearRegression.

- Fazemos previsões no conjunto de teste.

- Calculamos o erro médio quadrado (MSE) entre as previsões e os valores reais.

- Visualizamos os dados de teste e a linha de regressão linear usando matplotlib.

Este exemplo demonstra como usar o Scikit-Learn para treinar um modelo de regressão linear e visualizar os resultados para avaliar o desempenho do modelo.

3.2 - Keras

O Keras é uma API de alto nível para construção e treinamento de redes neurais em diversas bibliotecas de aprendizado de máquina, incluindo o TensorFlow. Ele foi projetado para ser simples e intuitivo, permitindo que os desenvolvedores criem e experimentem rapidamente modelos de aprendizado profundo. Aqui estão os principais detalhes sobre o Keras:

- Simplicidade e Usabilidade: O Keras foi projetado com foco na simplicidade e usabilidade. Ele oferece uma interface de programação intuitiva, que permite aos desenvolvedores criar modelos complexos de redes neurais com poucas linhas de código. As operações comuns, como a criação de camadas, compilação de modelos e treinamento, são realizadas de maneira direta e eficiente.

- Modularidade: O Keras é baseado em uma abordagem modular. Ele permite que você crie modelos de rede neural empilhando camadas. Cada camada é um bloco de construção individual, e você pode combinar diferentes camadas para criar arquiteturas personalizadas.

- Suporte a Múltiplas Backends: Uma característica marcante do Keras é a sua compatibilidade com vários backends, incluindo TensorFlow, Theano e Microsoft Cognitive Toolkit (CNTK). No entanto, a partir da versão 2.4, o TensorFlow é o backend padrão e recomendado.

- Flexibilidade: O Keras permite que você crie uma variedade de tipos de modelos, desde redes neurais simples até arquiteturas mais complexas, como redes convolucionais, redes recorrentes e redes geradoras adversariais (GANs).

- Treinamento e Avaliação Simplificados: O Keras oferece métodos convenientes para compilar e treinar modelos, incluindo a escolha de otimizadores, funções de perda e métricas de avaliação. Ele também inclui ferramentas de avaliação que facilitam a avaliação do desempenho do modelo em conjuntos de dados de teste.

- Integração com TensorFlow: Embora o Keras seja uma biblioteca independente, ele foi incorporado diretamente ao TensorFlow a partir da versão 2.0. Isso significa que você pode usar a API Keras nativamente com as funcionalidades e otimizações do TensorFlow.

- TensorBoard e Integração com Ferramentas do TensorFlow: Ao usar o Keras com o TensorFlow, você pode aproveitar as vantagens de ferramentas do TensorFlow, como o TensorBoard, para visualizar gráficos de treinamento e métricas de desempenho.

- Comunidade Ativa e Recursos: O Keras tem uma comunidade ativa e crescente, com uma vasta quantidade de tutoriais, exemplos e projetos de código aberto.

Ele também possui uma documentação detalhada que abrange desde conceitos básicos até tópicos avançados.

O Keras é uma escolha popular para desenvolvedores que desejam criar e treinar modelos de aprendizado profundo de maneira rápida e eficiente.

Sua abordagem amigável, modular e flexível permite que tanto iniciantes quanto especialistas em aprendizado de máquina experimentem e criem modelos complexos, tornando-o uma ferramenta valiosa para a construção de soluções baseadas em redes neurais.

O Keras torna a construção e treinamento de redes neurais mais simples e acessível, permitindo que você crie modelos poderosos com apenas algumas linhas de código.

3.2.1 - Simplicidade e Usabilidade

O Keras é conhecido por sua simplicidade e usabilidade, especialmente ao construir redes neurais.

Aqui está um exemplo básico de como criar uma rede neural simples de classificação de imagens usando o Keras:

import numpy as np

from keras.models import Sequential

from keras.layers import Dense

from keras.optimizers import SGD

# Dados de exemplo: 4 amostras com 2 características cada

X = np.array([[0, 0], [0, 1], [1, 0], [1, 1]])

y = np.array([0, 1, 1, 0])

# Criação do modelo

modelo = Sequential()

modelo.add(Dense(units=2, activation='sigmoid', input_dim=2))

modelo.add(Dense(units=1, activation='sigmoid'))

# Compilação do modelo

optimizer = SGD(learning_rate=0.1)

modelo.compile(loss='binary_crossentropy', optimizer=optimizer, metrics=['accuracy'])

# Treinamento do modelo

modelo.fit(X, y, epochs=1000, verbose=0)

# Avaliação do modelo

loss, acuracia = modelo.evaluate(X, y)

# Predições

previsoes = modelo.predict(X)

Imprimimos a perda, a acurâcia e as previsões.

print(f"Perda: {loss:.4f}, Accuracy: {acuracia:.4f}")

print(f"previsões:\n {previsoes}")Neste exemplo, estamos criando uma rede neural com duas camadas densas (totalmente conectadas) usando o Keras. O modelo é compilado com uma função de perda de entropia cruzada binária e otimizado usando o otimizador SGD (gradiente descendente estocástico). Depois de treinado, o modelo é avaliado e usado para fazer previsões.

3.2.2 - Modularidade do Keras

O Keras é conhecido por sua modularidade, o que facilita a criação de modelos complexos combinando diferentes tipos de camadas. Aqui está um exemplo que demonstra a modularidade do Keras ao criar uma rede neural com várias camadas de diferentes tipos:

import numpy as np

from keras.models import Sequential

from keras.layers import Input, Dense, Dropout, Activation

from keras.optimizers import Adam

# Dados de exemplo: 4 amostras com 3 características cada

X = np.array([[0, 0, 0], [0, 1, 1], [1, 0, 1], [1, 1, 0]])

y = np.array([0, 1, 1, 0])

# Criação do modelo

modelo = Sequential()

# Adicionando camada de entrada

modelo.add(Input(shape=(3,)))

# Adicionando camadas densas com ativações diferentes

modelo.add(Dense(units=4))

modelo.add(Activation('relu'))

modelo.add(Dense(units=2))

modelo.add(Activation('tanh'))

# Adicionando camada de dropout para regularização

modelo.add(Dropout(0.2))

# Camada de saída com ativação sigmoid para classificação binária

modelo.add(Dense(units=1))

modelo.add(Activation('sigmoid'))

# Compilação do modelo

optimizer = Adam(learning_rate=0.01)

modelo.compile(loss='binary_crossentropy', optimizer=optimizer, metrics=['accuracy'])

# Treinamento do modelo

modelo.fit(X, y, epochs=1000, verbose=0)

# Avaliação do modelo

perda, acuracia = modelo.evaluate(X, y)

# Predições

previsoes = modelo.predict(X)Imprimimos a perda, a acurâcia e as previsões.

print(f"Perda: {perda:.4f}, Accuracy: {acuracia:.4f}")

print(f"Previsões: \n {previsoes}")Neste exemplo, estamos criando um modelo mais complexo usando várias camadas diferentes, como Dense (totalmente conectada), Activation (ativação) e Dropout (regularização). Isso ilustra como o Keras permite a criação de modelos modulares, onde você pode facilmente combinar diferentes tipos de camadas para construir uma rede neural personalizada. Isso é especialmente útil para criar arquiteturas de modelos mais avançados e sofisticados.

3.2.3 - Múltiplas Backends do Keras

O Keras tem suporte a múltiplos backends, como TensorFlow, Theano e CNTK.

O TensorFlow é o backend padrão e o Keras lida automaticamente com esses detalhes de implementação.

Aqui está um exemplo de código que mostra com backend usando o TensorFlow:

import numpy as np

from keras.models import Sequential

from keras.layers import Dense

# Crie seu modelo aqui usando as camadas do Keras

modelo = Sequential()

modelo.add(Dense(units=64, activation='relu', input_dim=100))

modelo.add(Dense(units=1, activation='sigmoid'))

# Compile o modelo e treine-o

modelo.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# Dados de exemplo

X = np.random.rand(100, 100)

y = np.random.randint(2, size=(100,))

modelo.fit(X, y, epochs=10, batch_size=32)

# Avalie o modelo

perda, acuracia = modelo.evaluate(X, y)Imprimimos a perda e a acurâcia.

print(f"Perda: {perda:.4f}")

print(f"Acurâcia: {acuracia:.4f}")Entretanto, o Theano não é mais mantido ou suportado ativamente, e muitas das bibliotecas populares de aprendizado de máquina, incluindo o Keras, estão migrando para outros backends como o TensorFlow. Portanto, não é recomendado usar o Theano como backend para o Keras.

O Microsoft Cognitive Toolkit (CNTK) foi outro backend suportado pelo Keras no passado, mas o suporte ao CNTK foi descontinuado nas versões mais recentes do Keras. Portanto, também não é recomendado usar o CNTK como backend para o Keras.

Se você deseja usar o Keras com um backend atualmente suportado, o TensorFlow é a opção recomendada. Para usar o TensorFlow como backend, você não precisa de nenhuma configuração especial, já que o TensorFlow é o backend padrão no Keras.

3.2.4 - Flexibilidade

Aqui está um exemplo com cinco modelos diferentes, cada um representando um tipo de arquitetura de rede no Keras.

Primeiro, importamos as bibliotecas necessárias:

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import Reshape

from keras.layers import Flatten

from keras.layers import Conv2D

from keras.layers import Conv2DTranspose

from keras.layers import LeakyReLU

from keras.layers import Dropout

from keras.layers import Embedding

from keras.layers import LSTM

from keras.layers import MaxPooling2D

Modelo 1: Rede Neural Simples

model_simples = Sequential()

model_simples.add(Dense(units=128, activation='relu', input_dim=784))

model_simples.add(Dense(units=64, activation='relu'))

model_simples.add(Dense(units=10, activation='softmax'))

model_simples.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

print(model_simples.summary())Modelo 2: Rede Convolucional

modelo_conv = Sequential()

modelo_conv.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1)))

modelo_conv.add(MaxPooling2D(pool_size=(2, 2)))

modelo_conv.add(Flatten())

modelo_conv.add(Dense(128, activation='relu'))

modelo_conv.add(Dense(10, activation='softmax'))

modelo_conv.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

print(modelo_conv.summary())Modelo 3: Rede Recorrente (LSTM)

modelo_lsmt = Sequential()

modelo_lsmt.add(Embedding(input_dim=10000, output_dim=128))

modelo_lsmt.add(LSTM(units=64))

modelo_lsmt.add(Dense(units=10, activation='softmax'))

modelo_lsmt.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

print(modelo_lsmt.summary())Modelo 4: Rede com Camadas Combinadas

modelo_combinado = Sequential()

modelo_combinado.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1)))

modelo_combinado.add(MaxPooling2D(pool_size=(2, 2)))

modelo_combinado.add(Flatten())

modelo_combinado.add(Dense(128, activation='relu'))

#modelo_combinado.add(LSTM(units=64))

modelo_combinado.add(Dense(10, activation='softmax'))

modelo_combinado.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

print(modelo_combinado.summary())Modelo 5: Rede Generativa Adversarial (GAN - Generative Adversarial Network)

def definir_gan(g_model, d_model):

d_model.trainable = False

modelo = Sequential()

modelo.add(g_model)

modelo.add(d_model)

modelo.compile(loss='binary_crossentropy', optimizer='adam')

return modelo

def definir_discriminador(in_shape=(28,28,1)):

modelo = Sequential()

modelo.add(Conv2D(64, (3,3), strides=(2, 2), padding='same', input_shape=in_shape))

modelo.add(LeakyReLU(alpha=0.2))

modelo.add(Dropout(0.4))

modelo.add(Conv2D(64, (3,3), strides=(2, 2), padding='same'))

modelo.add(LeakyReLU(alpha=0.2))

modelo.add(Dropout(0.4))

modelo.add(Flatten())

modelo.add(Dense(1, activation='sigmoid'))

modelo.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

return modelo

def definir_gerador(latent_dim):

modelo = Sequential()

n_nodes = 128 * 7 * 7

modelo.add(Dense(n_nodes, input_dim=latent_dim))

modelo.add(LeakyReLU(alpha=0.2))

modelo.add(Reshape((7, 7, 128)))

modelo.add(Conv2DTranspose(128, (4,4), strides=(2,2), padding='same'))

modelo.add(LeakyReLU(alpha=0.2))

modelo.add(Conv2DTranspose(128, (4,4), strides=(2,2), padding='same'))

modelo.add(LeakyReLU(alpha=0.2))

modelo.add(Conv2D(1, (7,7), activation='sigmoid', padding='same'))

modelo.compile(loss='binary_crossentropy', optimizer='adam')

return modelo

latent_dim = 100

discriminator = definir_discriminador()

generator = definir_gerador(latent_dim)

modelo_gan = definir_gan(generator, discriminator)

print(modelo_gan.summary())Neste exemplo, temos cinco modelos diferentes: uma rede neural simples, uma rede convolucional, uma rede recorrente (LSTM), uma rede com camadas combinadas e uma rede generativa adversarial (GAN).

Cada modelo demonstra a flexibilidade do Keras em criar arquiteturas diversificadas para diferentes tipos de tarefas de aprendizado de máquina.

3.3 - TensorFlow

O TensorFlow é uma das bibliotecas mais populares e abrangentes para aprendizado de máquina e aprendizado profundo (deep learning). Desenvolvido pela equipe do Google Brain, o TensorFlow oferece uma estrutura flexível e escalável para construir e treinar modelos de aprendizado de máquina. Aqui estão os principais detalhes sobre o TensorFlow:

- Estrutura de Grafo Computacional: Uma das características distintivas do TensorFlow é sua estrutura de grafo computacional. Os modelos são representados como grafos direcionados, onde os nós representam operações matemáticas e as arestas representam os dados que fluem entre essas operações. Isso permite otimizações automáticas, como o agrupamento de operações similares e a execução em hardware otimizado, como GPUs e TPUs (Tensor Processing Units).

- Aprendizado Profundo (Deep Learning): O TensorFlow é amplamente utilizado para construir redes neurais profundas. Ele fornece uma variedade de camadas e funções de ativação, permitindo a criação de arquiteturas complexas de redes neurais. A API de alto nível do TensorFlow, chamada de Keras, é incorporada diretamente no TensorFlow, facilitando a criação e o treinamento de modelos de aprendizado profundo.

- Flexibilidade: O TensorFlow é altamente flexível, permitindo que você personalize e controle todos os aspectos do processo de treinamento. Você pode definir suas próprias funções de perda, métricas personalizadas, otimizadores e até mesmo criar suas próprias camadas personalizadas.

- Gráficos Estáticos e Dinâmicos: O TensorFlow 1.x usava um sistema de gráfico computacional estático, onde você primeiro definia o grafo e depois o executava. No TensorFlow 2.x, a ênfase mudou para a execução de gráficos de forma mais dinâmica, tornando o fluxo de trabalho mais intuitivo e similar ao código Python padrão.

- Distribuição e Paralelismo: O TensorFlow permite distribuir treinamento e inferência em vários dispositivos, como GPUs e TPUs, para acelerar o processo. Também suporta treinamento distribuído em várias máquinas, permitindo treinar modelos em conjuntos de dados massivos.

- Ferramentas de Visualização: O TensorFlow oferece ferramentas como o TensorBoard, que permite visualizar gráficos computacionais, métricas de treinamento e outras informações para entender melhor o desempenho do modelo.

- Compatibilidade Móvel e Embarcada: Além de ser usado para treinamento em servidores, o TensorFlow pode ser integrado a aplicativos móveis e embarcados, permitindo implantações em dispositivos móveis, IoT e sistemas embarcados.

- Comunidade Ativa e Recursos Abundantes: O TensorFlow tem uma comunidade ativa que contribui com tutoriais, exemplos, projetos de código aberto e suporte. Ele possui uma documentação detalhada e uma vasta quantidade de recursos online para ajudar os usuários em todos os níveis de experiência.

O TensorFlow é uma escolha popular para projetos de aprendizado de máquina e aprendizado profundo, especialmente quando se deseja flexibilidade, personalização e capacidade de dimensionamento para tarefas complexas. Sua combinação de alto desempenho, flexibilidade e ampla comunidade de usuários o torna uma ferramenta poderosa para criar, treinar e implantar modelos de aprendizado de máquina em diversas aplicações.

3.4 - PyTorch

O PyTorch é uma biblioteca de aprendizado de máquina de código aberto que se tornou uma das principais escolhas para a pesquisa e implementação de modelos de aprendizado profundo. Ele se destaca por sua flexibilidade, dinamicidade e comunidade ativa. Vamos detalhar os principais aspectos do PyTorch:

- Estrutura Computacional Dinâmica: Uma das características distintivas do PyTorch é seu sistema de gráficos computacionais dinâmicos. Isso significa que as operações são executadas imediatamente à medida que são chamadas, em oposição ao TensorFlow, que adota uma abordagem de gráfico computacional estático. Isso torna o PyTorch mais intuitivo e facilita a depuração.

- Autograd (Diferenciação Automática): O PyTorch oferece uma biblioteca chamada "autograd" que realiza automaticamente a diferenciação de tensores. Isso é crucial para o treinamento de redes neurais, pois permite calcular gradientes para atualizações de parâmetros durante o processo de treinamento.

- Modelagem Dinâmica de Gráficos Computacionais: A abordagem dinâmica do PyTorch permite criar modelos de maneira mais intuitiva e flexível. Isso é especialmente útil para modelos com estruturas irregulares, como redes recorrentes.

- Construção de Modelos: O PyTorch permite construir modelos de aprendizado profundo usando uma abordagem de camadas empilhadas. Você pode criar suas próprias camadas personalizadas ou aproveitar as muitas camadas pré-definidas oferecidas pela biblioteca.

- Suporte a GPU: Assim como outras bibliotecas de aprendizado de máquina, o PyTorch oferece suporte para acelerar cálculos usando GPUs. Isso é fundamental para treinamento rápido de modelos em grandes conjuntos de dados.

- Interface Numpy-like: As operações em tensores no PyTorch são semelhantes às operações do NumPy, o que facilita a transição para quem já está familiarizado com o NumPy.

- Suporte a Redes Neurais Convolucionais e Recorrentes: O PyTorch suporta a criação de vários tipos de redes neurais, incluindo redes convolucionais (CNNs) e redes recorrentes (RNNs). Isso o torna uma excelente escolha para tarefas de visão computacional e processamento de linguagem natural.

- API de Treinamento e Otimização: O PyTorch oferece classes e métodos para simplificar o processo de treinamento, incluindo otimizadores, funções de perda e ferramentas de avaliação.

- Integração com NumPy e TorchScript: O PyTorch pode ser integrado facilmente ao NumPy para manipulação de dados e processamento prévio. Além disso, o TorchScript permite a compilação de código PyTorch para aumentar o desempenho.

- Comunidade Ativa e Recursos: O PyTorch tem uma comunidade crescente e ativa que contribui com tutoriais, exemplos, documentação e pacotes adicionais. A PyTorch Hub oferece modelos pré-treinados e prontos para uso em várias aplicações.

- PyTorch Lightning e Fastai: Existem estruturas adicionais construídas sobre o PyTorch, como o PyTorch Lightning e o fastai, que fornecem abstrações de nível superior para simplificar ainda mais o treinamento de modelos complexos.

O PyTorch é especialmente valorizado por pesquisadores e cientistas de dados devido à sua natureza dinâmica e amigável ao prototipagem. Sua abordagem mais próxima do código permite que você mergulhe profundamente na construção e modificação de modelos, facilitando a experimentação e a inovação no campo de aprendizado de máquina e aprendizado profundo.

3.5 - XGBoost

O XGBoost (Extreme Gradient Boosting) é um algoritmo de aprendizado de máquina que pertence à categoria de algoritmos de boosting. Ele é amplamente utilizado para tarefas de classificação e regressão devido à sua eficácia em lidar com dados complexos e não lineares. Vamos detalhar os principais aspectos do XGBoost:

- Boosting: O XGBoost faz parte da família de algoritmos de boosting, que trabalham criando um modelo forte a partir de vários modelos fracos. A ideia central é ajustar os modelos subsequentes para corrigir os erros cometidos pelos modelos anteriores.

- Gradient Boosting: O XGBoost utiliza uma abordagem de gradient boosting, onde cada modelo subsequente é ajustado com base nos erros residuais dos modelos anteriores. Isso permite que o algoritmo se concentre nas áreas onde os modelos anteriores falharam.

- Árvores de Decisão: O XGBoost utiliza árvores de decisão como os modelos fracos subjacentes. Essas árvores são construídas de forma sequencial, onde cada nova árvore tenta corrigir os erros das árvores anteriores.

- Regularização: O XGBoost implementa técnicas de regularização para evitar o overfitting. Isso inclui termos de regularização L1 (lasso) e L2 (ridge) nas funções de custo, que penalizam os coeficientes maiores e ajudam a evitar a complexidade excessiva do modelo.

- Função de Custo Personalizável: O XGBoost permite a definição de funções de custo personalizadas, o que é útil quando se lida com tarefas específicas e necessidades de otimização.

- Feature Importance: O XGBoost fornece uma métrica de importância de recurso, que ajuda a identificar quais recursos têm mais impacto na previsão do modelo. Isso é valioso para entender a contribuição de cada recurso no resultado.

- Manuseio de Dados Ausentes: O XGBoost possui uma maneira eficaz de lidar com dados ausentes durante o treinamento, o que é importante para muitos conjuntos de dados do mundo real.

- Paralelização e Escalabilidade: O XGBoost é altamente otimizado e oferece paralelização automática de tarefas para melhorar a velocidade de treinamento em hardware moderno. Também é escalável para conjuntos de dados grandes.

- Regularização de Peso: O XGBoost permite a regularização de peso para as amostras durante o treinamento. Isso é útil para balancear conjuntos de dados desequilibrados.

- Tratamento de Outliers: O XGBoost possui uma abordagem robusta ao tratamento de outliers, minimizando seu impacto nas previsões do modelo.

- Interface Python e Integração: O XGBoost é implementado em várias linguagens, incluindo Python. Ele também é compatível com a API do Scikit-Learn, facilitando sua integração em fluxos de trabalho existentes.

O XGBoost tem sido uma escolha popular em competições de ciência de dados e é amplamente utilizado em projetos do mundo real. Sua eficácia em modelar relações complexas, bem como suas técnicas de regularização e recursos de otimização, o tornam uma ferramenta poderosa para resolver uma variedade de problemas de aprendizado de máquina.

3.6 - LightGBM

O LightGBM (Light Gradient Boosting Machine) é outro algoritmo de aprendizado de máquina que pertence à família de métodos de boosting. Ele foi projetado para ser eficiente em termos de uso de recursos e rápido em termos de treinamento, tornando-o uma escolha popular para lidar com grandes conjuntos de dados. Vamos detalhar os principais aspectos do LightGBM:

- Histogram-Based Learning: Uma característica única do LightGBM é o uso de histogramas para representar as distribuições dos valores das features. Isso permite uma maior eficiência computacional, pois reduz a necessidade de ordenar os dados em cada nó da árvore durante o processo de treinamento.

- Leaf-Wise Splitting: O LightGBM adota a técnica de divisão leaf-wise, que busca a divisão que resulta na maior redução no erro. Isso pode levar a um crescimento não uniforme da árvore, onde alguns ramos podem se expandir mais rapidamente do que outros.

- Gradient-Based One-Side Sampling: O LightGBM utiliza uma abordagem de amostragem unidirecional baseada no gradiente durante o processo de crescimento da árvore. Isso ajuda a selecionar amostras que têm mais influência na atualização do modelo.

- Regularização e Overfitting: O LightGBM implementa técnicas de regularização, como L1, L2 e exclusão por amostragem, para evitar o overfitting. Isso é especialmente importante em árvores de crescimento rápido.

- Eficiência e Paralelização: O LightGBM é altamente otimizado e aproveita o paralelismo tanto a nível de feature quanto de dados. Isso resulta em tempos de treinamento mais rápidos, especialmente em comparação com outros algoritmos de boosting.

- Suporte a Categorias: O LightGBM oferece suporte nativo para variáveis categóricas, permitindo a inclusão de dados categóricos diretamente no treinamento sem a necessidade de pré-processamento adicional.

- Aplicações de Aprendizado Automático de Alta Dimensão: O LightGBM é especialmente adequado para tarefas de alta dimensão, onde o número de features é grande em relação ao tamanho do conjunto de dados.

- Binning e Redução de Memória: A estratégia de histograma do LightGBM permite a quantização dos dados, o que pode reduzir a memória necessária para armazenar os dados, tornando-o mais eficiente em termos de uso de recursos.

- Compatibilidade Python e Scikit-Learn: O LightGBM possui uma interface Python e é compatível com a API do Scikit-Learn, tornando mais fácil sua integração em fluxos de trabalho de aprendizado de máquina existentes.

- Escalabilidade: Devido à sua eficiência e escalabilidade, o LightGBM é frequentemente usado em problemas onde o tempo de treinamento é um fator crítico.

O LightGBM é uma excelente opção para problemas que envolvem grandes volumes de dados e alta dimensionalidade, onde sua eficiência e capacidade de lidar com recursos categóricos podem resultar em um desempenho superior.

3.7 - Pandas

O pandas é uma das bibliotecas Python mais populares e amplamente utilizadas para análise e manipulação de dados. Ele oferece estruturas de dados flexíveis e eficientes para lidar com dados tabulares, como tabelas e planilhas, tornando-o essencial para tarefas de pré-processamento, análise exploratória e transformação de dados. Vamos detalhar os principais aspectos do pandas:

- DataFrames e Séries: O pandas introduz duas estruturas de dados fundamentais: DataFrames e Séries. Um DataFrame é uma tabela bidimensional com rótulos de linha e coluna, enquanto uma Série é uma estrutura unidimensional semelhante a uma matriz com rótulos de índice.

- Leitura e Escrita de Dados: O pandas oferece uma variedade de funções para importar e exportar dados em diversos formatos, como CSV, Excel, SQL, JSON e mais. Essa funcionalidade é crucial para a integração dos dados em fluxos de trabalho de análise.

- Indexação e Seleção: O pandas permite a indexação flexível dos dados por rótulos de linha e coluna, bem como por índices numéricos. Isso facilita a seleção e filtragem de dados específicos, permitindo a recuperação de informações relevantes.

- Operações de Limpeza e Transformação: O pandas oferece uma variedade de funções para limpar e transformar dados, como remoção de valores ausentes, renomeação de colunas, reindexação, conversão de tipos de dados e muito mais.

- Agregação e GroupBy: A funcionalidade GroupBy do pandas permite agrupar os dados com base em valores de uma ou mais colunas e, em seguida, aplicar operações de agregação, como soma, média, contagem, etc., aos grupos resultantes.

- Métodos de Estatísticas Descritivas: O pandas oferece funções estatísticas que permitem calcular métricas descritivas, como média, mediana, desvio padrão, entre outros, diretamente a partir dos DataFrames.

- Filtragem e Indexação Booleana: Os DataFrames podem ser filtrados usando expressões booleanas, permitindo a extração de linhas que atendam a determinadas condições.

- Operações Vetorizadas: O pandas é otimizado para operações vetorizadas, o que significa que muitas operações podem ser aplicadas de maneira eficiente em toda a estrutura de dados, sem a necessidade de loops explícitos.

- Combinação e Junção de Dados: O pandas permite a combinação de diferentes conjuntos de dados por meio de operações como concatenação, mesclagem e junção, que são essenciais para lidar com dados de várias fontes.

- Visualização de Dados: Embora o pandas não seja uma biblioteca de visualização, ele oferece integração com outras bibliotecas, como Matplotlib e Seaborn, para criar gráficos e visualizações dos dados.

O pandas é uma ferramenta essencial para cientistas de dados, analistas e engenheiros de aprendizado de máquina, pois fornece uma base sólida para o pré-processamento e exploração de dados antes de aplicar algoritmos de aprendizado de máquina. Sua sintaxe intuitiva e poderosa facilita o trabalho com dados tabulares de diversas fontes.

3.8 - Numpy

O NumPy (Numerical Python) é uma biblioteca fundamental em Python para computação numérica e científica. Ele fornece suporte para arrays multidimensionais, funções matemáticas de alto desempenho e ferramentas para trabalhar com dados numéricos. Aqui estão os principais aspectos do NumPy:

- Arrays NumPy: O coração do NumPy é a estrutura de dados ndarray (n-dimensional array), que é uma matriz homogênea de elementos. Esses arrays podem ter qualquer número de dimensões (e.g., 1D, 2D, 3D) e são a base para realizar cálculos numéricos eficientes.

- Indexação e Seleção: NumPy permite acessar elementos individuais e submatrizes de arrays usando indexação baseada em índices inteiros, fatias e máscaras booleanas. Isso facilita a recuperação de informações específicas dos dados.

- Operações Matemáticas: O NumPy oferece uma ampla variedade de funções matemáticas e operadores, que podem ser aplicados a arrays inteiros ou a elementos individuais. Essas operações são otimizadas para desempenho, o que é crucial para cálculos numéricos complexos.

- Broadcasting: O broadcasting é uma funcionalidade que permite que operações sejam executadas em arrays de diferentes formas e tamanhos sem a necessidade de replicar os dados. Isso simplifica muito a escrita de códigos e melhora o desempenho.

- Operações Lógicas e Booleanas: NumPy suporta operações lógicas (AND, OR, NOT) e de comparação (>, <, ==) em arrays, criando máscaras booleanas que podem ser usadas para indexação e filtragem de dados.

- Álgebra Linear: NumPy oferece funções para realizar operações de álgebra linear, como multiplicação de matrizes, decomposição de valores singulares, resolução de sistemas lineares, entre outras.

- Geração de Números Aleatórios: A biblioteca Random do NumPy permite a geração de números aleatórios e amostragem de distribuições de probabilidade, o que é essencial para simulações e experimentos.

- Manipulação de Forma e Redimensionamento: É possível modificar a forma dos arrays, bem como redimensioná-los usando funções do NumPy. Isso é útil para manipular os dados de acordo com os requisitos do problema.

- Entrada/Saída de Dados: NumPy oferece funcionalidades para ler e escrever dados em arquivos no formato de arrays, o que é útil para salvar e compartilhar conjuntos de dados.

- Desempenho e Otimização: NumPy é altamente otimizado para cálculos numéricos, permitindo que operações em grandes arrays sejam executadas de maneira eficiente. Ele também é a base de muitas outras bibliotecas científicas em Python.

NumPy é uma peça essencial do ecossistema de ciência de dados em Python. Sua eficiência e ampla gama de funcionalidades o tornam uma escolha popular para qualquer tarefa que envolva manipulação e análise de dados numéricos.

3.9 - Matplotlib

O Matplotlib é uma das bibliotecas mais populares em Python para visualização de dados e criação de gráficos de alta qualidade. Ele oferece uma ampla variedade de funções para criar gráficos estáticos, interativos e animados. Aqui estão os principais aspectos do Matplotlib:

- Tipos de Gráficos: O Matplotlib suporta uma ampla variedade de tipos de gráficos, incluindo gráficos de linha, barras, dispersão, histogramas, gráficos de pizza, gráficos 3D, entre outros. Isso permite que você escolha o tipo de gráfico mais adequado para representar seus dados.

- Customização de Gráficos: Uma das principais vantagens do Matplotlib é a capacidade de personalizar quase todos os aspectos dos gráficos. Você pode controlar cores, tamanhos, estilos de linha, marcadores, rótulos de eixos, títulos e muito mais.

- Múltiplos Eixos e Subplots: Matplotlib permite criar gráficos com múltiplos eixos e subplots em uma única figura. Isso é útil para comparar diferentes conjuntos de dados ou visualizar várias perspectivas de um mesmo conjunto.

- Legendas e Rótulos: A adição de legendas e rótulos é fácil com o Matplotlib. Você pode adicionar legendas explicativas para diferentes séries de dados e rotular eixos para tornar seus gráficos mais informativos.

- Exportação de Gráficos: Os gráficos criados com o Matplotlib podem ser exportados em vários formatos, como PNG, JPG, PDF e SVG. Isso é importante para compartilhar visualizações com outras pessoas.

- Integração com NumPy e Pandas: O Matplotlib é altamente integrado com outras bibliotecas científicas, como NumPy e Pandas. Isso facilita a criação de gráficos a partir de arrays NumPy ou DataFrames Pandas.

- Visualização de Dados 3D: Para dados tridimensionais, o Matplotlib oferece recursos para criar gráficos 3D, como scatter plots, superfícies e gráficos de contorno.

- Visualização de Mapas e Imagens: Matplotlib pode ser usado para plotar mapas geográficos, criar gráficos de calor e visualizar imagens 2D ou 3D.

- Widgets Interativos: Além dos gráficos estáticos, o Matplotlib também suporta recursos interativos por meio da integração com bibliotecas como o IPython e o Jupyter Notebook.

- Extensibilidade e Customização: Se você precisar de funcionalidades específicas que não estejam disponíveis nas funções padrão do Matplotlib, pode estender suas funcionalidades criando seus próprios componentes gráficos.

O Matplotlib é uma ferramenta indispensável para cientistas de dados, pesquisadores e engenheiros que precisam comunicar eficazmente seus insights por meio de visualizações. Sua flexibilidade, vasta gama de funcionalidades e suporte a diferentes estilos tornam-no uma escolha popular para a criação de gráficos em Python.

3.10 - Seaborn

O Seaborn é uma biblioteca de visualização de dados em Python que é construída em cima do Matplotlib. Ele fornece uma interface de alto nível para criar visualizações estatísticas atraentes e informativas. O Seaborn é especialmente útil quando se trata de criar gráficos complexos e estatísticos de maneira simples. Aqui estão os principais aspectos do Seaborn:

- Integração com Pandas: Assim como o Matplotlib, o Seaborn também é altamente integrado com o Pandas, o que facilita a visualização direta de DataFrames Pandas.

- Estilos de Plotagem Atraentes: O Seaborn oferece uma ampla variedade de estilos de plotagem pré-definidos que são visualmente atraentes. Isso permite criar gráficos com uma aparência profissional sem a necessidade de personalizações complexas.

- Visualizações Estatísticas: O foco principal do Seaborn é a criação de visualizações estatísticas, como gráficos de dispersão com ajuste linear, gráficos de distribuição, gráficos de relação, matrizes de correlação e muito mais.

- Colorização Automática: O Seaborn automatiza a escolha de paletas de cores adequadas para os diferentes tipos de dados. Isso é especialmente útil ao criar gráficos com várias categorias.

- Facet Grids e Pair Plots: O Seaborn permite criar facet grids, que são uma grade de subplots com variáveis diferentes. Isso é útil para visualizar interações entre várias variáveis. Além disso, a função pairplot cria uma matriz de gráficos de dispersão para todas as combinações possíveis de variáveis.

- Visualização de Distribuição e Estimativa de Densidade: O Seaborn oferece funções para criar histogramas, gráficos de densidade e gráficos de estimativa de densidade, que são úteis para entender a distribuição dos dados.

- Gráficos de Categorização: Seaborn oferece gráficos categóricos como gráficos de barras, gráficos de contagem e gráficos de caixa (box plots) que são úteis para representar distribuições de valores dentro de diferentes categorias.

- Customização Fácil: Embora o Seaborn tenha estilos predefinidos, ele também permite customizações avançadas dos gráficos para atender às suas necessidades específicas.

- Suporte a Coeficientes de Correlação: O Seaborn oferece funções para calcular e visualizar coeficientes de correlação, como o coeficiente de correlação de Pearson.

- Suporte a Gráficos Temporais: O Seaborn também pode ser usado para criar gráficos temporais, como séries temporais e visualizações de eventos ao longo do tempo.

O Seaborn é especialmente adequado para explorar relacionamentos entre variáveis em análises estatísticas e para criar gráficos estatísticos de maneira visualmente atraente e intuitiva. Sua interface de alto nível torna a criação de gráficos complexos mais simples, permitindo que os cientistas de dados e analistas foquem mais na interpretação dos resultados.