13 - Aprendizado Profundo (DL - Deep Learning)

O Aprendizado Profundo (DL - Deep Learning) no campo do Aprendizado de Máquina (ML - Machine Learning) é uma abordagem revolucionária que tem transformado a capacidade de computadores entenderem e processarem dados complexos.

Utilizando redes neurais profundas, compostas por camadas de unidades de processamento, o DL é capaz de aprender representações de dados cada vez mais abstratas e complexas.

Isso tem levado a avanços significativos em tarefas como reconhecimento de imagens, processamento de linguagem natural (NLP - Natural Language Processing) e muito mais.

À medida que os modelos se tornam mais profundos e as técnicas de treinamento se aprimoram, o DL continua a moldar o futuro da inteligência artificial e a encontrar aplicações em uma ampla gama de setores.

O DL se concentra em treinar modelos de redes neurais artificiais para realizar tarefas complexas de aprendizado a partir de dados brutos, e tem sido uma das tecnologias mais revolucionárias na área de inteligência artificial nas últimas décadas, impulsionando avanços significativos em diversas áreas, como visão computacional, NLP, reconhecimento de fala, jogos, entre outros.

Aqui estão os principais aspectos e conceitos do DL:

- Bibliotecas e Frameworks: Para implementar modelos de DL, os cientistas de dados e engenheiros usam bibliotecas e frameworks populares como TensorFlow, Keras e PyTorch, que oferecem ferramentas poderosas e flexíveis para construir, treinar e implantar modelos de DL.

- Redes Neurais Artificiais: O DL se baseia em redes neurais artificiais, que são modelos inspirados na estrutura e funcionamento do cérebro humano. Essas redes consistem em várias camadas de neurônios, cada um realizando operações simples, mas quando organizados em camadas, são capazes de aprender representações complexas dos dados.

- Camadas e Arquiteturas: As redes neurais de DL são compostas por várias camadas, incluindo camadas de entrada, camadas ocultas e camadas de saída. Existem diferentes arquiteturas de redes neurais, como Redes Neurais Convolucionais (CNNs - Convolutional Neural Networks) para visão computacional, Redes Neurais Recorrentes (RNNs - Recurrent Neural Networks) para sequências de dados e Redes Neurais Generativas (GANs - Generative Adversarial Networks) para geração de conteúdo.

- Aprendizado de Características (Feature Learning): Um dos principais aspectos do DL é sua capacidade de aprender características relevantes e significativas diretamente dos dados brutos. Isso significa que os modelos de DL podem aprender representações hierárquicas das características dos dados, o que torna o processo de extração de características manual menos necessário.

- Retropropagação (Backpropagation): O treinamento de redes neurais em DL é geralmente realizado usando o algoritmo de retropropagação (Backpropagation), que ajusta os pesos e viéses (bias) das conexões entre os neurônios com base nos erros obtidos durante o processo de treinamento.

- Transferência de Aprendizado (Transfer Learning): Uma técnica comum no DL é a transferência de aprendizado, que consiste em aproveitar modelos pré-treinados em grandes conjuntos de dados para tarefas específicas. Isso permite economizar tempo e recursos de treinamento e alcançar melhores resultados, especialmente quando os dados de treinamento são limitados.

- Aprendizados Supervisionado e Não Supervisionado: O DL pode ser aplicado tanto em tarefas de aprendizado supervisionado (com rótulos) quanto em tarefas de aprendizado não supervisionado (sem rótulos). Para o aprendizado supervisionado, as redes são treinadas com pares esperados de entrada e saída, enquanto no aprendizado não supervisionado, as redes aprendem a partir de dados não rotulados.

- Hardware: O treinamento de redes neurais profundas requer grandes quantidades de dados e poder computacional. Treinar modelos complexos pode ser computacionalmente intensivo e requer hardware especializado, como GPUs - Graphics Processing Units (Unidades de Processamento Gráfico) e TPUs - Tensor Processing Units (Unidades de Processamento de Tensores).

As técnicas de DL são aplicadas em uma variedade de campos e setores, devido à sua capacidade de lidar com tarefas complexas e aprender representações significativas diretamente dos dados brutos.

Algumas das principais áreas de aplicação incluem:

- Visão Computacional: O DL é amplamente usado em tarefas de visão computacional, como classificação de imagens, detecção de objetos, segmentação de imagens, reconhecimento facial, identificação de padrões, processamento de vídeo e muito mais.

- Processamento de Linguagem Natural (NLP - Natural Language Processing): As técnicas de DL são aplicadas em tarefas de NLP, como classificação de texto, tradução automática, resumo de texto, análise de sentimentos, processamento de voz e compreensão de linguagem natural.

- Reconhecimento de Fala: O DL é usado em sistemas de reconhecimento de fala para converter o discurso em texto, o que é amplamente utilizado em assistentes virtuais, sistemas de transcrição, controle de dispositivos por voz e muito mais.

- Jogos: Técnicas de DL têm sido usadas para treinar modelos que podem superar humanos em jogos complexos, como Go, xadrez, Dota 2 e StarCraft II.

- Saúde: Em aplicações médicas, o DL é usado para diagnóstico médico, detecção de doenças em imagens médicas (por exemplo, câncer de mama), análise de dados clínicos e previsão de resultados médicos.

- Setor Automotivo: No setor automotivo, o DL é aplicado em sistemas de condução autônoma para processar dados de sensores, tomar decisões em tempo real e ajudar a prevenir acidentes.

- Finanças: Em finanças, técnicas de DL são usadas para análise de risco, detecção de fraudes em transações financeiras, previsão de preços de ativos e otimização de investimentos.

- Indústria: Na indústria, o DL é aplicado em automação de processos, controle de qualidade, manutenção preditiva, visão computacional em robôs, entre outras aplicações.

Exemplo de visão Computacional:

No vídeo, à esquerda temos a simulação de 3 câmeras e à direita uma janela rodando em paralelo, em uma thread separada, detectando a presença de pessoas nas imagens das câmeras.

Essas são apenas algumas das inúmeras áreas onde as técnicas de DL têm sido aplicadas com sucesso. A flexibilidade e o poder das redes neurais artificiais possibilitam sua utilização em uma ampla variedade de problemas e cenários, tornando o DL uma das tecnologias mais impactantes e em constante crescimento no campo da inteligência artificial.

Existem várias bibliotecas Python especializadas em DL que oferecem ferramentas poderosas para construir, treinar e implantar modelos de redes neurais.

Algumas das principais bibliotecas são:

- TensorFlow: Desenvolvida pelo Google Brain, o TensorFlow é uma das bibliotecas mais populares e amplamente utilizadas para DL, proporcionando uma arquitetura flexível que permite criar modelos complexos de redes neurais, suporte a GPUs para acelerar o treinamento e implantação em diferentes plataformas.

- Keras: Keras é uma biblioteca de alto nível construída em cima do TensorFlow (e outras bibliotecas de DL, como Theano e Microsoft Cognitive Toolkit). Ele oferece uma API simples e intuitiva que facilita a construção rápida de modelos de redes neurais.

- PyTorch: Desenvolvido pelo Facebook, o PyTorch é outra biblioteca popular de DL. Ele se destaca por sua flexibilidade e facilidade de depuração, sendo amplamente adotado tanto em pesquisas acadêmicas quanto em aplicações industriais.

- MXNet: O MXNet é uma biblioteca escalável para DL, que oferece suporte a diferentes tipos de hardware, incluindo CPUs, GPUs e TPUs. Ele é conhecido por sua eficiência e desempenho em treinamento de modelos em grande escala.

- Caffe: O Caffe é uma biblioteca popular usada principalmente em visão computacional. Ele foi desenvolvido pela equipe da Universidade da Califórnia em Berkeley e é conhecido por sua velocidade e facilidade de uso.

- Theano: Embora o desenvolvimento oficial do Theano tenha sido encerrado, ele ainda é usado em algumas aplicações. O Theano foi uma das primeiras bibliotecas de DL em Python e serviu como base para o desenvolvimento de outras bibliotecas, como o Keras.

- CNTK (Microsoft Cognitive Toolkit): Desenvolvido pela Microsoft, o CNTK é outra biblioteca que oferece suporte a treinamento e inferência em redes neurais profundas. Ele se destaca por sua eficiência e suporte a múltiplas GPUs.

Essas são algumas das principais bibliotecas Python especializadas em DL. Cada uma delas tem suas características únicas e vantagens, e a escolha depende das necessidades específicas do projeto, da preferência pessoal e do suporte de hardware disponível. Muitas vezes, as bibliotecas são usadas em conjunto para aproveitar o melhor de cada uma delas.

O DL é uma poderosa abordagem de ML que tem tido um impacto significativo em várias áreas, permitindo que máquinas realizem tarefas complexas e alcancem resultados impressionantes em visão computacional, NLP e muitas outras aplicações. Seu contínuo desenvolvimento e avanços têm levado a conquistas notáveis em inteligência artificial e, por isso, o DL é amplamente adotado em projetos e pesquisas em todo o mundo.

13.1 - Introdução às Redes Neurais

As Redes Neurais Artificiais (ANNs - Artificial Neural Networks) representam um dos pilares do ML, sendo fundamentais para tarefas de classificação, regressão e muito mais. Inspiradas pelo funcionamento do cérebro humano, ANNs consistem em camadas de neurônios interconectados, que processam informações e aprendem a partir de dados. No entanto, a capacidade de ANNs de modelar relações em dados tabulares e sequenciais é limitada.

Para lidar com dados de imagem, as Redes Neurais Convolucionais (CNNs - Convolutional Neural Networks) surgiram como uma revolução. Com suas camadas convolucionais, as CNNs extraem características espaciais de imagens, tornando-as ideais para tarefas de visão computacional, como reconhecimento de objetos e segmentação de imagens. Elas são altamente eficazes na captura de padrões visuais complexos.

Enquanto ANNs e CNNs brilham em tarefas relacionadas a dados tabulares e imagens, as Redes Neurais Recorrentes (RNNs - Recurrent Neural Networks) são projetadas para lidar com dados sequenciais, como texto e séries temporais. As RNNs têm memória interna e podem capturar dependências temporais em dados, tornando-os adequados para tarefas de NLP, tradução automática e previsão de séries temporais.

As ANNs formam a base do ML e são amplamente aplicadas em muitas tarefas, as CNNs são a escolha principal para tarefas de visão computacional, enquanto as RNNs são cruciais para tarefas envolvendo dados sequenciais. A combinação dessas arquiteturas permite abordar uma ampla gama de problemas de ML, tornando as redes neurais uma ferramenta versátil na era da inteligência artificial.

As GANs (Redes Generativas Adversariais) são uma arquitetura especial de rede neural usada para a geração de dados, como imagens, e têm características únicas em comparação com ANNs, CNNs e RNNs

13.1.1 - Redes Neurais Artificiais (ANN - Artificial Neural Networks)

As Redes Neurais Artificiais (ANN - Artificial Neural Networks) são modelos matemáticos inspirados no funcionamento do cérebro humano, compostos por unidades interconectadas denominadas neurônios artificiais, ou "nós", organizadas em camadas e projetadas para resolver problemas de ML e tarefas de reconhecimento de padrões.

Estes modelos servem de base para várias técnicas de DL e têm sido usadas com sucesso em diversas aplicações.

Cada neurônio recebe entradas ponderadas, aplica uma função de ativação não linear a essas entradas e produz uma saída.

A conexão entre neurônios é representada por pesos, que são ajustados durante o processo de treinamento para que a rede possa aprender a mapear as entradas para as saídas corretas.

Cada neurônio recebe entradas, realiza operações matemáticas nelas e gera uma saída que é transmitida para outros neurônios na rede.

Essa estrutura em camadas é o que permite às ANNs aprenderem a partir dos dados e realizar tarefas complexas, como classificação, regressão, NLP, visão computacional, entre outros.

As ANNs são organizadas com camadas distintas:

- Camada de Entrada: Recebe os dados de entrada e transmite essas informações para a próxima camada. Cada neurônio na camada de entrada representa um recurso ou característica do dado de entrada.

- Camadas Ocultas (Hidden Layers): As camadas ocultas são responsáveis pelo processamento interno dos dados. Cada camada oculta contém um conjunto de neurônios que combinam e transformam as características de entrada para criar representações mais complexas e abstratas dos dados.

- Camada de Saída: É a última camada da rede e produz a saída final do modelo. Dependendo do tipo de tarefa (classificação, regressão, etc.), a camada de saída pode conter um ou mais neurônios.

O processo de treinamento de uma ANN envolve alimentar o modelo com um conjunto de dados de treinamento conhecidos e ajustar os pesos das conexões entre os neurônios para minimizar o erro entre as previsões da rede e as saídas corretas. Isso é geralmente feito usando algoritmos de otimização, como o gradiente descendente, que ajustam os pesos para que a rede possa aprender a representar corretamente os padrões nos dados de treinamento.

As ANNs têm sido aplicadas em uma ampla variedade de tarefas, como classificação de imagens, reconhecimento de fala, NLP, previsão de séries temporais, entre outras. Com o avanço das técnicas de DL, as ANNs têm se mostrado particularmente eficazes em tarefas que envolvem grandes volumes de dados e problemas complexos.

Um dos desafios do uso de ANNs é a necessidade de grandes quantidades de dados de treinamento e poder computacional para ajustar os milhões de pesos da rede. No entanto, com os avanços tecnológicos e o acesso a GPUs e TPUs, as ANNs têm se mostrado cada vez mais poderosas em uma variedade de aplicações, tornando-se uma das ferramentas mais importantes e impactantes no campo do ML e da Inteligência Artificial.

A seguir, apresentamos alguns conceitos importantes relacionados às Redes Neurais Artificiais:

- Neurônio Artificial: O neurônio artificial é a unidade básica de uma ANN. Cada neurônio recebe uma ou mais entradas e aplica uma função de ativação à soma ponderada dessas entradas. A saída do neurônio é transmitida para os neurônios nas camadas subsequentes ou é a saída final da rede, dependendo do tipo de ANN.

- Estrutura: Composta por camadas de neurônios totalmente conectados, adequada para uma variedade de tarefas, mas não lida com sequências ou dados de grade.

- Aplicação: Usadas em tarefas diversas, incluindo classificação de texto, regressão e processamento de linguagem natural.

- Camadas: As ANNs são organizadas em camadas, geralmente divididas em três tipos principais: camada de entrada, camadas ocultas (pode haver várias) e camada de saída. A camada de entrada recebe os dados brutos como entrada, as camadas ocultas são responsáveis por aprender e representar características complexas dos dados, e a camada de saída produz as previsões ou resultados finais.

- Conexões e Pesos: Cada neurônio está conectado a todos os neurônios da camada anterior e da camada seguinte (se houver). Cada conexão tem um peso associado, que representa a força da influência da saída de um neurônio na entrada do outro neurônio. Os pesos são ajustados durante o processo de treinamento da rede para melhorar o desempenho do modelo.

- Funções de Ativação: Cada neurônio aplica uma função de ativação em sua saída antes de transmiti-la aos neurônios na próxima camada. A função de ativação introduz a não-linearidade na rede, permitindo que ela aprenda relações complexas nos dados. Algumas funções de ativação comuns são a função sigmoide, a função ReLU - Rectified Linear Unit (Unidade Linear Retificada) e a função tangente hiperbólica.

- Propagação Direta (Feedforward) e Retropropagação (Backpropagation): O processo de treinamento em uma ANN geralmente é feito usando a técnica de propagação direta e retropropagação. A propagação direta é a etapa de fazer a propagação das entradas pela rede, obtendo as previsões. Em seguida, é calculada a perda (ou erro) entre as previsões da rede e os rótulos reais do conjunto de treinamento. A retropropagação é a etapa de ajustar os pesos das conexões para minimizar a perda, usando técnicas de otimização, como o gradiente descendente.

- Arquitetura e Hiperparâmetros: A escolha da arquitetura da rede, incluindo o número de camadas ocultas, o número de neurônios em cada camada e as funções de ativação, é um dos desafios em projetar uma ANN. Além disso, hiperparâmetros como a taxa de aprendizado, o número de episódios de treinamento e o tamanho do lote também afetam o desempenho do modelo.

- Convolução/Recorrência: Não incorporam convolução ou recorrência; camadas densamente conectadas.

- Uso de Memória: Não mantêm memória de longo prazo; operações independentes.

- Paralelismo: Altamente paralelizáveis, eficazes em hardware acelerado.

As ANNs são uma das ferramentas mais poderosas do ML moderno e têm alcançado resultados impressionantes em uma variedade de domínios.

No entanto, treinar redes neurais profundas pode exigir grandes quantidades de dados e poder computacional, mas com os avanços em hardware e algoritmos, as ANNs continuam sendo objeto de pesquisa intensiva e são amplamente utilizadas em problemas complexos de aprendizado.

13.1.2 - Redes Neurais Convolucionais (CNNs - Convolutional Neural Networks)

As Redes Neurais Convolucionais (CNNs - Convolutional Neural Networks) são um tipo especializado de ANNs que se destacam em tarefas de visão computacional, como classificação de imagens, detecção de objetos e segmentação semântica.

Elas foram inspiradas pela organização do córtex visual no cérebro humano e têm demonstrado um desempenho impressionante em diversas aplicações.

As CNNs são projetadas para trabalhar com dados que têm uma estrutura espacial, como imagens, e têm a capacidade de aprender representações hierárquicas e invariantes da translação de características dos dados.

Isso é possível devido a duas operações principais que as CNNs empregam: convolução e agrupamento (pooling).

Conceitos das CNNs:

- Aplicação: Usadas principalmente em visão computacional para classificação de imagens, detecção de objetos e processamento de imagens.

- Estrutura: Projetadas para dados de grade, como imagens, com camadas de convolução que preservam a estrutura espacial. Usam convolução para extrair características espaciais em dados de grade.

- Arquitetura: As CNNs geralmente têm uma arquitetura empilhada com várias camadas de convolução, seguidas por camadas de agrupamento e camadas totalmente conectadas no final. Algumas arquiteturas famosas incluem a LeNet, AlexNet, VGG, ResNet, Inception e muitas outras.

- Uso de Memória: Não possuem memória interna; operações locais.

- Paralelismo: Paralelismo limitado nas camadas de convolução.

Camadas nas CNNs:

- Camada de Convolução (Conv2D): Essa camada aplica filtros de convolução a uma entrada para extrair características locais em imagens, como bordas, texturas e padrões mais complexos e outros atributos importantes para a tarefa de classificação ou detecção. A convolução é a operação central em uma CNN. Ela consiste em aprender aplicando um conjunto de filtros (ou kernels) sobre a imagem de entrada para extrair características relevantes. Os filtros são pequenas janelas deslizantes que se movem pela imagem, calculando o produto escalar entre si e a região da imagem que está sendo analisada. Isso produz um mapa de características que ressalta padrões específicos presentes na imagem.

- Camadas de Agrupamento (Pooling) (MaxPooling2D, AveragePooling2D): As camadas de agrupamento (pooling, também conhecidas como camadas de subamostragem) são usadas para reduzir a dimensionalidade dos mapas de características, reduzindo a resolução espacial, mantendo as características mais relevantes e tornar a rede computacionalmente mais eficiente. A operação de agrupamento, geralmente agrupamento máximo (max pooling), seleciona o valor máximo em uma região da imagem, descartando o restante. Isso ajuda a preservar as informações mais relevantes e a reduzir o efeito da variação espacial. O MaxPooling2D, por exemplo, mantém o valor máximo em uma região, enquanto o AveragePooling2D usa a média.

- Camada de Normalização de Lotes (Batch Normalization): Essa camada normaliza os valores nas camadas anteriores, o que pode acelerar o treinamento e torná-lo mais estável.

- Camada de Ativação (ReLU): A função de ativação ReLU - Rectified Linear Unit (Unidade Linear Retificada) é frequentemente usada após as camadas de convolução e outras para introduzir não linearidade na rede.

- Camadas Totalmente Conectadas (Dense): Em redes profundas, as Camadas Totalmente Conectadas (Fully Connected Layers) são camadas densas totalmente conectadas, usadas para realizar classificação final ou outras tarefas. Após as camadas de convolução e de agrupamento, os dados são achatados e alimentados em camadas totalmente conectadas, semelhantes às utilizadas em redes neurais tradicionais. Essas camadas finais são responsáveis por fazer a classificação ou regressão com base nas características extraídas anteriormente.

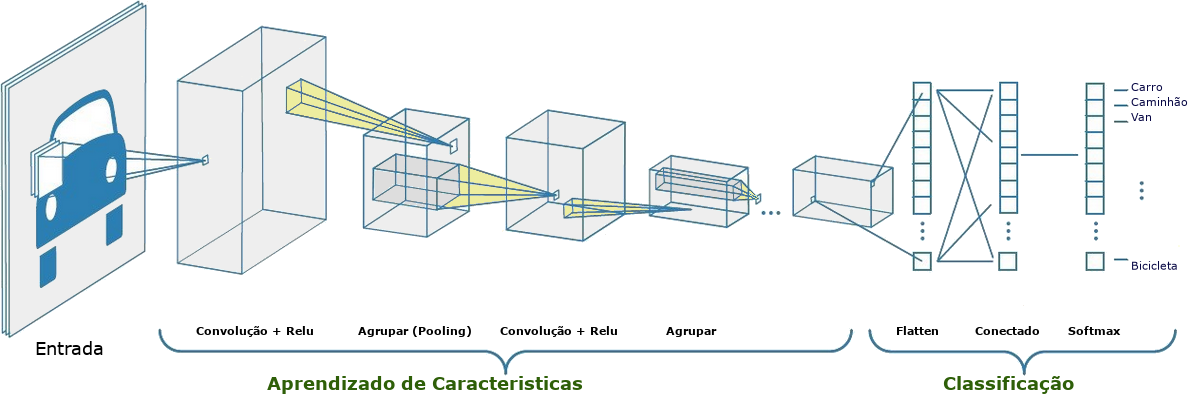

Podemos observar como funciona uma CNN na prática com o diagrama abaixo:

Na primeira etapa, entrada, a rede irá receber uma imagem já pré-processada, geralmente a imagem é representada em 3 camadas RGB ou em tons de cinza.

Em seguida, na etapa de aprendizado de características (feature learning), estas serão aprendidas pelos processos de convolução e agrupamento.

O processo de convolução consiste em utilizar um filtro, também chamado de kernel, para percorrer várias pequenas matrizes na imagem e identificar suas características mais importantes.

Quanto ao agrupamento (pooling), que pode ser interpretado como uma camada simplificadora da camada anterior, atua reduzindo o tamanho dos mapas de características gerados pelas camadas de convolução, para que o processo seja otimizado no decorrer da rede.

Na última etapa, classificação, a rede usará um Perceptron de Múltiplas Camadas (MLP - Multi-Layer Perceptron), ou uma camada totalmente conectada, para realizar a classificação baseando-se nas características obtidas na etapa de aprendizagem de características.

Perceptrons de múltiplas camadas são uma classe de redes neurais artificiais que consistem em múltiplas camadas de neurônios interconectados, incluindo uma camada de entrada, uma ou mais camadas ocultas e uma camada de saída. Cada neurônio em uma camada está conectado a todos os neurônios na camada seguinte, tornando os MLPs capazes de aprender representações complexas de dados. São amplamente utilizados para tarefas de classificação, regressão e outras tarefas de aprendizado supervisionado, devido à sua capacidade de modelar relações não lineares nos dados. O treinamento de MLPs geralmente envolve algoritmos de retropropagação, que ajustam os pesos das conexões para minimizar uma função de perda, permitindo que o modelo faça previsões precisas.

Aqui está um exemplo de como as classes de camadas do Keras podem ser usadas em uma arquitetura de CNN:

from tensorflow.keras.layers import Conv2

from tensorflow.keras.layers import MaxPooling2D

from tensorflow.keras.layers import Flatten

from tensorflow.keras.layers import Dense

from tensorflow.keras.models import Sequential

from tensorflow.keras.datasets import mnist

(x_treino, y_treino), (x_teste, y_teste) = mnist.load_data()

modelo = Sequential()

modelo.add(Conv2(32, (3, 3), activation='relu', input_shape=(28, 28, 1)))

modelo.add(MaxPooling2D((2, 2)))

modelo.add(Flatten())

modelo.add(Dense(128, activation='relu'))

modelo.add(Dense(10, activation='softmax'))

modelo.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

modelo.fit(x_treino, y_treino, epochs=10)

modelo.evaluate(x_teste, y_teste)

modelo.predict(x_teste)As CNNs têm tido um impacto significativo em tarefas de visão computacional e se mostraram altamente eficazes em reconhecimento de padrões em imagens.

Além disso, suas arquiteturas têm sido adaptadas para outros tipos de dados estruturados, como séries temporais e dados de áudio.

Devido ao seu poder de representação e aprendizado de características relevantes, as CNNs são amplamente utilizadas em uma variedade de aplicações, desde carros autônomos até diagnóstico médico e muito mais.

13.1.3 - Redes Neurais Recorrentes (RNNs - Recurrent Neural Networks)

As Redes Neurais Recorrentes (RNNs - Recurrent Neural Networks) são um tipo especializado de ANN projetadas para lidar com dados sequenciais, como séries temporais, texto e fala. A principal característica das RNNs é a capacidade de lidar com sequências de comprimentos variáveis, mantendo uma memória interna que permite que elas considerem informações contextuais de eventos anteriores ao processar o próximo elemento da sequência.

Diferentemente das CNNs, que são altamente eficazes para dados com estrutura espacial, as RNNs são projetadas para dados com dependências temporais e são especialmente adequadas para problemas que envolvem previsão, classificação ou geração de sequências.

Conceitos das RNNs:

- Aplicação: Aplicadas a tarefas que envolvem sequências, como previsão de séries temporais, tradução automática, geração de texto e análise de linguagem natural, possuindo unidades recorrentes para capturar dependências temporais em sequências.

- Estrutura Recorrente: Especializadas em dados sequenciais e temporais, com unidades recorrentes para capturar dependências temporais. A característica distintiva de uma RNN é a estrutura recorrente, que permite que as informações fluam em laços (loops), permitindo que a rede mantenha uma memória interna. Em cada etapa de tempo, a RNN recebe uma entrada do elemento atual da sequência e também recebe informações da saída do estado interno (memória) da etapa de tempo anterior.

- Célula Recorrente: A célula recorrente é o bloco de construção básico de uma RNN. É responsável por manter o estado interno (memória) da rede e atualizá-lo conforme a sequência é processada. A célula recorrente usa os dados de entrada e o estado anterior para calcular a saída e o novo estado interno.

- Retropropagação ao Longo do Tempo (BPTT - Backpropagation Through Time): O treinamento de uma RNN é feito usando uma técnica chamada retropropagação ao longo do tempo (BPTT). Essa técnica é uma extensão do algoritmo de retropropagação padrão que lida com sequências. O BPTT permite que os gradientes de erro sejam propagados através do tempo, atualizando os pesos da rede para minimizar o erro ao longo de toda a sequência.

- Problema do Gradiente Desvanecente (VGP - Vanishing Gradient Problem): As RNNs podem enfrentar o problema do gradiente desvanecente durante o treinamento. Isso acontece porque, em sequências longas, os gradientes podem diminuir drasticamente à medida que são propagados para etapas de tempo anteriores, tornando difícil atualizar os pesos em camadas distantes do passado. Para resolver esse problema, surgiram variantes das RNNs, como as LSTMs - Long Short-Term Memories (Memórias de Longo Prazo) e as GRUs - Gated Recurrent Units (Unidades Recorrentes Fechadas), que são projetadas para preservar melhor as informações de longo prazo.

- Uso de Memória: Mantêm memória de curto e longo prazo por meio de unidades recorrentes.

- Paralelismo: Restrições de paralelismo devido à natureza sequencial.

Camadas nas CNNs:

- Camada Recorrente (SimpleRNN, LSTM, GRU): As RNNs usam camadas recorrentes para lidar com dados sequenciais. Existem várias variantes, como SimpleRNN (recorrente simples), LSTM (Long Short-Term Memory) e GRU (Gated Recurrent Unit), que lidam de diferentes maneiras com a memória de sequências.

- Camada de Embedding: Essa camada é frequentemente usada para representar palavras ou símbolos em vetores contínuos antes de alimentá-los à rede.

- Camada de Ativação (ReLU, tanh, sigmoid): Funções de ativação não lineares são usadas nas camadas recorrentes para introduzir não linearidade.

- Camada de Máscara (Masking): A camada de máscara é usada para mascarar entradas em sequências com comprimentos variáveis, o que é comum em processamento de linguagem natural.

- Camada de Abandono (Dropout): Para regularização, as camadas de abandono são usadas para evitar overfitting.

- Camada de Saída (Dense): Uma camada densa geralmente é usada para produzir a saída final da rede, como a previsão em séries temporais ou classificação em texto.

Aqui está um exemplo de como as classes de camadas do Keras podem ser usadas em uma arquitetura de CNN:

from keras.models import Sequential

from keras.layers import SimpleRNN, Embedding, Dense

# Crie um modelo de RNN sequencial

modelo = Sequential()

# Adicione uma camada de embedding para representar palavras em vetores contínuos

modelo.add(Embedding(input_dim=1000, output_dim=128, input_length=20))

# Adicione uma camada recorrente SimpleRNN com 64 unidades

modelo.add(SimpleRNN(64, activation='relu'))

# Camada de saída com ativação softmax para classificação

modelo.add(Dense(10, activation='softmax'))As RNNs têm sido amplamente utilizadas em tarefas de NLP, como tradução automática, geração de texto e análise de sentimento, bem como em outras tarefas que envolvem sequências temporais, como previsão de séries temporais, reconhecimento de fala, entre outras. Com as variantes mais avançadas, como as LSTMs e GRUs, as RNNs são capazes de aprender dependências temporais de longo prazo e lidar com sequências mais extensas e complexas.

13.1.4 - Redes Neurais Generativas (GANs - Generative Adversarial Networks)

As Redes Neurais Generativas (GANs - Generative Adversarial Networks) são uma arquitetura especial de rede neural usada para a geração de dados, como imagens, e têm características únicas em comparação com ANNs, CNNs e RNNs.

Consistem em duas redes neurais, o Gerador e o Discriminador, que competem em um jogo adversarial. O Gerador cria dados sintéticos, enquanto o Discriminador tenta distinguir entre dados reais e sintéticos.

Aspectos mencionados em relação às GANs:

- Estrutura: Duas redes neurais, uma com o Gerador e a outra com o Discriminador, que competem em um jogo adversarial.

- Aplicação Principal: A principal aplicação das GANs é a geração de dados realistas. Isso inclui a geração de imagens, vídeos, áudio e muito mais. GANs também são usadas em tarefas de super-resolução, tradução de estilo e geração de conteúdo.

- Convolução vs. Recorrência: As GANs podem incorporar camadas de convolução em seu Gerador e Discriminador, semelhantes às CNNs, para processar dados de imagem. No entanto, GANs não são voltadas para lidar com sequências temporais, como as RNNs.

- Uso de Memória: As GANs não possuem memória de longo prazo como as RNNs. No entanto, elas têm memória de curto prazo durante o treinamento para ajustar o modelo com base nas atualizações do Discriminador.

- Paralelismo: O treinamento de GANs pode ser paralelizado, mas é frequentemente demorado. Treinar GANs profundas pode ser computacionalmente intensivo, requerendo recursos de hardware significativos.

- Gradiente: As GANs também podem enfrentar problemas de gradiente, como desaparecimento ou explosão de gradiente, especialmente em redes profundas. Isso pode afetar a convergência e a qualidade da geração.

- Aprendizado de Características: As GANs realizam aprendizado de características de maneira única. O Gerador aprende a criar características sintéticas que enganam o Discriminador, enquanto o Discriminador aprende a distinguir características realistas das sintéticas. Esse processo iterativo resulta no aprendizado de características relevantes para a geração de dados.

As GANs são uma arquitetura especializada para a geração de dados realistas, envolvendo uma competição adversarial entre o Gerador e o Discriminador. Elas podem incorporar elementos de CNNs para processamento de imagem, mas não são projetadas para lidar com sequências temporais.

O treinamento de GANs pode ser desafiador e requer atenção especial aos problemas de gradiente. Seu foco principal é o aprendizado de características para a geração de dados, resultando em aplicações emocionantes em áreas como visão computacional e geração de conteúdo.

13.2 - Conceitos Importantes

Alguns conceitos importantes sobre os neurônios, gradientes e aprendizado de características.

13.2.1 - Neurônios

Os neurônios em cada camada são responsáveis por aprender representações dos dados e transmitir essas representações às camadas subsequentes.

O número de neurônios em cada camada de uma rede neural é uma parte fundamental do projeto da rede e tem um impacto significativo no seu desempenho e capacidade de aprendizado, afetando a capacidade da rede de aprender representações complexas dos dados.

Camadas com mais neurônios podem aprender representações mais ricas, mas também podem aumentar a complexidade do modelo.

É importante ajustar esse hiperparâmetro com base na natureza da tarefa e na quantidade de dados disponíveis para o treinamento. Experimentar diferentes tamanhos de camada pode ser necessário para encontrar a configuração ideal para um problema específico.

Vamos explorar como isso funciona.

Número de Neurônios em uma Camada

O número de neurônios em uma camada é também chamado de "tamanho" ou "largura" da camada. É uma das principais decisões de hiperparâmetros ao projetar uma rede neural.

O número de neurônios em uma camada pode variar de acordo com a tarefa. Em geral, uma camada com mais neurônios é capaz de aprender representações mais complexas, mas também pode levar a um aumento na complexidade do modelo e na necessidade de mais dados de treinamento.

Função de Ativação

Cada neurônio em uma camada é associado a uma função de ativação, que determina como o neurônio responde a entradas. Funções comuns incluem ReLU (Unidade Linear Retificada), sigmoid e tangente hiperbólica.

Passagem de Informações

Durante o treinamento, as informações fluem da camada de entrada para as camadas ocultas e, finalmente, para a camada de saída. A passagem de informações ocorre da seguinte maneira:

As entradas são multiplicadas pelos pesos sinápticos associados a cada neurônio na camada.

Os resultados são somados e, em seguida, a função de ativação é aplicada a essa soma para produzir a saída do neurônio.

As saídas dos neurônios em uma camada se tornam as entradas para a camada seguinte. Esse processo de propagação de informações é repetido em todas as camadas da rede até a camada de saída.

Camadas Ocultas e Representações de Características

As camadas intermediárias, chamadas camadas ocultas, são responsáveis por aprender representações intermediárias dos dados. Quanto mais camadas ocultas a rede possui, mais níveis de abstração ela pode aprender.

O número de neurônios em cada camada oculta determina a dimensionalidade dessas representações intermediárias. Camadas com mais neurônios podem aprender representações mais ricas, enquanto camadas com menos neurônios podem aprender representações mais simples.

Aprendizado

Durante o treinamento, a rede ajusta os pesos sinápticos (parâmetros) de cada neurônio para minimizar a função de perda. Isso envolve a propagação do erro retroativamente, ou seja, a retropropagação, para ajustar os pesos em todas as camadas.

13.2.2 - Gradientes

Os gradientes se referem às derivadas parciais de uma função de perda em relação aos parâmetros do modelo. Essas derivadas indicam como a função de perda muda à medida que os parâmetros do modelo são ajustados, e são fundamentais para o processo de treinamento de redes neurais.

Para entender melhor o papel dos gradientes no Aprendizado Profundo, aqui estão alguns pontos-chave:

- Função de Perda (Loss Function): A função de perda é uma métrica que quantifica o quão bem o modelo está executando a tarefa. Ela fornece um valor que desejamos minimizar durante o treinamento.

- Gradiente Descendente (Gradient Descent): A otimização no treinamento de redes neurais geralmente envolve a minimização da função de perda. O Gradiente Descendente é um algoritmo utilizado para encontrar os valores dos parâmetros do modelo que minimizam a função de perda.

- Retropropagação de Gradientes: Durante o treinamento, os gradientes são calculados usando a técnica de retropropagação (backpropagation). O processo envolve o cálculo das derivadas parciais da função de perda em relação a todos os parâmetros do modelo. Esses gradientes indicam a inclinação da função de perda em relação a cada parâmetro.

- Atualização dos Parâmetros: Os gradientes são usados para atualizar os parâmetros do modelo em cada iteração do treinamento. A ideia é ajustar os parâmetros na direção em que a função de perda está diminuindo mais rapidamente, o que leva o modelo a um ponto de mínimo da função de perda.

- Taxa de Aprendizado (Learning Rate): A taxa de aprendizado é um hiperparâmetro importante que controla o tamanho dos passos de atualização dos parâmetros com base nos gradientes. Uma taxa de aprendizado adequada é crucial, pois uma taxa muito alta pode fazer com que o treinamento seja instável, e uma taxa muito baixa pode tornar o treinamento demorado ou resultar em convergência para mínimos locais.

- Mínimos Locais e Globais: É importante observar que a otimização com base em gradientes pode levar a mínimos locais em vez de mínimos globais na função de perda. No entanto, na prática, redes neurais profundas frequentemente conseguem bons resultados, mesmo em mínimos locais.

Os gradientes desempenham um papel essencial no treinamento de redes neurais. Eles guiam o processo de ajuste dos parâmetros do modelo para minimizar a função de perda, permitindo que a rede aprenda a fazer previsões precisas em tarefas de aprendizado supervisionado.

13.2.3 - Retropropagação

O retropropagação (backpropagation) é um algoritmo fundamental para o treinamento de redes neurais artificiais, especialmente em modelos de aprendizado supervisionado. Ele é usado para calcular os gradientes dos pesos da rede em relação à função de perda, permitindo assim a atualização dos pesos durante o processo de treinamento.

A ideia central da retropropagação é realizar uma propagação do erro da saída da rede para as camadas anteriores, calculando os gradientes das funções de ativação em relação aos pesos.

Esse processo acontece em duas fases: a fase de passagem direta (forward pass) e a fase de passagem reversa (backward pass).

- Fase de Passagem Direta (Forward Pass): Durante a passagem direta, os dados de entrada são alimentados na rede, e a saída do modelo é calculada. Cada camada da rede realiza uma combinação linear das entradas ponderadas pelos pesos, seguida pela aplicação de uma função de ativação não linear. Essa sequência de operações é realizada camada por camada, até que a saída final seja produzida.

- Fase de Passagem Reversa (Backward Pass): Após calcular a saída da rede durante a passagem direta (forward pass), o algoritmo de retropropagação inicia a fase de passagem reversa, onde o erro entre a saída prevista e o valor real (rótulo) é propagado para trás na rede. Para calcular os gradientes dos pesos, o algoritmo utiliza a regra da cadeia da derivada, que permite calcular o gradiente de uma função composta em relação a uma variável específica. Os gradientes são calculados recursivamente, começando pela camada de saída e avançando em direção à camada de entrada.

- Atualização dos Pesos: Após calcular os gradientes dos pesos em relação à função de perda, o algoritmo utiliza um otimizador, como o gradiente descendente ou suas variantes, para atualizar os pesos da rede, com o objetivo de minimizar a função de perda. O processo de atualização dos pesos é repetido em cada iteração do treinamento (episódios) até que a rede alcance um bom desempenho na tarefa.

O retropropagação é essencial para o treinamento de redes neurais profundas, onde há várias camadas ocultas, pois permite que a informação do erro seja propagada eficientemente através da rede, ajustando os pesos para que o modelo possa aprender a representar os padrões e relacionamentos presentes nos dados de treinamento.

É importante mencionar que o sucesso da retropropagação está ligado ao uso de funções de ativação não lineares nas camadas ocultas da rede. Sem as funções não lineares, a rede seria apenas uma combinação linear de operações, tornando-a incapaz de aprender representações complexas e abstratas dos dados.

13.2.4 - Aprendizado de Características

O Aprendizado de Características (FL - Features Learning) é uma etapa essencial em tarefas de ML e DL, agindo no processo de identificar e criar representações ou características significativas e informativas a partir dos dados brutos, tornando-os mais adequados para a tarefa específica em questão.

As características são representações que descrevem diferentes aspectos dos dados, e a qualidade dessas características pode ter um grande impacto no desempenho dos modelos de ML. Quando as características são bem escolhidas e representam de forma eficiente as informações importantes nos dados, os modelos tendem a ter um desempenho melhor e mais robusto.

Existem duas abordagens principais para o FL:

- Extração Manual de Características: Nesta abordagem, as características são projetadas e selecionadas manualmente pelos engenheiros de dados ou especialistas no domínio do problema. Isso requer um conhecimento profundo do domínio e do problema específico, para que as características escolhidas sejam relevantes e informativas. Embora essa abordagem permita maior controle sobre as características, ela também pode ser trabalhosa e limitada pela capacidade humana de identificar todas as informações importantes nos dados.

- Aprendizado Automático de Características: Nesta abordagem, as características são aprendidas automaticamente pelo modelo durante o treinamento. Em vez de depender de características pré-definidas, o modelo é projetado para aprender representações mais úteis e significativas diretamente dos dados brutos. Essa abordagem é especialmente poderosa quando usada com Redes Neurais Artificiais e outras técnicas de DL, onde várias camadas ocultas podem aprender gradualmente representações mais abstratas e complexas dos dados. Essa capacidade de aprendizado automático de características tem sido um dos principais impulsionadores do sucesso do DL em várias tarefas, como visão computacional, NLP e reconhecimento de padrões em geral.

O FL é uma etapa crítica no processo de preparação dos dados para a modelagem de ML e DL. A escolha ou aprendizado de características adequadas pode fazer uma grande diferença no desempenho dos modelos, permitindo que eles capturem com eficácia os padrões e informações importantes presentes nos dados e tornando-os mais robustos e eficientes em suas tarefas.

As três arquiteturas de redes neurais - ANNs, CNNs e RNNs - têm a capacidade de realizar FL, embora a maneira como o fazem possa variar:

As ANNs podem realizar FL, mas geralmente dependem da pré-processamento dos dados de entrada. O FL é frequentemente feita antes de alimentar os dados à rede, no estágio de pré-processamento dos dados. Isso pode incluir redimensionamento, normalização, codificação de variáveis categóricas e extração de características antes de alimentar os dados à camada de entrada da rede.

As CNNs são especialmente eficazes em realizar FL diretamente dos dados de imagem. Elas podem aprender automaticamente a extrair características relevantes das imagens, como bordas, texturas e padrões complexos. O FL ocorre nas camadas de convolução e agrupamento (pooling) de uma CNN. As camadas de convolução aplicam filtros para extrair características locais, enquanto as camadas de pooling reduzem a dimensionalidade e mantêm características relevantes.

As RNNs não são tradicionalmente usadas para o FL, mas podem ser usadas para processar sequências de dados e aprender representações temporais. A principal função das RNNs é modelar dependências temporais em sequências. Elas não realizam FL no sentido convencional, mas podem aprender representações de sequências durante o treinamento.

Todas as três arquiteturas podem contribuir para o FL, mas a maneira como o fazem varia. As CNNs são especialmente poderosas na extração automática de características de imagens, enquanto as ANNs geralmente dependem de pré-processamento de dados. As RNNs são mais focadas em modelar dependências temporais em sequências de dados, embora também possam aprender representações de sequências.

13.2.5 - Transferência de Aprendizado

A Transferência de Aprendizado (LT - Learning Transfer) é uma técnica essencial em ML e DL que permite aproveitar conhecimentos adquiridos em uma tarefa ou domínio para melhorar o desempenho em outra tarefa ou domínio relacionado. É uma abordagem poderosa que ajuda a economizar tempo e recursos no treinamento de modelos, especialmente quando há limitações de dados disponíveis.

Princípio da LT

O princípio básico da LT é que um modelo que tenha sido treinado para uma tarefa específica pode aprender representações de características gerais que são úteis para outras tarefas relacionadas.

Essas representações gerais são aprendidas nas camadas mais profundas da rede neural, capturando informações abstratas e complexas dos dados.

Etapas da LT

A aplicação da LT geralmente envolve as seguintes etapas:

- Pré-treinamento (Pretraining): Inicialmente, um modelo é pré-treinado em uma grande quantidade de dados em uma tarefa ou domínio de origem, geralmente em um conjunto de dados com uma quantidade significativa de amostras rotulados. O objetivo é aprender representações de características úteis para a tarefa de origem.

- Extração de Características (Feature Extraction): Após o pré-treinamento, a parte da rede neural que contém as camadas profundas é removida e usada como uma ferramenta de extração de características. Essas camadas são capazes de capturar características gerais dos dados que podem ser reutilizadas para outras tarefas.

- Treinamento (Finetuning): Em seguida, a parte da rede neural remanescente é adicionada, formando um novo modelo. Essa parte é chamada de cabeça do modelo e é usada para ajustar as características aprendidas do modelo de origem para a tarefa de destino. O treinamento é feito em um conjunto de dados menor e mais específico, geralmente com menos amostras rotuladas disponíveis.

Vantagens da LT

A LT oferece várias vantagens:

- Economia de Tempo e Recursos: Ao utilizar um modelo pré-treinado em uma tarefa de origem, é possível economizar tempo e recursos no treinamento do modelo para a tarefa de destino.

- Melhor Desempenho: O uso de características aprendidas em tarefas de origem pode melhorar significativamente o desempenho em tarefas de destino, especialmente quando há poucos dados rotulados disponíveis.

- Generalização Melhorada: As características aprendidas em tarefas de origem tendem a capturar informações mais gerais dos dados, o que pode levar a uma melhor generalização para tarefas de destino relacionadas.

Aplicações da LT

A LT tem aplicações em diversas áreas, incluindo:

- Classificação de imagens em diferentes categorias.

- Reconhecimento de fala e processamento de linguagem natural.

- Detecção de objetos em imagens.

- Previsão de séries temporais em domínios relacionados.

E muitas outras tarefas de ML.

A LT é uma técnica poderosa que permite aproveitar o conhecimento adquirido em tarefas de origem para melhorar o desempenho em tarefas de destino relacionadas.

É especialmente útil quando há poucos dados rotulados disponíveis para a tarefa de destino, tornando-se uma estratégia valiosa para o sucesso de muitos projetos de ML e DL.

13.2.6 - Aprendizado Supervisionado e Não Supervisionado

O Aprendizado Supervisionado (SL - Supervised Learning) é uma das principais categorias de técnicas de ML. Nesse tipo de aprendizado, o modelo é treinado utilizando um conjunto de dados rotulados, ou seja, dados nos quais as saídas desejadas ou rótulos estão disponíveis para cada exemplo de entrada.

O processo de treinamento do modelo envolve ajustar os parâmetros do modelo para que ele seja capaz de mapear corretamente as entradas para as saídas corretas. O objetivo do SL é fazer com que o modelo generalize bem para novos dados não vistos durante o treinamento, sendo capaz de fazer previsões precisas para novas amostras.

Algumas das principais tarefas de SL incluem:

- Classificação: O modelo deve atribuir uma categoria ou classe a cada exemplo de entrada. Por exemplo, classificar e-mails em "spam" ou "não-spam".

- Regressão: O modelo deve prever um valor contínuo com base nos dados de entrada. Por exemplo, prever o preço de uma casa com base em suas características.

O Aprendizado Não Supervisionado (UL - Unsupervised Learning) é outra categoria de técnicas de ML. Nesse tipo de aprendizado, o modelo é treinado em um conjunto de dados não rotulados, ou seja, os rótulos ou saídas desejadas não estão disponíveis para o modelo durante o treinamento.

O objetivo do UL é encontrar padrões e estruturas ocultas nos dados de entrada sem a necessidade de rótulos prévios. Isso pode ser útil para descobrir grupos (clusters) de amostras semelhantes ou para reduzir a dimensionalidade dos dados para visualização ou compressão.

Algumas das principais tarefas de UL incluem:

- Agrupamento (Clustering): O modelo deve agrupar amostras similares em grupos (clusters), onde cada cluster representa um grupo de amostras que compartilham características semelhantes.

- Redução de Dimensionalidade: O modelo deve reduzir a quantidade de recursos ou características dos dados enquanto preserva as informações importantes. Isso é útil para visualizar dados em gráficos de duas ou três dimensões.

É importante ressaltar que, em algumas situações, é possível combinar técnicas de Aprendizado Supervisionado e Não Supervisionado, como na aprendizagem semi-supervisionada, onde uma parte dos dados é rotulada e outra parte não é. O Aprendizado Supervisionado e o Aprendizado Não Supervisionado são complementares e têm aplicações em diversas áreas, permitindo que os modelos aprendam a partir de diferentes tipos de dados e atendam a diferentes objetivos.

13.3 - Camadas e Arquiteturas

Em DL, as camadas e arquiteturas referem-se à estrutura e organização das redes neurais artificiais (ANNs) ou outros modelos de DL. Vamos detalhar cada um desses conceitos:

Camadas

Uma rede neural é composta por várias camadas de neurônios interconectados. Cada camada possui um conjunto de neurônios que recebem entradas, realizam um processamento e produzem saídas. As camadas são organizadas em uma sequência, onde a saída de uma camada serve como entrada para a próxima.

As principais camadas em uma rede neural são:

- Camada de Entrada: Recebe os dados brutos de entrada para o modelo. Cada neurônio na camada de entrada representa um recurso ou característica do dado de entrada.

- Camadas Ocultas : As camadas ocultas (hidden layers) são camadas intermediárias entre a camada de entrada e a camada de saída, que realizam uma transformação não linear das suas entradas. Essas camadas são responsáveis por aprender representações mais abstratas e complexas dos dados.

- Camada de Saída: É a última camada da rede e produz a saída final do modelo. O número de neurônios nessa camada depende do tipo de tarefa que o modelo está realizando. Por exemplo, em uma tarefa de classificação binária, pode haver um neurônio na camada de saída que indica a probabilidade de pertencer a uma das classes.

Arquiteturas

A arquitetura de uma rede neural se refere à organização e configuração das camadas e neurônios na rede. Existem várias arquiteturas de redes neurais, cada uma com suas características e usos específicos. Algumas das arquiteturas mais comuns incluem:

- Redes Neurais de Propagação Direta (FNN - Feedforward Neural Network): Essa é a arquitetura mais simples, onde os dados fluem apenas em uma direção, da camada de entrada para a camada de saída. Não há conexões de retroalimentação.

- Redes Neurais Convolucionais (CNNs - Convolutional Neural Networks): Essa arquitetura é amplamente usada em tarefas de visão computacional. Ela possui camadas de convolução que ajudam a detectar padrões locais nas imagens, seguidas por camadas de agrupamento (pooling) para reduzir a dimensionalidade e, em seguida, camadas totalmente conectadas para fazer a classificação final.

- Redes Neurais Recorrentes (RNNs - Recurrent Neural Networks): Essa arquitetura é usada para lidar com sequências de dados, como texto ou séries temporais. As RNNs possuem conexões de retroalimentação, o que lhes permite manter informações de estados anteriores e processar sequências de dados de forma eficaz.

- Redes Neurais Generativas (GANs - Generative Adversarial Networks): Essa arquitetura é usada para gerar dados sintéticos que se assemelham a um conjunto de dados original. GANs possuem um gerador e um discriminador, que são treinados em conjunto para melhorar a qualidade das amostras geradas.

Essas são apenas algumas das arquiteturas comuns de redes neurais. Existem muitas outras arquiteturas e variações que são utilizadas em diferentes tarefas e aplicações de DL. A escolha da arquitetura adequada é crucial para alcançar o desempenho desejado em uma determinada tarefa de ML.

13.4 - Frameworks e Bibliotecas

Frameworks e bibliotecas são ferramentas essenciais no campo do ML e DL, pois oferecem uma infraestrutura e um conjunto de funcionalidades que facilitam o desenvolvimento, treinamento e implantação de modelos.

Um Framework é um conjunto abrangente de ferramentas, bibliotecas e APIs que fornecem uma estrutura de trabalho para desenvolver aplicativos e modelos de ML. Os frameworks de ML e DL geralmente incluem uma variedade de módulos que abrangem desde a manipulação de dados até a implementação de algoritmos complexos de ML.

Alguns dos frameworks mais populares e amplamente utilizados incluem:

- TensorFlow: Desenvolvido pelo Google, o TensorFlow é uma das bibliotecas de DL mais populares e poderosas, oferecendo uma flexibilidade excepcional, é amplamente usado para construir modelos de redes neurais.

- PyTorch: Criado pelo Facebook, o PyTorch é outro framework de DL popular. Ele é conhecido por sua simplicidade e facilidade de uso, tornando-o uma escolha popular para pesquisadores e desenvolvedores.

- Keras: Embora o Keras seja frequentemente considerado como uma API "user-friendly" de alto nível para TensorFlow, a partir da versão 2.0 do TensorFlow foi incorporado como parte do próprio TensorFlow, facilitando o desenvolvimento de modelos com uma sintaxe intuitiva.

- Scikit-Learn: O Scikit-Learn é uma biblioteca de ML em Python que fornece ferramentas simples e eficientes para análise de dados e modelagem estatística, sendo amplamente usado para tarefas de ML supervisionado e não supervisionado.

As bibliotecas são conjuntos de funções e algoritmos que são projetados para realizar tarefas específicas em ML e DL. Diferentemente dos frameworks, as bibliotecas podem ser mais focadas em tarefas específicas e podem ser usadas de forma independente ou em conjunto com um framework.

Alguns exemplos de bibliotecas populares em ML e DL incluem:

- NumPy: É uma biblioteca fundamental para computação numérica em Python. É amplamente usada para trabalhar com matrizes e vetores, que são a base para muitas operações em ML.

- Pandas: É uma biblioteca poderosa para análise de dados em Python. Ela permite a manipulação, limpeza e organização de dados de forma eficiente.

- Matplotlib e Seaborn: São bibliotecas de visualização de dados em Python. Elas permitem a criação de gráficos e visualizações informativas para entender e comunicar os resultados do ML.

- NLTK (Natural Language Toolkit): É uma biblioteca para processamento de linguagem natural (NLP) em Python. Ela fornece ferramentas para trabalhar com texto e realizar tarefas de NLP, como tokenização, lematização e análise de sentimentos.

Essas são apenas algumas das muitas frameworks e bibliotecas disponíveis em ML e DL, e sua escolha dependerá do tipo de tarefa que está sendo realizada e das preferências do desenvolvedor. A combinação certa pode facilitar significativamente o processo de desenvolvimento de modelos de ML e torná-lo mais eficiente e produtivo.

13.5 - Hardware

O hardware diferenciado desempenha um papel fundamental na viabilidade e eficácia do DL no ML.

A complexidade computacional das redes neurais profundas requer poder de processamento massivo, e as GPUs (Unidades de Processamento Gráfico) e, em alguns casos, TPUs (Unidades de Processamento de Tensor), oferecem aceleração significativa para treinamento e inferência de modelos.

Essas arquiteturas especializadas permitem a paralelização eficiente de cálculos, acelerando o processo de experimentação e desenvolvimento de modelos.

Além disso, a escalabilidade do hardware diferenciado é crucial para lidar com conjuntos de dados cada vez maiores.

A busca contínua por inovações em hardware, como chips específicos para tarefas de IA, destaca a importância de um ecossistema de hardware robusto para impulsionar o campo do DL e suas aplicações em uma variedade de setores, desde a medicina até a indústria automobilística.

- Unidades de Processamento Gráfico (GPUs - Graphics Processing Units): As GPUs são amplamente utilizadas para acelerar o treinamento de modelos de DL. Elas são altamente eficientes em realizar operações matriciais e paralelizar cálculos, acelerando o processamento em várias ordens de magnitude em comparação com CPUs tradicionais.

- Unidades de Processamento Tensorial (TPUs - Tensor Processing Units): As TPUs são aceleradores de hardware projetados pelo Google para acelerar o treinamento e inferência de modelos de DL. Elas oferecem um desempenho ainda maior em comparação com GPUs para tarefas específicas de DL.

- Quantização e Compactação: Para aplicativos de ML em dispositivos com recursos limitados, como smartphones e sistemas embarcados, técnicas de quantização e compactação de modelos são usadas para reduzir o tamanho e a complexidade dos modelos, tornando-os adequados para implantação em hardware com poucos recursos.

- Computação em Nuvem (Cloud Computing): Plataformas de computação em nuvem oferecem a capacidade de escalonar recursos de computação sob demanda, permitindo o treinamento e implantação de modelos em grande escala.

- Computação de Borda (Edge Computing): Em cenários de IoT (Internet das Coisas) e sistemas embarcados, o uso de computação de borda permite a execução de inferência de modelos diretamente em dispositivos locais, evitando a necessidade de enviar dados para processamento em nuvem.

- Aceleradores de Hardware Específicos: Além de GPUs e TPUs, existem aceleradores de hardware especializados para tarefas específicas de ML, como ASICs - Application Specific Integrated Circuits (Circuitos Integrados Específicos de Aplicação) e FPGAs - Field Programmable Gate Arrays (Matrizes de Portas Programáveis de Campo).

O desenvolvimento de hardware e a melhoria contínua das tecnologias são fundamentais para superar os desafios em ML e DL, permitindo a criação e implantação eficiente de modelos cada vez mais poderosos e sofisticados.

13.6 - Desafios

O DL, apesar de suas conquistas notáveis, enfrenta desafios significativos. Um deles é a necessidade de grandes volumes de dados para treinar modelos complexos, o que nem sempre está disponível, especialmente em domínios específicos.

Além disso, a complexidade desses modelos pode tornar o treinamento demorado e exigir hardware poderoso, aumentando os custos computacionais.

A interpretabilidade também é um desafio, uma vez que redes profundas muitas vezes operam como "caixas-pretas" difíceis de entender.

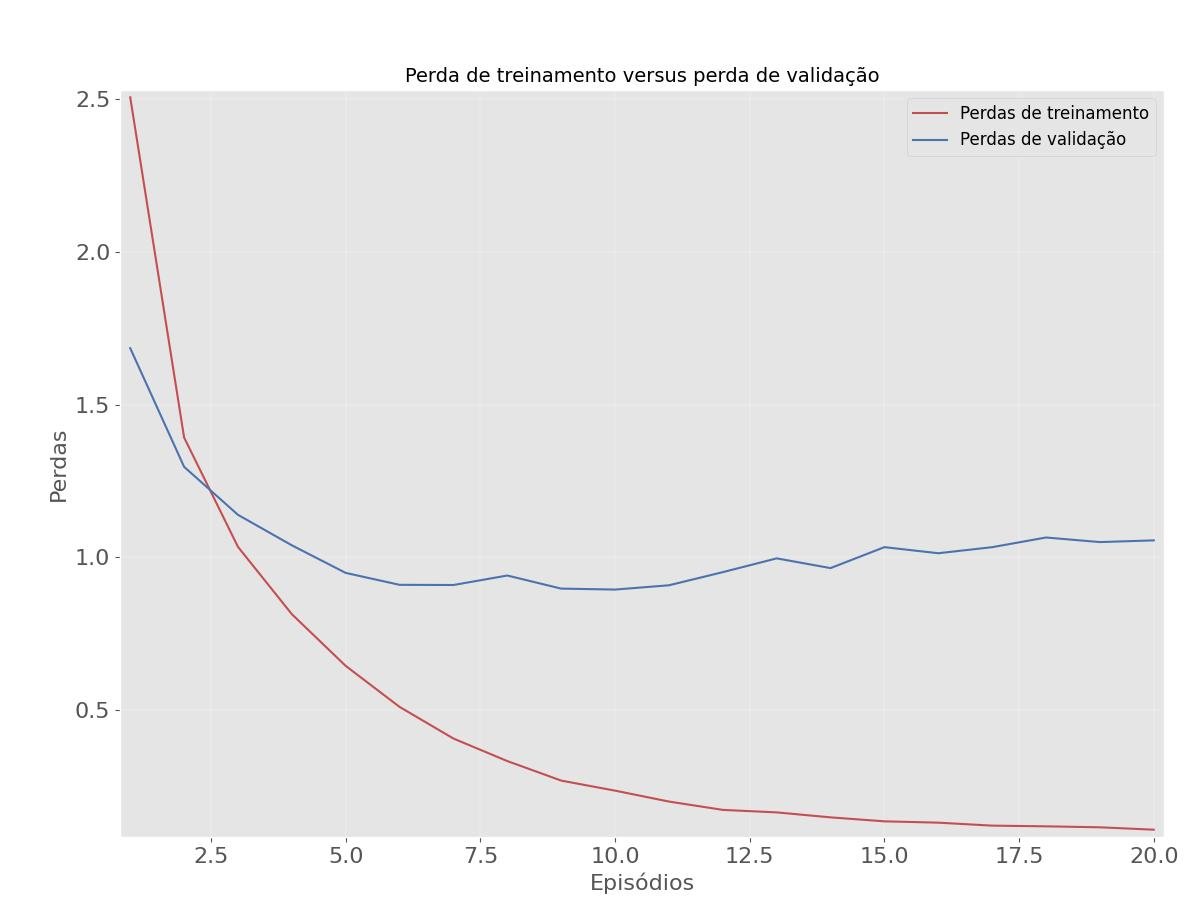

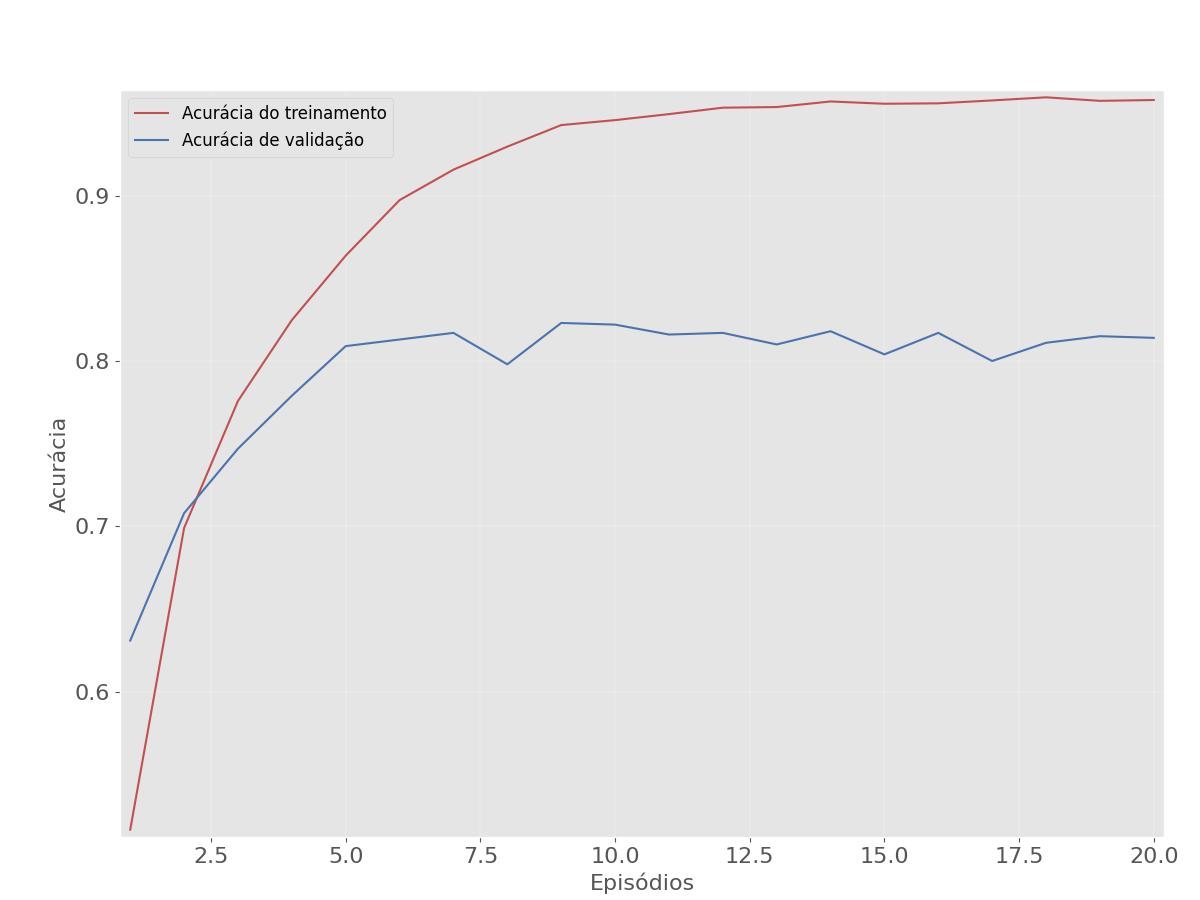

Lidar com o sobreajuste (Overfitting), a transferência de aprendizado e a adaptação a mudanças de conceito são outras questões críticas.

A ética e a privacidade também surgem como preocupações, já que modelos podem perpetuar preconceitos e lidar com dados sensíveis.

Superar esses desafios é fundamental para aproveitar todo o potencial do DL de forma eficaz e responsável.

- Disponibilidade e Qualidade dos Dados: Um dos maiores desafios no ML é a disponibilidade de dados de treinamento de alta qualidade e quantidade suficiente. Dados insuficientes, ruidosos ou desbalanceados podem afetar negativamente o desempenho dos modelos.

- Sobreajuste (Overfitting) e Subajuste (Underfitting): O sobreajuste ocorre quando o modelo se ajusta muito aos dados de treinamento e não generaliza bem para novos dados. Já o subajuste acontece quando o modelo é muito simples e não consegue aprender os padrões presentes nos dados. Encontrar o equilíbrio certo entre esses dois extremos é um desafio.

- Interpretabilidade do Modelo: Modelos de ML e DL podem ser complexos e difíceis de interpretar. Em muitas aplicações, é importante que os modelos possam fornecer explicações ou justificativas para suas previsões.

- Tempo de Treinamento e Inferência: Modelos de DL, especialmente aqueles com muitos parâmetros, podem requerer um tempo significativo de treinamento e inferência, especialmente em hardware com recursos limitados.

- Transferência de Aprendizado e Domínio Específico: Aplicar transferência de aprendizado com sucesso entre domínios diferentes pode ser um desafio, pois os padrões aprendidos em uma tarefa ou domínio nem sempre são facilmente transferíveis para outros.

- Ética e Viés dos Modelos: Garantir que os modelos sejam justos e imparciais em suas previsões é um desafio importante, pois eles podem refletir e até mesmo ampliar preconceitos presentes nos dados de treinamento.

13.7 - Keras

O Keras é uma biblioteca de Aprendizado Profundo (DL - Deep Learning) versátil e amigável que facilita a criação e o treinamento de redes neurais, de código aberto e alto nível.

Sua flexibilidade, simplicidade, facilidade de uso e integração com bibliotecas populares, sendo executada sobre o TensorFlow, o Theano e o CNTK, a tornaram uma escolha popular para muitos projetos de aprendizado de máquina (ML) e DL, permitindo que os desenvolvedores construam, treinem e avaliem redes neurais de maneira eficaz.

As redes neurais comportam diferentes arquiteturas usando modelos sequencial ou funcional e dispondo de camadas de inicio, ocultas e fim próprias para uso com as diferentes arquiteturas.

Aqui estão alguns pontos importantes sobre o Keras:

- Simplicidade e Facilidade de Uso: Uma das principais vantagens do Keras é a sua simplicidade. Ele oferece uma API de alto nível que facilita a construção e o treinamento de redes neurais. Os desenvolvedores podem criar modelos de redes neurais com poucas linhas de código.

- Portabilidade: O Keras é uma API de alto nível que pode ser executada sobre diferentes backends, como TensorFlow, Theano e CNTK. Isso oferece uma flexibilidade significativa, permitindo que os desenvolvedores escolham a melhor biblioteca para suas necessidades.

- Ampla Comunidade e Documentação: O Keras tem uma comunidade ativa de desenvolvedores e uma ampla base de usuários. Isso resulta em uma abundância de recursos, tutoriais e documentação disponíveis para ajudar os iniciantes e profissionais a tirar o máximo proveito da biblioteca.

- Diferentes Arquiteturas de Redes Neurais: O Keras oferece uma variedade de arquiteturas de rede neural, incluindo arquiteturas convolucionais (CNNs), para tarefas de visão computacional, recorrentes (RNNs), para processamento de sequências, generativas (GANs), e outras.

- Modelos Sequenciais e Funcionais: O Keras suporta dois tipos principais de modelos: sequenciais e funcionais. Modelos sequenciais são mais simples e adequados para redes neurais em que a informação flui de forma linear da entrada para saída. Modelos funcionais são mais flexíveis e podem representar arquiteturas mais complexas, com múltiplas entradas e saídas.

- Camadas Especializadas para as Arquiteturas: O Keras oferece suporte a vários tipos de classes de camadas, como camadas densas, achatadoras, em lote, para desistência, de ativação, entre outras.

- Integração com TensorFlow: Desde a versão 2.0 do TensorFlow, o Keras foi adotado como a API de alto nível padrão para construção de modelos de aprendizado profundo. Isso significa que o Keras é uma parte integral do ecossistema TensorFlow.

13.7.1 - Modelos Sequenciais e Funcionais

Na construção de redes neurais com o Keras, os desenvolvedores têm à disposição dois principais paradigmas de modelagem: Modelos Sequenciais e Modelos Funcionais.

Os Modelos Sequenciais são ideais para tarefas em que a informação flui de maneira linear de uma camada para a próxima, proporcionando uma abordagem simples e direta na construção de redes.

- Fluxo Linear de Camadas: São a escolha ideal quando você tem uma rede neural em que a informação flui de forma linear, passando por uma série de camadas, uma após a outra. Isso é comum em arquiteturas simples e clássicas, como redes feedforward.

- Construção Simples: Crie um modelo sequencial instanciando e adicionando camadas uma após a outra. A ordem em que você adiciona as camadas define a ordem do fluxo de dados na rede.

Aqui está um exemplo de criação de um Modelo Sequencial em Keras:

from keras.models import Sequential

from keras.layers import Dense

modelo = Sequential()

modelo.add(Dense(32, input_shape=(784,)))

modelo.add(Dense(64, activation='relu'))

modelo.add(Dense(10, activation='softmax'))Neste exemplo, criamos um Modelo Sequencial com três camadas, onde a primeira camada tem 32 unidades, a segunda tem 64 unidades com ativação ReLU e a terceira tem 10 unidades com ativação softmax para classificação.

Por outro lado, Modelos Funcionais oferecem uma flexibilidade excepcional, permitindo a criação de arquiteturas complexas e personalizadas, com múltiplas entradas e saídas, conexões não lineares entre camadas, e compartilhamento de camadas.

- Arquiteturas Complexas e Conexões Não Lineares: Modelos Funcionais são mais flexíveis e adequados para arquiteturas complexas, como redes com múltiplas entradas ou saídas, conexões não lineares entre camadas e compartilhamento de camadas.

- Construção Personalizada: Para criar um Modelo Funcional, você cria instâncias das camadas de forma independente e, em seguida, conecta essas camadas especificando as entradas e saídas desejadas. Isso permite a criação de arquiteturas altamente personalizadas.

Aqui está um exemplo de criação de um Modelo Funcional em Keras:

from keras.layers import Input, Dense

from keras.models import Model

# Definindo as entradas

dados_entrada = Input(shape=(784,))

# Criando camadas e conectando-as

escondido_1 = Dense(32, activation='relu')(dados_entrada)

escondido_2 = Dense(64, activation='relu')(escondido_1)

output = Dense(10, activation='softmax')(escondido_2)

# Criando o modelo

modelo = Model(inputs=dados_entrada, outputs=output)Neste exemplo, começamos definindo as entradas, criando camadas independentes e conectando-as para construir uma arquitetura personalizada. Isso é útil quando você precisa criar redes mais complexas, como redes siamesas, redes com múltiplas entradas ou saídas, ou qualquer arquitetura não linear.

Ambos os modelos desempenham um papel crucial no desenvolvimento de redes neurais profundas, adaptando-se a uma variedade de tarefas e requisitos de modelagem.

Em resumo, Modelos Sequenciais são ideais para arquiteturas de rede neural com fluxo linear de camadas, enquanto Modelos Funcionais oferecem flexibilidade para criar arquiteturas complexas e personalizadas, com conexões não lineares entre camadas, múltiplas entradas e saídas, entre outros. A escolha entre eles depende da natureza do seu problema e da arquitetura da rede que você deseja construir.

13.7.2 - Redes Neurais Convolucionais e Recorrentes

Redes neurais são modelos de aprendizado de máquina fortemente influenciados pela estrutura e funcionamento do cérebro humano. Elas são compostas por camadas de unidades interconectadas, chamadas de neurônios artificiais ou unidades de processamento. Essas redes são projetadas para processar informações e aprender a partir de dados, tornando-as poderosas para uma ampla gama de tarefas de aprendizado de máquina, como classificação, regressão, processamento de linguagem natural e visão computacional.

O funcionamento de uma rede neural envolve a passagem de dados através das camadas, onde cada neurônio realiza cálculos ponderados e aplica funções de ativação. Durante o treinamento, as conexões entre os neurônios, chamadas de pesos, são ajustadas para minimizar o erro entre as previsões do modelo e os dados de treinamento. Esse processo de ajuste de pesos é realizado por algoritmos de otimização, como o gradiente descendente.

Redes neurais podem variar em complexidade, desde simples redes feedforward com uma única camada oculta até arquiteturas profundas com muitas camadas e milhões de neurônios. O sucesso das redes neurais em tarefas complexas é atribuído, em parte, ao seu poder de representação e à capacidade de aprender características relevantes diretamente dos dados.

CNNs

As Redes Neurais Convolucionais (CNNs - Convolutional Neural Networks) são amplamente utilizadas para tarefas de visão computacional, como reconhecimento de imagens, detecção de objetos e segmentação de imagens.

São algoritmos de DL que recebem imagens como entrada, impondo importância às características (features), baseado-se nos pesos (weights) e vieses (biases) definidos pelos aspectos da rede, para que o classificador possa distinguir as imagens.

A arquitetura de uma CNN é baseada nos padrões dos neurônios de um cérebro humano, onde neurônios respondem individualmente à estímulos em uma área específica do campo visual chamada de campo receptor, e um conjunto desses campos interpretam a imagem.

O Keras oferece suporte completo para a criação e treinamento de CNNs.

Aqui estão alguns recursos e camadas específicas do Keras para CNNs:

- Camada Conv2D: Esta camada é usada para realizar convoluções 2D em dados de entrada, como imagens. Você pode especificar o número de filtros, o tamanho do kernel e a função de ativação.

- Camada MaxPooling2D: Essa camada é usada para realizar operações de max pooling 2D para reduzir a dimensionalidade dos mapas de características.

- Camada Flatten: Após as camadas de convolução e pooling, é comum usar uma camada de achatamento (flatten) para transformar os dados em um vetor unidimensional.

- Camada Dense: Você pode adicionar camadas totalmente conectadas (Dense) para realizar a classificação ou regressão com base nas características extraídas pela CNN.

- Camada Dropout: Camadas de dropout reduzem o risco de sobreajuste (overfitting).

- Camada BatchNormalization: Camadas de normalização por lotes estabilizam o treinamento e aceleram a convergência, reduzindo o risco de sobreajuste.

- Camada Activation: Camadas de ativação aplicam funções não lineares, permitindo que a rede modele relações complexas nos dados, como a classificação, regressão, etc, e que a rede seja capaz de aprender a partir de dados, tornando-as poderosas para tarefas de aprendizado, como detecção de objetos, segmentação de imagens, etc, e reduzindo o risco de sobreajuste.

- Transfer Learning: O Keras facilita o uso de modelos pré-treinados para transfer learning. Você pode importar arquiteturas populares, como VGG16, ResNet, Inception, etc., e ajustá-las para suas tarefas específicas.

Redes Neurais Recorrentes

As Redes Neurais Recorrentes (RNNs - Recurrent Neural Networks) são amplamente utilizadas em redes neurais profundas, em tarefas que envolvem dados sequenciais, como séries temporais, processamento de linguagem natural (NLP), classificação e emparelhamento de texto, verificação de rosto, etc.

O Keras suporta RNNs e oferece camadas específicas para trabalhar com sequências.

Alguns recursos relacionados a RNNs no Keras incluem:

- Camada SimpleRNN, LSTM e GRU: O Keras oferece várias camadas de RNN, incluindo SimpleRNN (RNN simples), LSTM (Long Short-Term Memory) e GRU (Gated Recurrent Unit), que podem ser usadas para modelar sequências de dados.

- Bidirectional RNNs: Você pode criar RNNs bidirecionais para capturar informações de contexto em ambas as direções das sequências.

- Embedding Layers: Para tarefas de NLP, o Keras oferece camadas de embedding que podem ser usadas para converter palavras em vetores densos.

13.7.3 - Outros tipos de modelos

Além de CNNs e RNNs, o Keras suporta uma ampla variedade de outras arquiteturas de redes neurais e tipos de modelos, incluindo:

- Redes Generativas Adversariais (GANs): O Keras facilita a criação de GANs para tarefas de geração de imagens e dados.

- Redes Siamesas: O Keras permite a construção de redes siamesas para tarefas de comparação, como verificação de rosto e emparelhamento de texto.

- Redes Residuais (ResNets): O Keras suporta a criação de arquiteturas de rede com blocos residuais para melhorar o treinamento de redes profundas.

- Redes Recorrentes Convolucionais (CRNs): Para tarefas que envolvem dados de séries temporais e sequências de dados, você pode combinar camadas convolucionais e recorrentes em CRNs.

Essas são apenas algumas das arquiteturas de redes neurais que o Keras suporta. A biblioteca é altamente versátil e permite a construção de uma ampla variedade de modelos para diferentes tipos de tarefas de aprendizado de máquina e deep learning.

13.7.4 - Camadas do Keras

Camada Conv2

Conv2D é uma camada de convolução bidimensional usada em redes neurais convolucionais (CNNs) para processar dados de imagem e extrair características locais.

Parâmetros

Através dos parâmetros são definidos os números de filtros, o tamanho do filtro e a função de ativação.

- filters: Número de filtros (ou kernels) a serem aplicados na convolução. Cada filtro é uma janela deslizante que percorre a imagem de entrada para extrair características locais. Quanto mais filtros, mais características a camada pode aprender.

- kernel_size: Tamanho dos filtros. É especificado como uma tupla, como (3, 3) para filtros de 3x3. O tamanho do filtro determina a área da imagem que ele analisa.

- strides: O passo com que o filtro se move pela imagem durante a convolução. Um valor de (1, 1) indica que o filtro se move uma posição por vez, enquanto (2, 2) moverá o filtro duas posições por vez.

- padding: Define como lidar com os limites da imagem. Pode ser 'valid' (sem preenchimento) ou 'same' (preenchimento para manter a mesma saída).

- activation: A função de ativação aplicada após a convolução. ReLU (Unidade Linear Retificada) é comumente usada, mas você pode escolher outras funções, como 'sigmoid' ou 'tanh'.

A camada Conv2D realiza uma operação de convolução bidimensional na imagem de entrada.

Passos

Os passos para construir a camada Conv2D são:

- A imagem de entrada é dividida em pequenas regiões, onde cada região tem o mesmo tamanho que o filtro especificado.

- Cada filtro é aplicado a uma dessas regiões. Para cada região, o filtro realiza uma multiplicação elementar entre seus valores e os valores correspondentes na região da imagem de entrada.

- O resultado das multiplicações é somado, produzindo um único valor. Esse valor é colocado em um novo mapa de características na posição correspondente.

- O filtro é movido pela imagem de entrada de acordo com o valor dos strides, e o processo é repetido para criar o mapa de características resultante.

Mapas de Características

Os mapas de características resultantes da convolução sao chamados de maps, e são usados como entrada para outras camadas.

- Uma camada Conv2D cria múltiplos mapas de características.

- Cada mapa de características captura diferentes características locais da imagem.

- Esses mapas de características são usados como entrada para camadas subsequentes na rede neural.

- Após a convolução, a camada Conv2D aplica a função de ativação especificada, como ReLU. Isso introduz não linearidade na camada, permitindo que a rede aprenda representações mais complexas dos dados.

As camadas Conv2D são fundamentais para CNNs, permitindo que a rede detecte bordas, texturas, padrões e recursos mais complexos em imagens, desempenhando um papel crítico na extração de características relevantes e na capacidade da rede de realizar tarefas de visão computacional, como classificação de objetos, detecção de rostos e segmentação de imagens.

Camada MaxPooling2D

A camada MaxPooling2D no Keras é uma camada de pooling bidimensional usada em redes neurais convolucionais (CNNs) para reduzir a dimensionalidade dos mapas de características e, ao mesmo tempo, preservar as características mais proeminentes.

Parâmetros

Através dos parâmetros são definidos o tamanho da janela de pooling, o passo com que a janela de pooling se move e a maneira de lidar com os limites dos mapas de características.

- pool_size: Tamanho da janela de pooling. É especificado como uma tupla, como (2, 2), indicando uma janela de 2x2 que é deslizada pelos mapas de características.

- strides: O passo com que a janela de pooling se move pelos mapas de características. Um valor de (1, 1) indica que a janela se move uma posição por vez, enquanto (2, 2) moverá a janela duas posições por vez.

- padding: Define como lidar com os limites dos mapas de características. Pode ser 'valid' (sem preenchimento) ou 'same' (preenchimento para manter a mesma saída).

Funcionamento

A camada MaxPooling2D realiza uma operação de pooling bidimensional na saída da camada de convolução.

Aqui estão os passos principais:

- A camada MaxPooling2D divide a saída da camada de convolução em pequenas regiões, onde cada região tem o mesmo tamanho que a janela de pooling especificada.