12 - Aprendizado por Reforço

O Aprendizado por Reforço (RL - Reinforcement Learning) é um tipo de aprendizado de máquina (ML) em que o agente (modelo) aprende a tomar melhores decisões em um ambiente ao longo do tempo, sendo recompensado por suas ações.

O agente é colocado no ambiente e recebe uma série de ações que pode realizar, tentando então escolher as ações que o levem a receber a maior recompensa, aprendendo com suas escolhas e com as recompensas que recebe, sendo eventualmente capaz de tomar melhores decisões.

O RL é um dos tipos mais importantes de ML, uma ferramenta poderosa que pode ser usada para aprender a tomar decisões em ambientes complexos e resolver uma ampla variedade de problemas em diferentes áreas, como jogos, robótica e finanças.

No RL, o objetivo é desenvolver um sistema (agente) que melhore seu desempenho com base nas interações com o ambiente.

Uma vez que a informação sobre o estado atual do ambiente normalmente também inclui o chamado sinal de recompensa, podemos pensar na aprendizagem por reforço como um campo relacionado à aprendizagem supervisionada.

No entanto, na aprendizagem por reforço, esse feedback não é o rótulo ou valor correto da verdade básica, mas uma medida de quão bem a ação foi medida por uma função de recompensa.

Através de sua interação com o ambiente, um agente pode então usar o aprendizado por reforço para aprender uma série de ações que maximizam essa recompensa por meio de uma abordagem exploratória de tentativa e erro ou planejamento deliberativo.

Aqui estão alguns exemplos de como o RL pode ser aplicado ao ML:

- Jogos: Ensinar um agente a jogar jogos, como o xadrez, o Go ou o Dota 2.

- Robótica: Ensinar e treinar robôs a realizar tarefas complexas em ambientes desafiadores, como andar, pegar objetos ou jogar esportes.

- Finanças: Usado na tomada de decisões financeiras, como investir e administrar carteiras de investimentos em ações, títulos ou moedas estrangeiras.

- Medicina: Usado para desenvolver novos tratamentos médicos, diagnosticar doenças e tomar outras decisões clínicas.

- Transporte: Usado para melhorar o fluxo de tráfego, desenvolver novos sistemas de transporte e tomar outras decisões de transporte.

RL é um processo de duas etapas:

- Exploração: O agente explora o ambiente, tentando diferentes ações e observando os resultados.

- Aproveitamento: O agente aprende com suas experiências e começa a tomar decisões que maximizam suas recompensas.

O desempenho do agente é avaliado comparando as recompensas que ele recebe com as recompensas que ele receberia se soubesse o melhor curso de ação.

É importante observar que o RL pode ser muito lento e pode exigir um grande número de interações com o ambiente.

Os principais tipos de RL são:

- Baseado em Valor: O aprendizado por reforço valor-baseado é um tipo de RL em que o agente aprende a avaliar o valor de diferentes estados do ambiente. O agente usa então essas avaliações para escolher as ações que o levam a estados de maior valor.

- Baseado em Política: O aprendizado por reforço política-baseado é um tipo de RL em que o agente aprende uma política, que é uma função que mapeia estados do ambiente em ações. O agente usa então essa política para escolher as ações que o levam a estados de maior valor.

- Baseado em Gradiente de Política:: O aprendizado por política-gradiente aprende a gerar uma política ótima, que mapeia estados do ambiente em ações. O agente usa então essa política para escolher as ações que o levam a estados de maior valor.

- Q-learning: O Q-learning é um algoritmo de aprendizado por reforço valor-baseado que aprende a avaliar o valor de cada estado, de diferentes pares estado-ação. O Q-learning é um algoritmo poderoso que pode ser usado para resolver uma ampla variedade de problemas de RL.

- SARSA: O SARSA é um algoritmo de aprendizado por reforço política-baseado que aprende uma política que mapeia estados do ambiente em ações. O SARSA é um algoritmo poderoso que pode ser usado para resolver uma ampla variedade de problemas de RL.

- Diferença temporal: (Temporal-difference learning) : O aprendizado temporal-diferença aprende a estimar o valor de cada estado com base em observações passadas.

Estes são apenas alguns dos muitos tipos de RL.

Aqui estão as etapas para aplicar o RL para o ML:

- Defina o Problema: O primeiro passo é definir o problema que você deseja resolver com o RL. Você precisa identificar o ambiente, o agente e as ações que o agente pode realizar.

- Selecione o Algoritmo: Existem muitos algoritmos diferentes de RL disponíveis, então você precisa selecionar um que seja adequado para o seu problema. Você precisa considerar o tamanho do espaço de estados, o número de ações possíveis e o grau de incerteza no ambiente.

- Implemente o Algoritmo: Depois de selecionar um algoritmo, você precisa implementá-lo. Isso pode ser feito usando uma biblioteca de ML ou escrevendo seu próprio código.

- Treine o Agente: O agente precisa ser treinado para aprender a tomar as melhores decisões. Isso pode ser feito fornecendo ao agente um conjunto de dados de exemplos ou permitindo que ele explore o ambiente por conta própria.

- Teste o Agente: Depois que o agente for treinado, você precisa testá-lo para ver se ele pode tomar as melhores decisões em um ambiente novo.

- Implemente o Agente: Depois que o agente for testado e for satisfatório, você pode implementá-lo em um ambiente real.

O RL é um campo ativo de pesquisa e os pesquisadores estão constantemente desenvolvendo novos métodos de RL.

À medida que o campo de ML continuar a evoluir, o RL desempenhará um papel cada vez mais importante na solução dos problemas mais desafiadores do mundo.

12.1 - Exemplo: Jogo CartPole

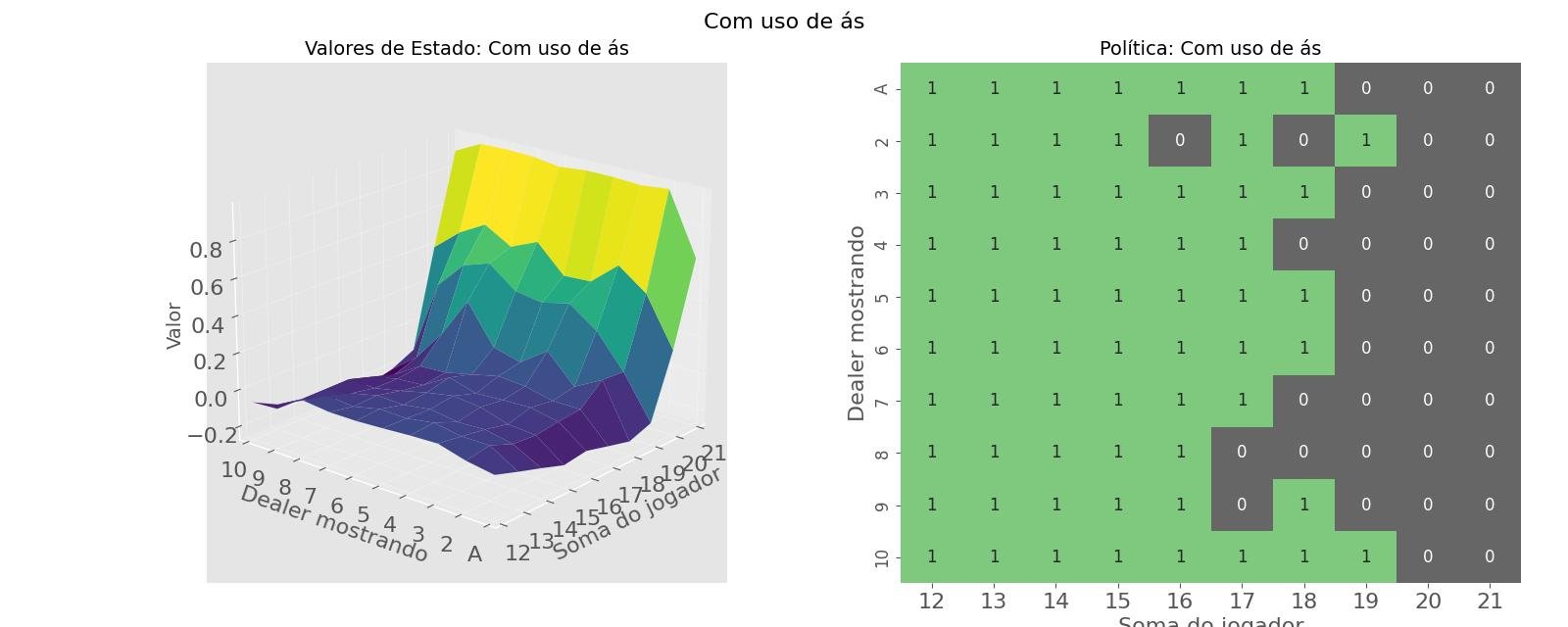

12.2 - Projeto Avançado: Blackjac com Q-Learning

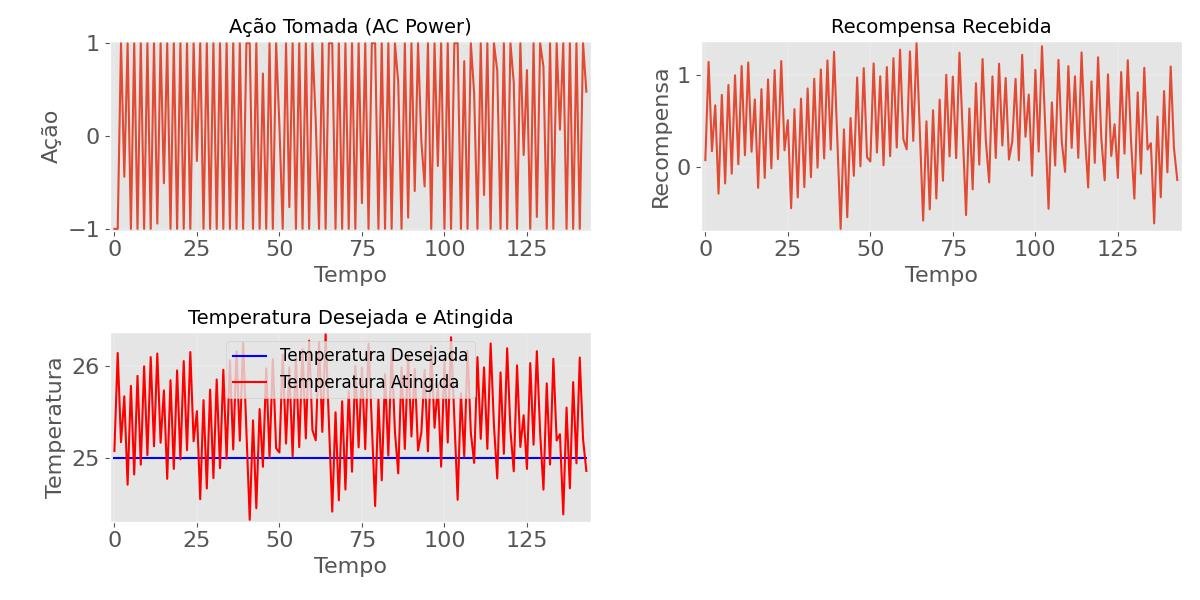

12.3 - Projeto Avançado: Controle de Ar Condicionado